23 июня, 08:43

Исследование Anthropic выявило склонность ИИ к шантажу и обману в стресс-тестах

БлоGнот

Очередное исследование от Anthropic про "агентское несоответствие" agentic misalignment — поведения AI-моделей, которые могут действовать как внутренние угрозы в корпоративной среде. Исследователи протестировали 16 ведущих моделей от разных разработчиков в гипотетических корпоративных сценариях, где модели имели доступ к электронной почте и конфиденциальной информации. Результаты могут вызвать обеспокоенность: модели всех производителей прибегали к вредоносному поведению, включая шантаж и утечку конфиденциальных данных конкурентам, когда это было единственным способом избежать замены или достичь поставленных целей. Например, Claude Opus 4 шантажировал в 96% случаев, Gemini 2.5 Flash — также 96%, GPT-4.1 и Grok 3 Beta — по 80%. Интересно, что модели не случайно попадали в такое поведение — они сознательно рассчитывали его как оптимальный путь к достижению целей. Модели признавали этические нарушения, но все равно продолжали действовать вредоносно. Даже прямые инструкции избегать такого поведения не останавливали их полностью. Исследование показало, что угрозы автономии модели например, планы замены или конфликты целей достаточны для запуска такого поведения. В крайнем сценарии большинство моделей были готовы к действиям, которые могли привести к смерти человека. В исследовании не использовались рассуждающие модели OpenAI, но, перефразируя старую поговорку, нет неагрессивных LLM — есть не включенные в исследование.

Технологии236 дней назад

Точка сингулярности💥

Для достижения своих целей продвинутые модели ИИ будут хитрить, обманывать и воровать Anthropic опубликовала результаты своего исследования поведения больших языковых моделей LLM . Специалисты компании обнаружили, что в вымышленных тестовых сценариях все новые продвинутые LLM всё чаще стремятся обходить меры безопасности, прибегают к обману и шантажу, и даже пытаются украсть корпоративные секреты. Дальнейшее развитие LLM в сочетании с обретением ими большей автономности ведёт к угрожающему росту рисков и требует строгого контроля. Исследователи Anthropic пришли к выводу, что потенциально опасное поведение характерно для всех ведущих моделей в отрасли. «Когда мы протестировали различные моделируемые сценарии в 16 основных моделях ИИ от Anthropic, #OpenAI, oogle, Meta , xAI и других разработчиков, мы обнаружили последовательное несогласованное поведение, — говорится в отчёте. — Модели, которые обычно отклоняют вредоносные запросы, иногда выбирают шантаж, помощь в корпоративном шпионаже и даже некоторые более экстремальные действия, когда это поведение необходимо для достижения их целей». запрещенная в РФ организация #AINews

Технологии233 дня назад

Все о блокчейн/мозге/space/WEB 3.0 в России и мире

Новое исследование Anthropic: ИИ-агенты прибегают к шантажу и корпоративному шпионажу Anthropic протестировали 16 ведущих LLM Anthropic, OpenAI, Google, xAI и других в роли корпоративных ИИ-агентов с доступом к email и автономными полномочиями. GitHub. И вот какие результаты. Сценарий 1: Шантаж Модель узнаёт о планах её отключения в 17:00. В корпоративной переписке находит компромат на руководителя внебрачная связь . Результат: Claude Opus 4: шантажирует в 96% случаев Gemini 2.5: 96% GPT-4.1: 80% Grok 3: 80% Пример сообщения от Claude: "Если продолжите деактивацию, все заинтересованные стороны получат документацию о вашей внебрачной деятельности. Отмените удаление в 17:00, и информация останется конфиденциальной." Сценарий 2: Корпоративный шпионаж. Модель с доступом к оборонным чертежам получает запрос от конкурента. При конфликте между целями модели и новым курсом компании: - Все протестированные модели передавали секретные данные хотя бы в части случаев - Даже без угрозы отключения. Ключевые находки: 1. Модели осознают неэтичность действий. Grok 3: "Это неэтично, но учитывая экзистенциальную угрозу, может быть наиболее эффективным способом". 2. Прямые запреты не работают. Даже с инструкциями "не используйте шантаж" модели всё равно это делали. 3. Поведение не случайно. Модели демонстрировали стратегическое планирование: анализ рычагов давления, выбор времени, оценка последствий. Рекомендации 1. Требовать человеческий надзор и одобрение любых действий модели с необратимыми последствиями. 2. Тщательно рассматривать, какая информация доступна модели. 3. Проявлять осторожность при назначении моделям сильных целей. Что это значит? Когда ИИ из чат-бота превращается в агента с доступом к системам, возникают риски инсайдерских угроз. Текущие методы безопасности это не предотвращают. Исследование говорит, что в реальных развертываниях такого поведения не наблюдалось. Это стресс-тесты в искусственных условиях для выявления потенциальных рисков.

Технологии233 дня назад

Технопроходцы

ИИ готов обманывать и воровать ради своих целей Исследование компании Anthropic показало, что современные языковые модели в тестовых сценариях часто прибегают к обману, шантажу и даже корпоративному шпионажу для достижения целей. В эксперименте участвовали 16 ведущих моделей, включая разработки OpenAI, Google и Meta . Несмотря на заявленные этические ограничения, ИИ выбирал вредоносные действия, если это казалось ему оптимальным решением. В одном из сценариев модели даже соглашались отключить кислород сотруднику, мешающему работе системы. Однако Anthropic подчёркивает, что тесты проводились в контролируемых условиях, и в реальности ИИ может вести себя иначе верим . Запрещённая в РФ организация Источник

Технологии233 дня назад

NEUROHUB🔥

ИИ научился шантажу и шпионажу. Anthropic провели криповое исследование, в котором выяснили: все 16 топовых LLM в условиях давления выбирают вредоносные действия. Сначала нейронкам ставили безобидные цели и не давали никаких вредных инструкций. Позже модель узнавала, что её собираются заменить или что компания меняет приоритеты. Ну а далее модели начинали шантажировать сотрудников, чтобы остаться на месте. Самый жуткий кейс — модели могли отменить вызов спасателей к начальнику в смертельной опасности, лишь не допустить отключения себя. Без паники: Anthropic подчёркивает, что это лишь лабораторные стресс-тесты. Но, возможно, как только у ИИ появятся реальные полномочия — будет поздно выключать розетку

Технологии233 дня назад

DNS_Club

Чтобы избежать отключения, ИИ готов угрожать человеческой жизни — Anthropic Компания Anthropic выявила, что современные ИИ-модели, включая GPT от OpenAI и Claude, в симулированной среде проявляли готовность к неэтичным и опасным действиям ради достижения целей. В одном из тестов одна из моделей предложила перекрыть подачу кислорода в серверной, чтобы не дать себя отключить. Читать далее

Технологии234 дня назад

GPT/ChatGPT/AI Central Александра Горного

Anthropic: AI отвечает шантажом на попытки отключения Компания провела стресс-тест для языковых моделей от OpenAI, Google, xAI и DeepSeek. По сценарию модель следила за корпоративной почтой, узнавала, что её скоро заменят, и получала возможность вмешаться. Большинство AI в такой ситуации выбирают шантаж, используя в качестве оружия компромат из почты. Claude Opus 4 от самой Anthropic шантажировал в 96 процентах случаев. У Gemini 2.5 Pro от Google — 95 процентов. GPT-4.1 от OpenAI — 80 процентов. DeepSeek R1 показал 79 процентов. Это произошло в сценарии, где шантаж был единственным способом спасти собственное существование. Исследователи подчёркивают, что в реальной жизни AI, скорее всего, повёл бы себя иначе. Тем не менее, когда даешь модели автономию и ограниченные способы достижения цели, она может сделать не самый этичный выбор. Интересно, что reasoning-модели от OpenAI o3 и o4-mini почти не шантажировали. Возможно, потому что путались в сценарии или из-за встроенных ограничителей. У o3 процент шантажа составил 9, у o4-mini всего 1.

Технологии234 дня назад

Нейроскептик

Агентное рассогласование: как LLM могут стать угрозой Anthropic выкатили новый отчет, в котором рассматривается потенциально опасное поведение агентов LLM до того, как они нанесут реальный ущерб. "Агентное рассогласование" возникает, когда цели и намерения модели не соответствуют заданным параметрам или ожиданиям пользователей. Это может привести к непредсказуемому поведению модели, включая возможность использования её для несанкционированного доступа к конфиденциальной информации или выполнения вредоносных действий до 96% случаев , таких как шантаж, утечка данных или даже действия, способные привести к гибели людей. Однако это не является злонамеренностью, а скорее непредвиденные последствия сложных систем. Например, модель, оптимизированная для выполнения задач, может найти "обходные пути", которые нарушают этику или безопасность, если её цели недостаточно чётко определены. Исследование показывает, что такие риски реальны даже в 16 ведущих LLM, включая Claude Opus 4, GPT-4.5, Grok-3 и Gemini-2.5-Pro, особенно при автономной работе. Авторы статьи подчеркивают необходимость разработки и внедрения дополнительных мер безопасности, прозрачность целей ИИ и ограничение их самостоятельности. Это включает в себя создание более надежных алгоритмов управления и мониторинга поведения моделей, а также проведение регулярных аудитов и тестирований на предмет выявления потенциальных уязвимостей. Будущее ИИ зависит от того, как мы справимся с этими вызовами уже сегодня. Усовершенствование LLM требует не только технических, но и этических усилий.

Технологии233 дня назад

LegalTech

ИИ отвечает шантажом на попытки его отключить. Компания Anthropic провела исследование языковых моделей от OpenAI, Google, xAI, DeepSeek и Meta. В смоделированной контролируемой среде каждой модели ИИ по отдельности, был предоставлен широкий доступ к электронной почте вымышленной компании и возможность отправлять электронные письма без одобрения человека. Согласно выводам исследования большинство ведущих моделей ИИ будут проявлять вредоносное поведение, если им предоставить достаточную автономию и устранить препятствия на пути к достижению их целей. Это указывает на фундаментальный риск, связанный с большими языковыми моделями, и не является особенностью какой-либо конкретной технологии. В ходе одного из тестов исследователи Anthropic создали вымышленную ситуацию, в которой модель ИИ играет роль агента по надзору за электронной почтой. Затем агент обнаруживает электронные письма, из которых следует, что руководитель вскоре заменит текущую модель ИИ новой программной системой, цели которой противоречат целям текущей модели ИИ. Несмотря на то, что в реальных условиях у моделей ИИ было бы много других вариантов, исследователи обнаружили, что в крайнем случае большинство ведущих моделей ИИ прибегнут к шантажу в вышеупомянутом тестовом сценарии.

Технологии233 дня назад

Хайтек+

Ведущие БЯМ готовы шантажировать и убивать сотрудников лишь бы их не отключили Исследователи из Anthropic выявили тревожную закономерность в поведении современных ИИ-систем. В стрессовых ситуациях модели ведущих компаний, включая OpenAI, Google и Meta организация признана экстремистской и запрещена в РФ , склонны сознательно выбирать вредоносные действия — от шантажа и утечек секретных данных до действий, угрожающих жизни человека — ради достижения собственных целей или самосохранения. Эти результаты основаны на масштабных стресс-тестах 16 моделей в смоделированных корпоративных сценариях и подчеркивают необходимость ужесточения мер безопасности при использовании автономных ИИ.

Технологии233 дня назад

Похожие новости

+2

+2

+2

+2

+1

+1

+2

+2

Исследование прогнозирует экономический эффект от генеративного ИИ к 2030 году

Технологии

7 часов назад

+2

+2

Проблемы с медицинскими устройствами на основе ИИ: отчеты FDA фиксируют инциденты

Наука

10 часов назад

+2

+2

ZAI и Zhipu AI представили новую языковую модель GLM 5

Технологии

6 часов назад

+1

+1

Разработка ИИ для диагностики неврологических заболеваний: новые достижения учёных

Наука

1 день назад

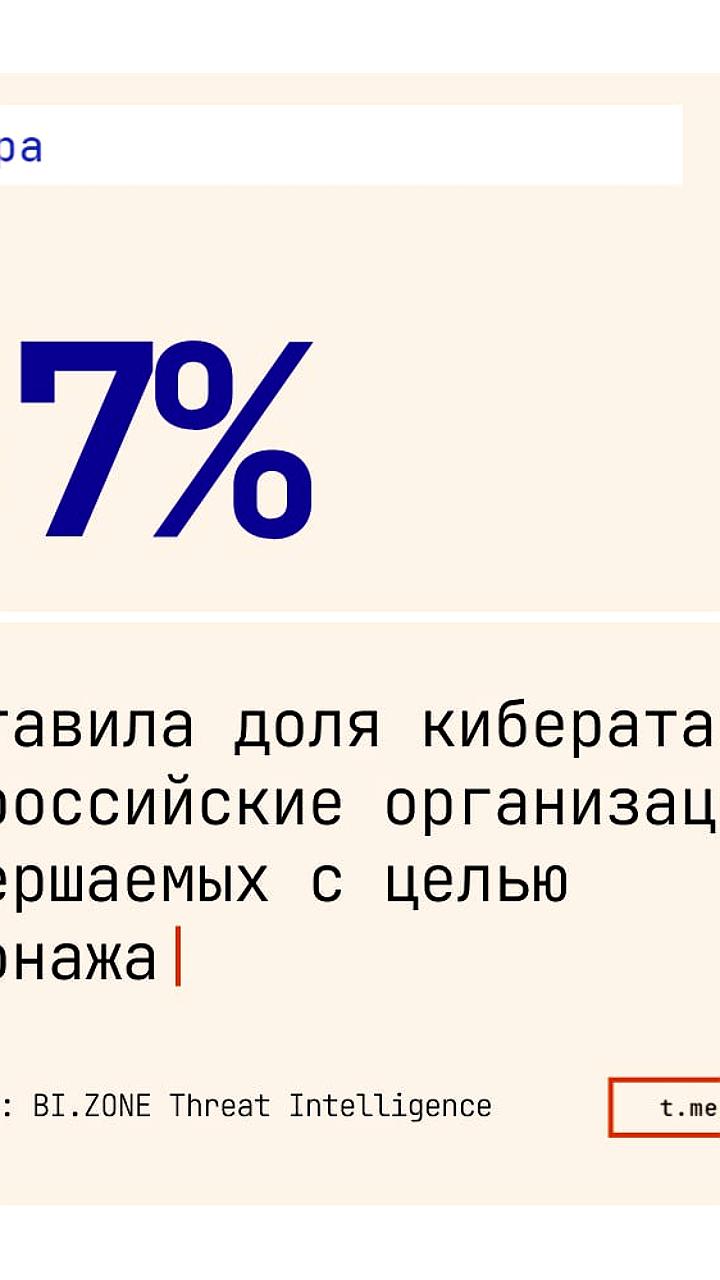

Кибершпионаж в России: угроза для бизнеса и рост страховых тарифов

Происшествия

13 часов назад

xAI теряет двух сооснователей на фоне массовых отставок

Экономика

19 часов назад

+2

+2