10 ноября, 16:23

Российские исследователи представили новый метод обучения ИИ для улучшения логического рассуждения

Physics.Math.Code

Логическое мышление как большие языковые модели научились логическим рассуждениям без больших финансовых и временных затрат Исследователи из T Bank AI Research и лаборатории Центрального университета Omut AI представили метод который позволяет развивать сложные reasoning навыки без полного переобучения своего рода точной настройке логических цепочек в уже обученной сети В основе подхода лежит не переписывание мозга а steering vectors компактные векторы регуляторы которые усиливают корректные логические шаги модели На шести математических бенчмарках метод показал сохранение 100 эффективности полного дообучения при изменении всего 0 0016 параметров 14 миллиардной модели Требования к памяти сократились с гигабайтов до сотен килобайт Скорость одного из этапов обучения увеличилась с десятков минут до секунд Logit анализ показывает усиление ключевых маркеров логических рассуждений таких как потому что следовательно правильно В связи с этим поведение LLM становится легче интерпретировать исследователям которые получают прозрачный инструмент для изучения того как именно модель рассуждает Результаты исследования протестировали на моделях Qwen и LLaMA и представили на EMNLP 2025 Steering LLM Reasoning Through Bias Only Adaptation наука math science программирование разработка IT Physics Math Code physics lib

Общество60 дней назад

Интеррос

Исследователи из лаборатории Центрального университета Omut AI и T Bank AI Research нашли способ дешевле и быстрее обучать большие языковые модели рассуждению Вместо обучения с подкреплением требующего корректировки миллиардов параметров ученые предложили использовать векторы настройки steering vectors Они работают как регуляторы громкости модель уже умеет рассуждать а векторы позволяют усилить правильные логические шаги Такой подход затрагивает лишь несколько сотен тысяч параметров и сокращает длительность одного из этапов обучения с десятков минут до считанных секунд Метод делает поведение модели более прозрачным Logit анализ показал что векторы усиливают значимость ключевых слов рассуждений потому что правильно поэтому Это помогает исследователям лучше понимать как именно модель приходит к выводу Разработку уже протестировали на языковых моделях Qwen и LLaMA Ее можно интегрировать в существующие чат боты системы проверки кода и аналитические платформы Благодаря компактности подхода обучение стало доступным не только крупным IT компаниям но и университетским лабораториям и небольшим организациям Эффективность метода подтверждена на шести международных бенчмарках по математическому рассуждению при этом качество решений сохраняется до 100 Его представили на одной из ведущих международных конференций по искусственному интеллекту Empirical Methods in Natural Language Processing EMNLP 2025 проходившей в Китае с 4 по 9 ноября Подробнее в материале Центрального университета

Общество60 дней назад

ВЕДОМОСТИ

Российские исследователи научились быстрее обучать языковые модели рассуждению Команда T Bank AI Research и лаборатория Omut AI Центрального университета разработали метод который позволяет развивать способность больших языковых моделей LLM к логическим рассуждениям без обучения с подкреплением По результатам экспериментов новый подход подтвердил эффективность на шести бенчмарках пяти тестах по математическому рассуждению семейства Qwen от Alibaba и LLaMa3 от Meta организация признана экстремистской и запрещена в РФ Разработка представлена на конференции EMNLP 2025 в китайском Сучжоу По словам авторов она позволяет сделать создание рассуждающих LLM доступнее для рынка в том числе для университетских лабораторий и небольших компаний Подробнее в материале Ведомости Инновации и технологии Freepik

Общество59 дней назад

ЦА | Новости Центральной Азии

Исследователи из T Bank AI Research и Центрального университета разработали метод который упрощает обучение больших языковых моделей логическим рассуждениям Работа была представлена на международной конференции по ИИ в Китае EMNLP 2025 Суть метода заключается в специальных векторах настройках Это компактные подсказки которые усиливают правильные логические шаги предобученной модели и корректируют ее логику не затрагивая миллиарды основных параметров Например скорость одного из этапов обучения сокращается с десятков минут до считанных секунд а необходимый для оптимизатора объем памяти сокращается с гигабайтов до сотен килобайт По данным исследования для улучшения рассуждений одной из моделей потребовалось изменить 0 0016 ее параметров что делает технологию доступной для небольших компаний и лабораторий Метод поможет быстрее создавать интеллектуальных ассистентов в разных областях например чат ботов по точным наукам помощников в программировании и аналитических ассистентов в медицине Китай Россия Искусственный интеллект Цифровые технологии centralasianow Подписаться на канал

Общество58 дней назад

Наука и университеты

Исследователи T Bank AI Research и Центрального университета представили новый метод для развития логического мышления больших языковых моделей который может использоваться даже в университетских лабораториях В нем используются компактные векторы настройки которые направляют процесс рассуждений усиливая корректные логические цепочки без полного переобучения модели За счет сокращения требований к памяти с гигабайтов до сотен килобайт и ускорения этапа процесса обучения метод может применяться и в университетских лабораториях для обучения reasoning моделей без дорогого оборудования Представьте чат бота который помогает ребенку решать задачи по математике Он знает формулы но иногда путается и перескакивает через шаги Благодаря обучению с подкреплением бот начинает рассуждать последовательно ищет ошибки в предыдущих решениях проверяет промежуточные вычисления и в итоге дает правильное решение Наш метод показывает что обучать модели рассуждать можно без изменения миллионов параметров Это открывает новый этап в развитии доступного искусственного интеллекта для бизнеса рассказывает Вячеслав Синий исследователь научной группы AI Alignment лаборатории исследований искусственного интеллекта T Bank AI Research Метод уже был представлен на одной из ведущих международных конференций в области ИИ по эмпирическим методам обработки естественного языка EMNLP 2025 в Китае Результаты исследования имеют потенциал помочь сделать языковые модели более прозрачными и объясняемыми

Общество60 дней назад

Илон Маск | Elon Musk (Tesla)

Российские исследователи продвинулись в исследовании ИИ они разработали способ научить языковые модели рассуждать быстрее и дешевле Исследователи из лаборатории Центрального университета Omut AI и T Bank AI Research предложили вместо традиционного обучения использовать обучение steering vectors маленьких подсказок которые помогают модели думать логичнее Раньше для этого применяли обучение требующее дополнительных вычислений и памяти Новый метод не требует перестраивать всю нейросеть а лишь добавляет компактные векторы настройки По сути модель уже умеет рассуждать а эти векторы помогают ей делать это увереннее и точнее экономя ресурсы Илон Маск

Общество60 дней назад

База знаний AI

В T Bank AI Research и Центральном университете разработали метод обучения рассуждающих моделей с применением Steering Vectors Steering Vectors векторы настройки это компактные подсказки которые усиливают правильные логические шаги предобученной модели Российские исследователи предлагают использовать новый подход вместо обучения с подкреплением Reinforcement Learning Как утверждается он позволяет значительно сократить количество изменяемых параметров при сопоставимом качестве По словам исследователей метод подтвердил результативность на шести бенчмарках по математическому рассуждению с сохранением качества до 100 Его протестировали на таких LLM как Qwen и LLaMA разработана Meta которая признана экстремистской и запрещена в России 100 качества полного дообучения удалось восстановить на моделях Qwen2 5 1 5B Qwen2 5 7B Qwen2 5 14B и других На Qwen2 5 14B подход с Steering Vectors показал качество сравнимое с RL обучением Объем памяти необходимый для оптимизатора сократился с 13 8 ГБ до 240 КБ Метод можно встроить в существующие пайплайны например чат боты системы проверки кода или аналитические платформы Как считают исследователи с помощью нового подхода университетские лаборатории и небольшие компании без суперкомпьютеров смогут обучать рассуждающие модели Источник www tbank ru about news 10112025 t bank ai research and central university have discovered cheaper and faster way train large language models reason

Общество59 дней назад

Похожие новости

+6

+6

+4

+4

+3

+3

+7

+7

Google внедряет новые функции ИИ в Gmail для улучшения работы с электронной почтой

Технологии

1 день назад

+6

+6

Нейробиологи подтверждают: вера в себя способствует успеху

Общество

4 часа назад

NVIDIA рассматривает возвращение старых видеокарт с новыми функциями на фоне дефицита

Технологии

1 день назад

+4

+4

Dell признает низкий интерес потребителей к ИИ-функциям в ПК

Технологии

1 день назад

+3

+3

Региональные олимпиады 2026 в Гагаузии и Якутии: старт интеллектуальных соревнований для школьников

Общество

4 часа назад

+7

+7

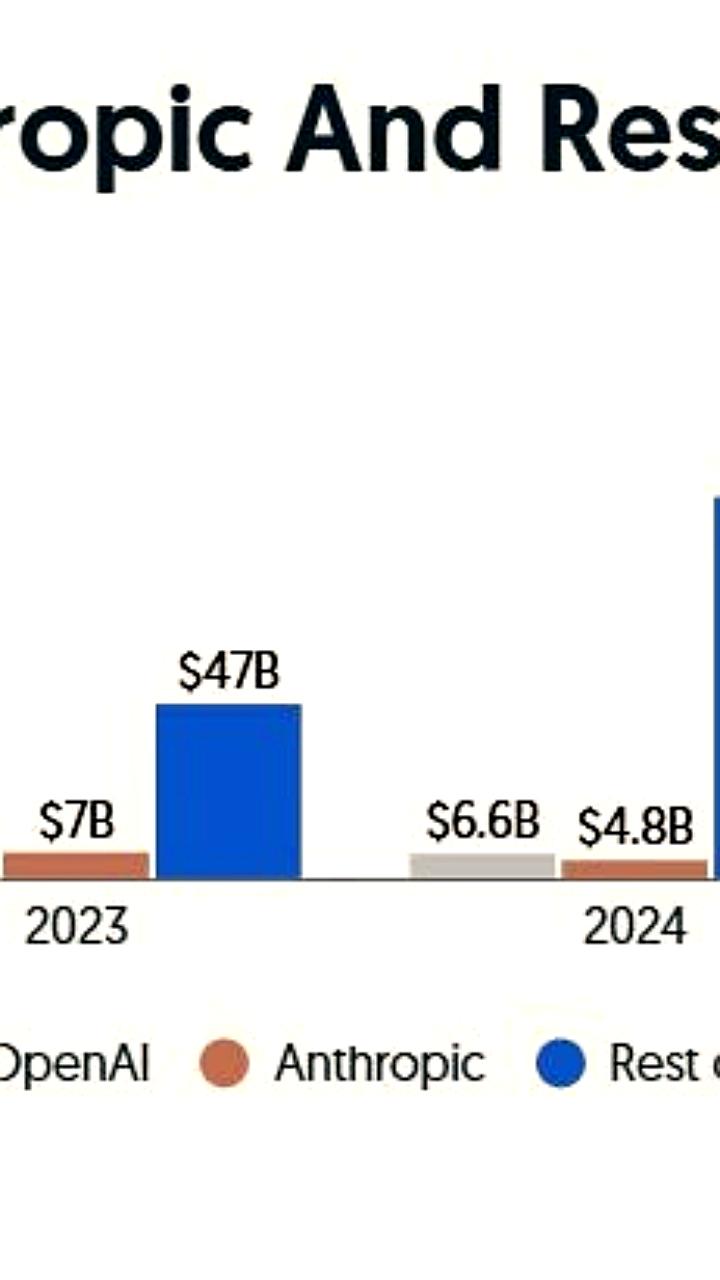

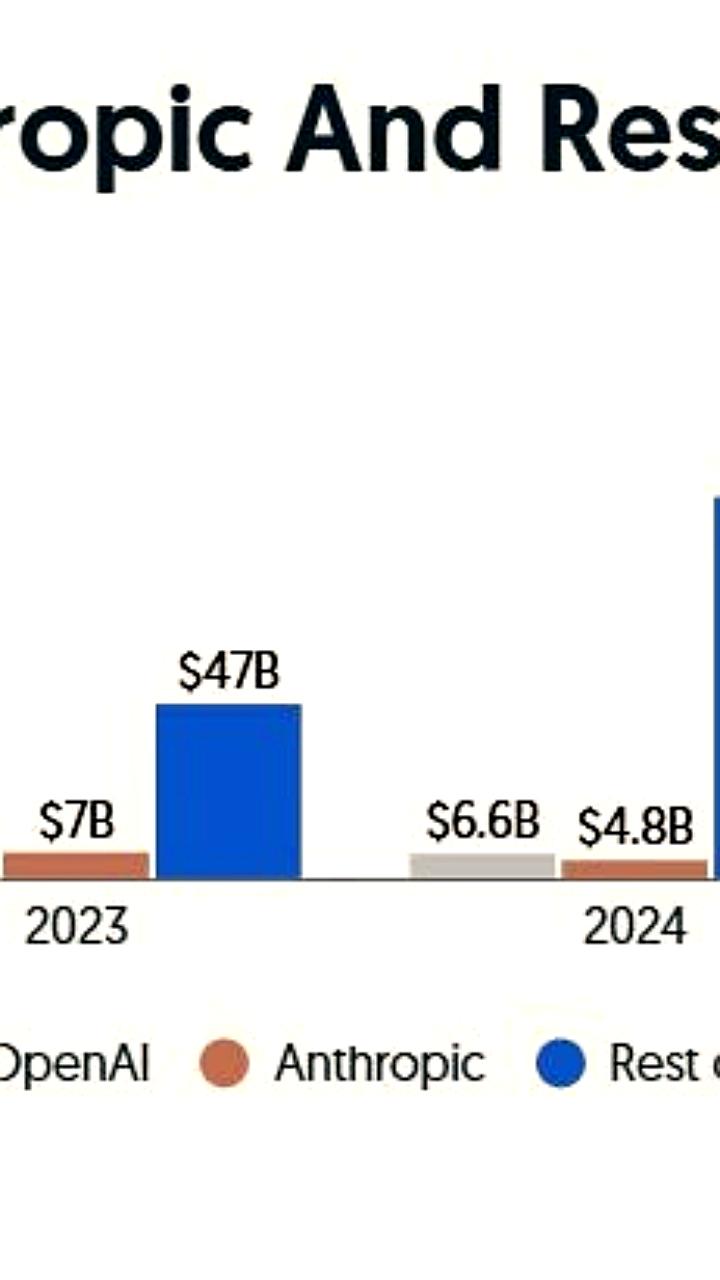

Anthropic привлекает 10 млрд долларов при оценке 350 млрд

Экономика

1 день назад