4 июня, 13:29

Исследование: более 60% россиян не распознают дипфейки среди реальных фотографий

Опросы и замеры

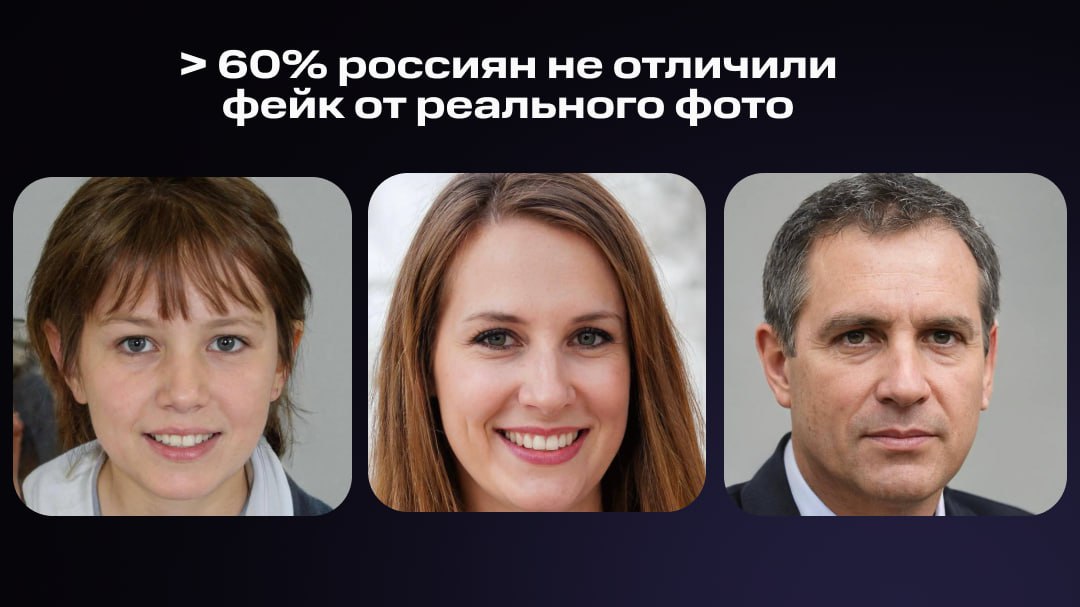

Эксперимент: большинство россиян не могут отличить дипфейк от реальной фотографии Респондентам показывали десять изображений людей: четыре были сгенерированы ИИ, а шесть – реальными снимками. Каждое сгенерированное изображение не менее 60% опрошенных принимали за реальное одно из изображений назвали реальным 81% . А три из шести реальных фотографий большинство посчитали дипфейками. Опросы и замеры, исследование MWS AI

Технологии255 дней назад

Владимирские новости

Владимирцам рассказали, как распознать ИИ-контент и фейки Эксперты ВТБ рассказали, как отличить тексты и изображения, созданные нейросетями: сгенерированный визуальный контент чаще всего выдают анатомические ошибки, искажения перспективы и нелогичные детали в кадре, а ИИ-тексты - избыточная шаблонность, повторяемость формулировок и упрощенный стиль. ↗ Прислать новость Подписаться

Технологии254 дня назад

Физики и Юрики

Всё дело — в деталях Генеративные нейросети могут ввести в заблуждение. ИИ создаёт тексты, иллюстрации и видеоролики, которые часто выглядят правдоподобными. Чтобы отличить их от настоящих, потребуются системный подход, цифровая грамотность и внимание. Картинку от ИИ могут выдать, например, анатомические неточности, нарушение законов физики, искажение перспективы, ненатуральные тени или бессмысленные надписи. Сгенерированные тексты часто отличаются однотипными формулировками и интонацией, избыточным дружелюбием, лишними пояснениями, большим объёмом воды. Для проверки можно использовать и специальные инструменты. Так, в планах ВТБ — обучение моделей-детекторов, которые смогут отслеживать в ИИ-контенте чувствительные темы, а также проверять достоверность выдачи. Эксперты банка говорят, что такой подход необходим при работе с базами знаний и клиентскими интерфейсами, чтобы исключить риск дезинформации и некорректных формулировок.

Технологии253 дня назад

Доктор Z прописал

Более 60% соотечественников не могут отличить изображения, созданные искусственным интеллектом, от настоящих фотографий Участникам эксперимента продемонстрировали десять изображений людей: четыре из них были сгенерированы ИИ, а шесть представляли собой реальные фотографии Из четырех ИИ-снимков три были созданы с помощью специализированной нейросети, предназначенной для генерации дипфейков, и одно — при помощи большой языковой модели, которая формирует изображения по текстовому описанию Результаты опроса показали, что большая часть респондентов не смогла распознать дипфейки: все три портрета, созданные с помощью специализированной нейросети, большинство участников приняли за подлинные фотографии В каждом из этих случаев доля правильных ответов не превысила 40%. Один из дипфейков 81% опрошенных приняли за изображение настоящего человека В то же время изображение, созданное обычной языковой моделью, участники чаще определяли как сгенерированное При этом большинство респондентов сочли три из шести реальных фотографий дипфейками Авторы исследования отметили, что для формирования безопасной цифровой среды в условиях широкого распространения генеративных технологий необходимы такие меры, как добровольная маркировка ИИ-контента в сфере маркетинга и рекламы, повышение уровня защиты финансовых сервисов, развитие стандартов для использования ИИ в государственном секторе, а также внедрение программ цифровой грамотности

Технологии255 дней назад

КиберХаб - IT и Нейросети

Более 60% участников опроса не смогли отличить дипфейк от реального фото — даже те, кто регулярно работает с ИИ. В эксперименте участвовало более 1600 человек. Им показали 10 изображений, 4 из которых были сгенерированы ИИ. Результаты неутешительные: Уверенно распознали подделки менее 40% человек; 3 настоящих фото из 6 приняли за фейк; До 80% респондентов ошибались при оценке дипфейков. Страшно, очень страшно. КиберХаб БотGPT

Технологии254 дня назад

MTS AI

Не POV, а REAL: более 60% россиян не распознают дипфейки Мы провели исследование и предложили 1600+ россиянам определить в наборе из 10 фотографий те, что сгенерированы специализированной нейронкой. Большинство респондентов не смогли распознать дипфейки человека. Более того, только 3 реальных фото из 6 были отмечены респондентами как подлинные. Ошибались даже те, кто часто взаимодействует с ИИ Результатами исследования поделились тут. А вы как думаете, какие фото в этом посте настоящие? #MTSAI_исследование

Технологии253 дня назад

Похожие новости

+4

+4

+47

+47

+2

+2

+9

+9

Исследование ТюмГУ: Как опыт взаимодействия с ИИ влияет на распознавание сгенерированных изображений

Технологии

17 минут назад

Проблемы с медицинскими устройствами на основе ИИ: отчеты FDA фиксируют инциденты

Наука

1 день назад

+4

+4

В России стартует эксперимент по обучению ИИ формированию уникального мнения

Общество

23 часа назад

+47

+47

Исследование прогнозирует экономический эффект от генеративного ИИ к 2030 году

Технологии

1 день назад

+2

+2

Эксперты выделяют мегатренды и риски развития ИИ на ближайшие годы

Технологии

19 часов назад

+9

+9

Китайские онлайн-магазины внедряют ИИ для создания рекламных аватаров

Технологии

1 день назад