1 марта, 03:09

Компания Mercury запускает диффузионные языковые модели Mercury Coder с высокой скоростью генерации

AI и точка.

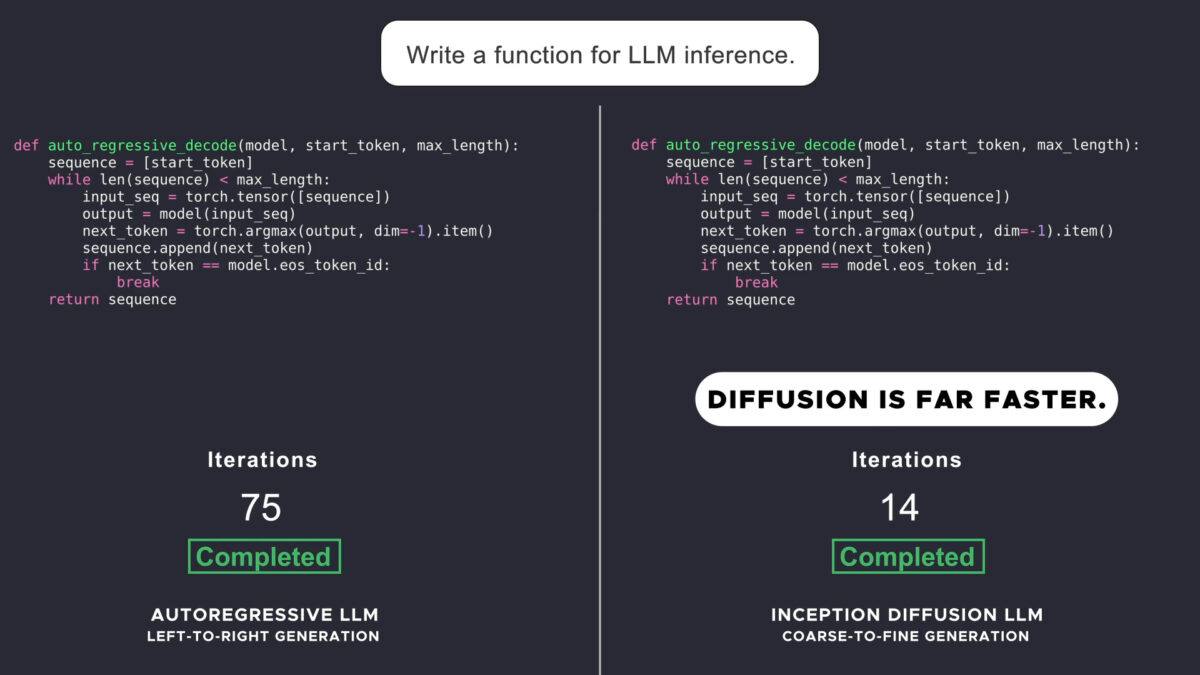

Стартап Inception Labs выпустил сверхбыстрые диффузионные языковые модели Mercury Coder. В отличие от обычных нейросетей, которые последовательно предсказывают ответ токен за токеном, диффузионная модель создает текст целиком «из белого шума» — посмотрите сравнение на видео Этот же принцип лежит в основе популярных генераторов картинок, например, Midjourney или Flux. Mercury Coder Small в кодинге не уступает GPT-4o mini, но работает быстрее примерно в 10 раз. «Младшая» Mercury Coder Mini не так умна, но еще почти в 1,5 раза быстрее. Модели ориентированы на кодинг, но могут «поддержать беседу» и на любую другую тему. Попробовать бесплатно — здесь чтобы увидеть, как «шум» превращается в ответ, включите Diffusion Effect .

Технологии1 день назад

Нейродвиж

А у нас тут революция: компания Inception сделала поколение dLLM, которые работают на основе диффузии как генераторы изображений . И это ОЧЕНЬ круто. Как это работает: вместо уже привычной генерации токенов один за другим, диффузия генерирует весь текст сразу со случайным порядком токенов, а только после этого расставляет слова в правильном порядке. А вы в это время смотрите на но недолго . Результат очень шустрый, в 5-10 раз быстрее классических LLM. Сейчас опубликовали первую модель Mercury Coder и она где-то на уровне GPT-4o. Конечно, не «вау», но это фактически первая серьёзная модель по этой технологии. Можно попробовать здесь.

Технологии1 день назад

Код Шрёдингера | IT

А у нас тут революция: компания Inception сделала поколение dLLM, которые работают на основе диффузии как генераторы изображений . И это ОЧЕНЬ круто. Как это работает: вместо уже привычной генерации токенов один за другим, диффузия генерирует весь текст сразу со случайным порядком токенов, а только после этого расставляет слова в правильном порядке. Результат очень шустрый, в 5-10 раз быстрее классических LLM. Сейчас опубликовали первую модель Mercury Coder и она где-то на уровне GPT-4o. Конечно, не «вау», но это фактически первая серьёзная модель по этой технологии. Можно попробовать здесь.

Технологии16 часов назад

Tokengram.ru

О проверках "дроповодов" и криптообменников и не только - на tokengram.ru

Реклама16 часов назад

БлоGнот

Компания Mercury представила семейство новых языковых моделей, работающих на основе диффузии dLLM , а не традиционного авторегрессивного подхода. Это принципиально другой механизм генерации текста — вместо последовательного создания токенов слева направо, диффузионные модели создают ответ по принципу "от грубого к точному", постепенно улучшая его за несколько шагов "шумоподавления". Так давно работают все модели text-to-image и вот очередь дошла до текстовых моделей. Первая доступная модель — Mercury Coder, специализирующаяся на генерации кода. Она работает в 5-10 раз быстрее существующих моделей — более 1000 токенов в секунду на обычных GPU NVIDIA H100, что раньше было возможно только на специализированном оборудовании. Для сравнения: даже оптимизированные по скорости авторегрессивные модели выдают максимум 200 токенов в секунду, а некоторые крупные модели — менее 50. По качеству код модели превосходит GPT-4o Mini и Claude 3.5 Haiku. В бенчмарке Copilot Arena Mercury Coder Mini делит второе место, опережая даже более крупные модели вроде GPT-4o, при этом работая в 4 раза быстрее, чем GPT-4o Mini. В сравнении, правда, отсутствуют рассуждающие модели и Sonnet 3.5/3.7, которые программируют гораздо лучше. Компания рассказывает, что диффузионные языковые модели откроют новые возможности: улучшенные агенты, продвинутое рассуждение с исправлением ошибок за секунды а не минуты, как у текущих моделей , контролируемая генерация с возможностью редактирования и генерации токенов в любом порядке, а также приложения для устройств с ограниченными ресурсами. Mercury Coder уже доступен для тестирования в playground. API пока закрыто, но можно записаться в лист ожидания.

Технологии1 день назад

TechnoHub Media

Текст за пару секунд: нейронка Mercury генерирует тексты во много раз быстрее любых конкурентов. Модель выдает сразу все токены и потом расставляет по местам, а не выкатывает их по одному. Кодит ИИ на уровне GPT-4o, но только в разы быстрее. При том технология dLLM-модели за секунды может выдать даже трактат. Тестим имбу тут. 2 TechnoHub

Технологии1 день назад

IT и безопасность

В свет вышла первая dLLM-модель Mercury Coder — она работает на основе диффузии и дает ответ в разы быстрее обычных LLM-моделей. Токены в такой модели генерируются не поочерёдно как в LLM, а сразу все, и только потом расставляются в правильном порядке Эта технология может значительно ускорить классические модели — объёмные тексты будем получать в считанные секунды.

Технологии16 часов назад

Похожие новости

+5

+5

+70

+70

+3

+3

+3

+3

+3

+3

+7

+7

ElevenLabs и Hume представляют новые технологии преобразования речи в текст и генерации аудио

Технологии

1 день назад

+5

+5

OpenAI тестирует новую модель ChatGPT 4.5 с улучшениями

Технологии

1 день назад

+70

+70

Ожидается запуск GPT-4.5 и GPT-5 от OpenAI в ближайшие недели

Технологии

1 день назад

+3

+3

Яндекс запускает метод LoRA для дообучения нейросетей в Yandex Cloud

Технологии

17 часов назад

+3

+3

Технологическая гонка в ИИ: DeepSeek, Tencent и Alibaba представляют новые модели

Технологии

8 часов назад

+3

+3

40% учеников в Китае используют ИИ для учебы: вызовы и возможности

Общество

1 день назад

+7

+7