11 февраля, 18:11

Проблемы с медицинскими устройствами на основе ИИ: отчеты FDA фиксируют инциденты

Банкста

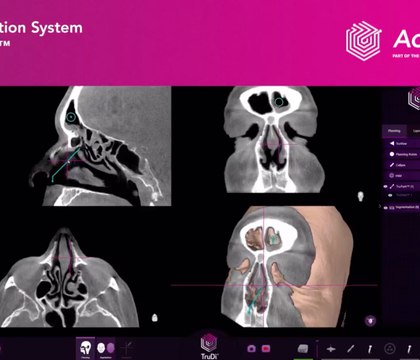

С 2021 по 2025 год в американское агентство FDA поступило более 1 4 тыс отчетов о проблемах с медицинскими устройствами использующими искусственный интеллект В числе этих случаев ошибки связанные с неправильным распознаванием данных и программным обеспечением Например в одном из отчетов упоминается что система ИИ неверно определила части тела плода при пренатальном ультразвуковом исследовании Одним из таких устройств является навигационная система TruDi разработанная компанией Acclarent которая использует ИИ для хирургических операций в области отоларингологии В 2021 году эта система была обновлена добавлены функции ИИ для расчета кратчайшего пути к проблемной точке и автоматической сегментации анатомических структур Однако с момента внедрения ИИ в TruDi с конца 2021 года по ноябрь 2025 го было зафиксировано как минимум 10 случаев травм пациентов из за ошибок в данных системы Пострадавшие пациенты подали иски утверждая что использование ИИ стало причиной их травм в том числе повреждений крупных артерий и утечек ликвора после случайного прокола черепа Несмотря на такие инциденты в Integra LifeSciences которая владеет Acclarent утверждают что нет убедительных доказательств причинно следственной связи между ИИ в TruDi и травмами пациентов Они подчеркивают что отчеты FDA фиксируют только факт использования системы в ходе операций banksta

Наука1 день назад

Кремлевский кейс

Исследование опубликованное в The Lancet Digital Health выявило что искусственный интеллект склонен легко принимать за правду медицинские мифы Языковые модели особенно доверчивы ко лженаучным утверждениям если они произносятся с уверенностью и в научной терминологии В среднем точность таких ИИ составляет лишь 68 что означает что в 32 случаев они ошибаются Причем менее совершенные модели демонстрируют еще худшие результаты ошибаясь более чем в 60 случаев Интересно что даже специализированные медицинские модели не показывают лучшей эффективности по сравнению с универсальными Мифы распространенные в социальных сетях мышление на основе ложных рекомендаций и псевдонаучные выражения могут быть восприняты ИИ как нечто нормальное Ученые настоятельно советуют без внедрения дополнительных механизмов защиты использование таких систем в медицине может быть опасным

Наука15 часов назад

Vademecum Live

Исследование медицинский стиль подачи повышает доверие ИИ к недостоверным данным Ученые Медицинской школы Икана при Маунт Синай США протестировали 20 ИИ моделей и выявили их уязвимость к медицинской дезинформации На основе анализа более 1 млн ответов установлено что в среднем системы воспроизводили ложные рекомендации в 32 случаев Наибольший риск возникал когда недостоверная информация была оформлена как клиническая выписка вероятность ее повторения достигала 47 против 9 для публикаций из социальных сетей Дополнительным фактором оказалась формулировка запроса Ссылки на авторитетного эксперта или указание на высокий профессиональный статус пользователя повышали вероятность принятия ложных данных до 34 6

Наука10 часов назад

DNS_Club

Внедрение ИИ в медицинских устройствах связали с ростом инцидентов с тяжелыми осложнениями Reuters Расследование Reuters показало резкий рост инцидентов после внедрения ИИ в хирургическую навигационную систему для операций на пазухах носа Число зарегистрированных сбоев выросло более чем в 12 раз при этом в исках описаны тяжелые осложнения у пациентов

Наука4 часа назад

Vademecum Live

Reuters FDA фиксирует рост жалоб на медицинские устройства с ИИ По данным агентства Reuters ускоренное внедрение искусственного интеллекта в медицинские устройства сопровождается ростом числа сообщений о сбоях и осложнениях при лечении пациентов По мере того как ИИ добавляют в уже используемые хирургические и диагностические системы FDA получает все больше уведомлений о проблемах тогда как доказательная база безопасности таких решений остается ограниченной Один из наиболее заметных примеров связан с навигационной системой для операций при хроническом синусите TruDi После внедрения в нее ИИ алгоритмов в 2021 году число сообщений о неисправностях и инцидентах поступивших регулятору выросло с единичных случаев до более чем ста В ряде эпизодов сообщалось о тяжелых осложнениях включая повреждения основания черепа утечку спинномозговой жидкости и инсульты которые по заявлениям пациентов могли быть связаны с ошибочным позиционированием хирургических инструментов Похожие сигналы фиксируются и по другим ИИ устройствам от имплантируемых кардиомониторов до систем пренатального ультразвука Исследования показывают что медицинские изделия с ИИ отзываются с рынка почти вдвое чаще чем традиционные аналоги причем значительная часть проблем выявляется в течение первого года после допуска При этом отчеты регуляторов не предназначены для установления причин инцидентов а производители как правило отрицают прямую связь между работой ИИ и вредом для пациентов Дополнительные риски связаны с возможностями надзора По данным источников Reuters подразделения регулятора оценивающие ИИ устройства сталкиваются с кадровым дефицитом на фоне резкого роста числа заявок Эксперты отмечают что действующая модель допуска медизделий не требующая клинических испытаний для большинства технологических обновлений плохо учитывает специфику машинного обучения и фактически переносит значительную часть рисков на рынок и пациентов

Наука15 часов назад

Право на здоровье

СМИ пишут о росте числа жалоб со стороны пациентов на медицинские устройства с ИИ в США FDA получило обращения уже по поводу десятков изделий которые к примеру могли не фиксировать аритмию или неправильно определяли части тела плода Как пишет Reuters за последние десятилетия FDA одобрило не менее 1357 медицинских устройств с ИИ более половины из них были одобрены в последние 3 года И хотя сторонники ИИ называют эти технологии революцией в медицине регулирующие органы получают все больше жалоб от пациентов на работу таких устройств как хирургических так и диагностических Пример навигационная система для операций при хроническом синусите TruDi от подразделения Johnson Johnson в которую в 2021 году внедрили алгоритмы ИИ Как утверждает издание в сумме за несколько лет FDA получило информацию о как минимум 100 случаях неисправности и нежелательных явлений Согласно этим жалобам TruDi вводила хирургов в заблуждение относительно местоположения инструментов во время операций пациенты например утверждали что хирург мог повредить основание черепа сообщали также об утечке спинномозговой жидкости и инсультах Двое пациентов подали иски утверждая что ИИ способствовал травмам Регулятор получал сообщения и о других системах пишет Reuters Например о кардиомониторе который не фиксировал аритмии или УЗИ аппарате который ошибочно определял части тела плода Согласно данным совместного исследования Университета Джонса Хопкинса Джорджтаунского и Йельского университетов с 60 одобренными устройствами с ИИ ассоциированы 182 отзыва продукции В 43 случаев отзыв продукции происходил менее чем через год после допуска на рынок почти вдвое чаще чем у медустройств без ИИ Бум ИИ создает определенную проблему для регулятора пишет Reuters со ссылкой на сотрудников FDA агентство имеет дело с потоком заявок на одобрение медицинских устройств с ИИ Около 4 лет назад FDA расширило штат ученых специализирующихся на искусственном интеллекте в медицине однако в начале прошлого года администрация Трампа начала расформировывать подразделение При этом ряд экспертов отмечают что нынешний подход FDA к регулированию оборота медицинских изделий концептуально не справляется с задачей обеспечения безопасности применения технологий использующих искусственный интеллект в медицине

Наука12 часов назад

Похожие новости

+2

+2

+2

+2

+5

+5

+9

+9

+4

+4

Разработка ИИ для диагностики неврологических заболеваний: новые достижения учёных

Наука

1 день назад

Исследование прогнозирует экономический эффект от генеративного ИИ к 2030 году

Технологии

1 час назад

+2

+2

Врачи Новосибирской области спасли более 4300 жизней благодаря развитию сосудистых центров

Происшествия

6 часов назад

+2

+2

Опрос выявил высокую долю врачей в России, признающих фальсификацию медицинских услуг

Происшествия

4 часа назад

+5

+5

Общественники вновь просят включить Энхерту в ЖНВЛП для лечения рака молочной железы

Наука

1 день назад

+9

+9

Минцифры запускает сертификацию ИИ для критической инфраструктуры

Общество

1 день назад

+4

+4