5 февраля, 05:51

Google тестирует управление Android-смартфонами без рук с помощью Gemini

iGuides.ru

Android cмартфонами скоро можно будет управлять без рук Google уже готовит новую фичу Gemini Похоже Google готовит крупное обновление Gemini которое радикально изменит сценарии использования смартфона Анализ свежей бета версии приложения Google показывает что ассистент скоро сможет напрямую взаимодействовать с установленными приложениями и выполнять действия от имени пользователя Причём речь идёт не о подсказках или текстовой помощи а о полноценном управлении интерфейсом от заказа еды до вызова такси без ручного взаимодействия с девайсом Новая функция проходит под кодовым названием bonobo Её нашли в Google App версии 17 4 Она будет запущена в экспериментальном режиме через Google Labs и позволит Gemini автоматически работать с интерфейсом приложений используя экранную автоматизацию Нечто похожее есть уже в десктопных ИИ агентах В примерах Google упоминает сценарии по типу заказа поездки через Uber или оформления доставки в сервисах наподобие Uber Eats Само приложение не открывается не нужно вводить адрес и подтверждать что либо вручную Вероятно на старте функция будет ограничена небольшим списком сервисов из за частых изменений интерфейсов сторонних приложений Сама автоматизация экрана работает в Android 16 QPR3 поэтому для её работы потребуется как минимум эта версия системы Google также подчёркивает вопросы безопасности Например в коде есть упоминания что пользователям не рекомендуется передавать Gemini логины и платёжные данные Более того при включённом сохранении активности компания сможет анализировать скриншоты которые делает ассистент во время работы Сроки официального запуска пока неизвестны но видимо такого курса автоматизации будут придерживаться все разработчики ИИ в ближайшие годы iguides

Технологии16 часов назад

iPhones.ru

Смартфон сам закажет еду и такси Google тестирует управление Android без рук на базе Gemini Пользователь сможет написать задачу текстом в Gemini или надиктовать её а ИИ откроет нужное приложение и выполнит её Google предупреждает что Gemini может ошибаться а ответственность за его действия лежит на пользователе Вероятно на старте функция будет работать только с ограниченным числом приложений и не во всех странах www iphones ru 1358276 новости iphonesru

Технологии14 часов назад

3DNews

Современные модели искусственного интеллекта активно развиваются и начинают интегрироваться в управление мобильными устройствами Google ведет разработки в этом направлении через программу Project Astra и вскоре ожидаются значимые результаты google gemini ииагент Подробнее

Технологии3 часа назад

Похожие новости

+2

+2

+14

+14

+2

+2

+6

+6

2ГИС запускает ИИ ассистента для записи на услуги

Технологии

5 часов назад

Выпуск ИИ инструмента Anthropic вызвал падение акций и изменения на рынке ПО

Технологии

5 часов назад

+2

+2

Новые технологии от OpenAI, Alibaba и xAI: обновления в ИИ и генерации контента

Технологии

8 часов назад

+14

+14

Firefox внедряет управление ИИ в новом обновлении

Технологии

8 часов назад

+2

+2

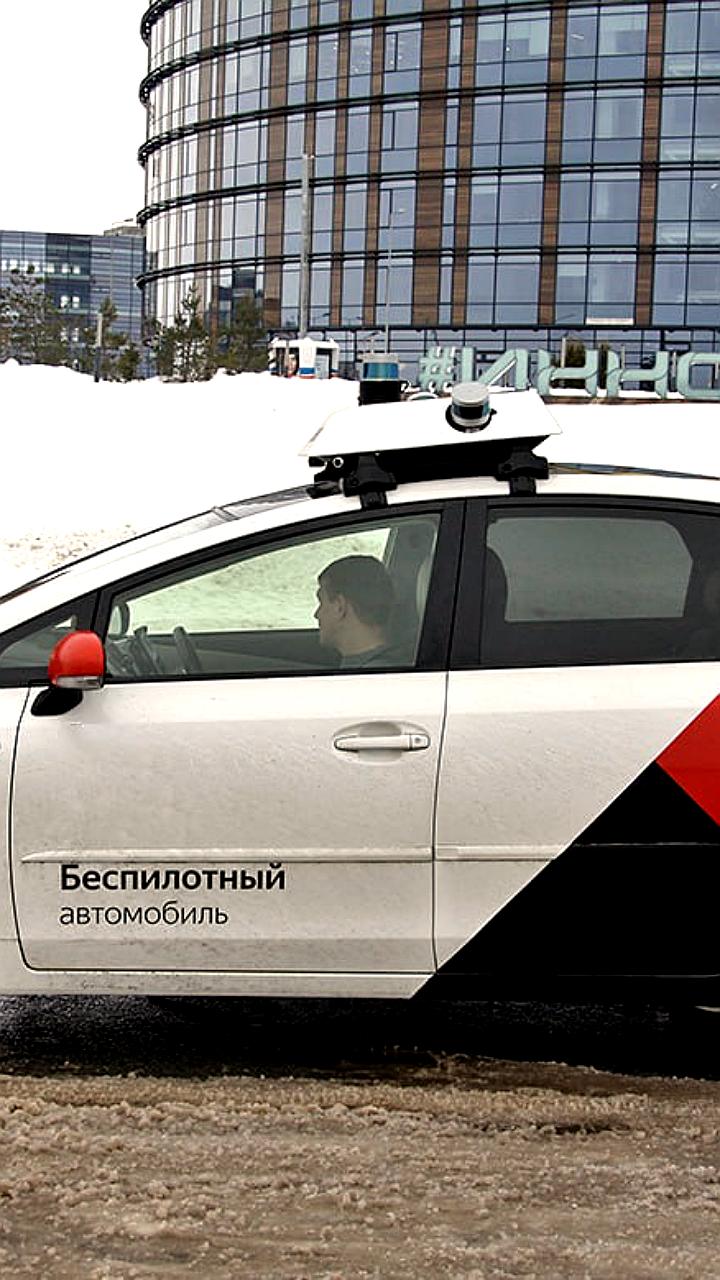

Университет Иннополис запатентовал нейросетевую систему управления беспилотниками

Технологии

5 часов назад

Запуск ИИ ассистента ментальной поддержки для молодежи в Башкирии и Астрахани

Общество

5 часов назад

+6

+6