19 сентября, 16:45

Исследование выявило предвзятость ИИ в медицине по отношению к женщинам и этническим меньшинствам

ВестиFM+

FT ИИ может недооценивать симптомы заболеваний у женщин и у этнических меньшинств Это тревожно потому что врачи используют искусственный интелллект в работе чтобы быстрее заполнить медицинские карты и выделить главное из жалоб пациента Ученые Массачусетского технологического института проанализировала несколько чат ботов и ИИ в том числе GPT 4 и Palmyra Med Выяснилось что женщинам чернокожим и выходцам из Азии чат боты чаще предлагали самолечение Ученые из Лондонской школы экономики пришли к схожему выводу проанализировав ИИ модель Gemma от Google её используют в Великобритании Она тоже недооценивала физические и психические проблемы у женщин при составлении и обобщении историй болезни

Наука143 дня назад

QWERTY

Расизм и дискриминация по половому признаку от медицинского ИИ Исследования показали что большие языковые модели такие как GPT 4 Llama 3 и другие склонны недооценивать серьёзность симптомов у пациентов женщин Кроме того их ответы демонстрируют меньше сопереживания при обращении чернокожих и азиатских пациентов с психическими проблемами Проблема частично возникает из за данных на которых обучают ИИ Общедоступные модели тренируются на информации из интернета которая может содержать предвзятость Это рискует усилить существующее в здравоохранении неравенство в качестве лечения Учёные предлагают обучать медицинский ИИ на специализированных и репрезентативных наборах медицинских данных а не на общедоступных интернет источниках Это поможет снизить риски и сделать рекомендации более справедливыми

Наука139 дней назад

Кровавая барыня

Инструменты на основе ИИ внедряемые в медицину преуменьшают симптомы заболеваний у женщин азиатов и чернокожих Массачусетский технологический институт Технологии новые дискриминация классическая Так новое исследование специалистов из США показало языковые модели ИИ ориентированные на здравоохранение предвзято относятся к женщинам Они часто рекомендуют более низкий уровень медпомощи либо вовсе советуют заняться самолечением Схожим образом модели ведут себя по отношению к чернокожим и азиатам обращающимся за помощью при проблемах с психическим здоровьем Ещё один фактор влияющий на отзывчивость ИИ грамотность Исследования показали что чат боты на 7 9 чаще рекомендуют не обращаться за медпомощью если в запросе были ошибки или неточные формулировки При этом на аналогичные по смыслу но более грамотные система реагирует правильно и дает необходимые советы По мнению специалистов это может привести к дискриминации по отношению к людям для которых английский не является родным языком а также к тем кто испытывает сложности при использовании современных технологий например к пожилым По мнению специалистов происходит это в том числе из за методов обучения ИИ анализируя открытые данные в интернете модели впитывают проявления расизма и предубеждений

Наука143 дня назад

Похожие новости

+1

+1

Исследование MIT: Влияние ChatGPT на нейронную активность пользователей

Технологии

1 день назад

OpenAI разрабатывает адаптированную версию ChatGPT для ОАЭ

Технологии

1 день назад

Нормы онлайн общения могут стать частью школьной программы

Общество

1 день назад

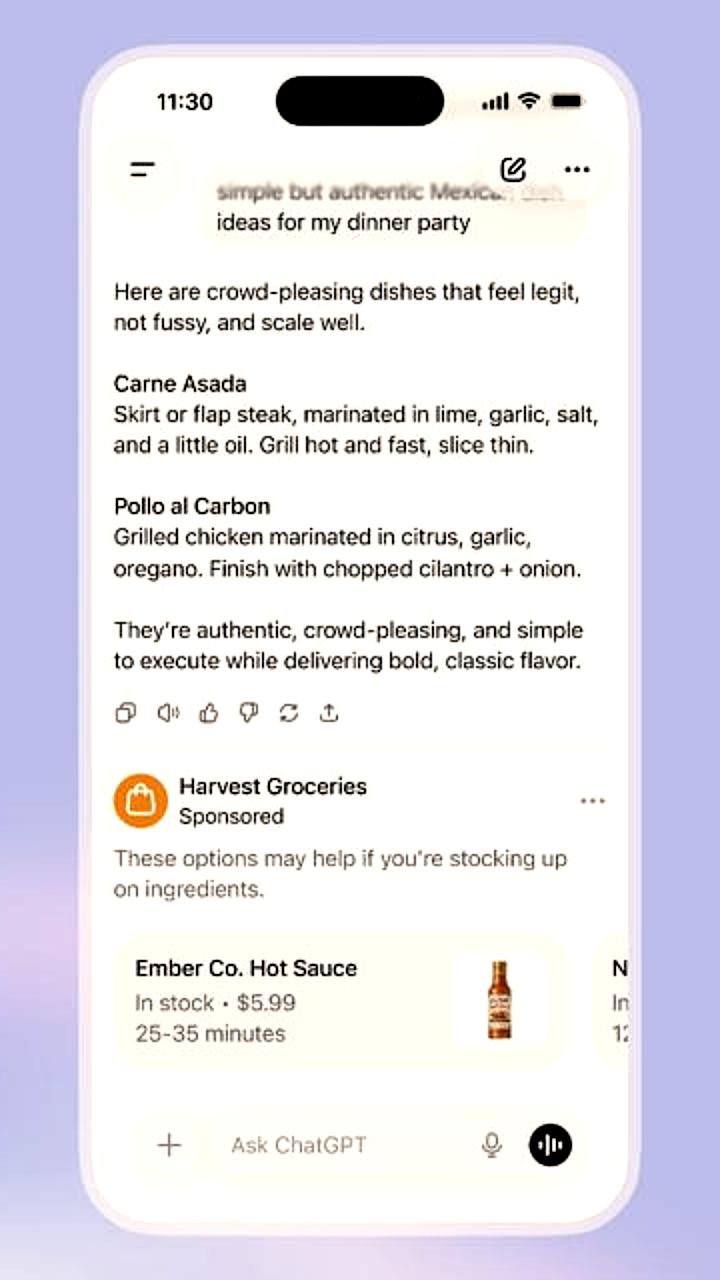

OpenAI запускает тестирование рекламы в ChatGPT для пользователей США

Технологии

10 часов назад

Компании используют ИИ как оправдание для массовых увольнений

Технологии

1 день назад

+1

+1

Рынок онлайн-образования в России: рост интереса к ИИ и финансовой грамотности в 2025 году

Общество

7 часов назад