30 июля, 15:18

Китайский стартап Z.AI представил языковую модель GLM-4.5 с высокими показателями в агентных задачах

AI и точка.

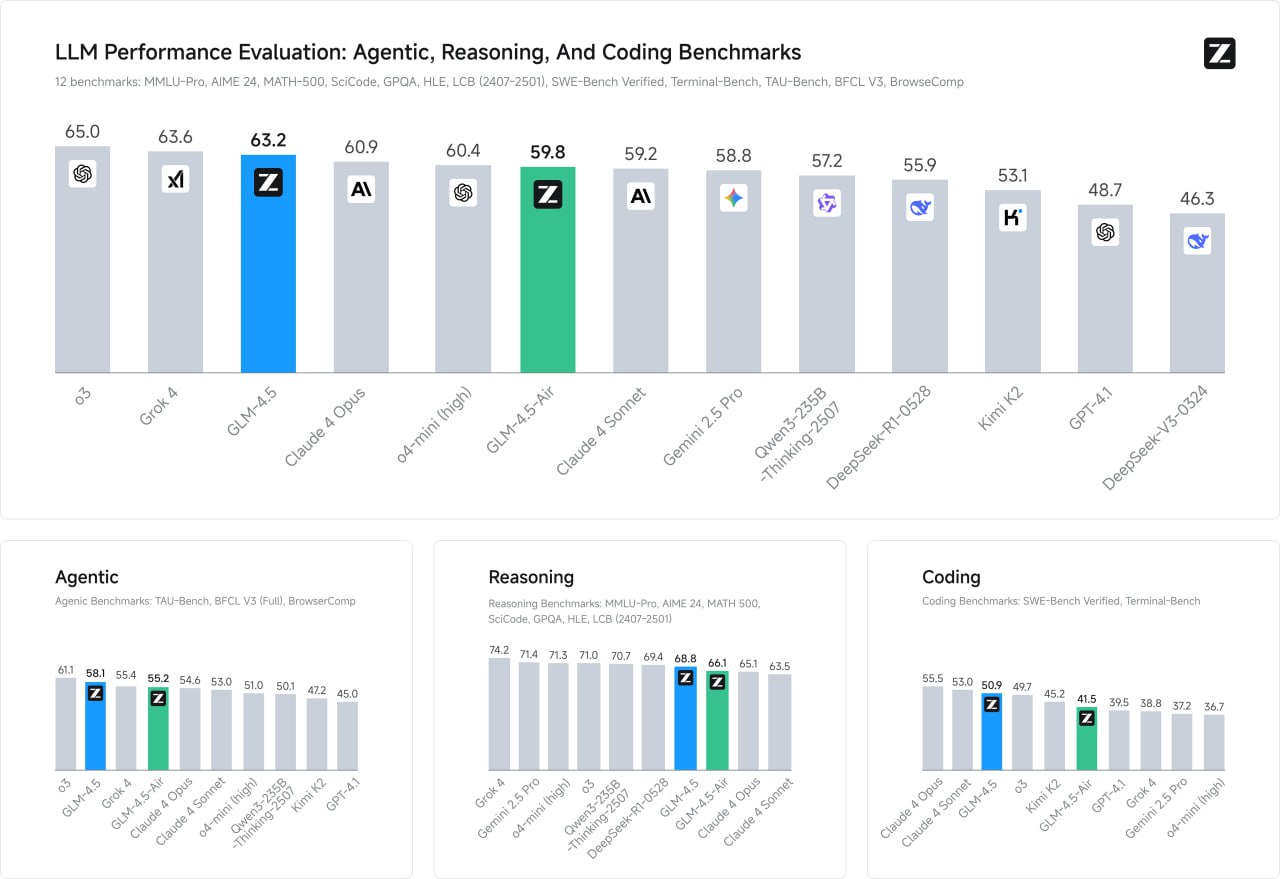

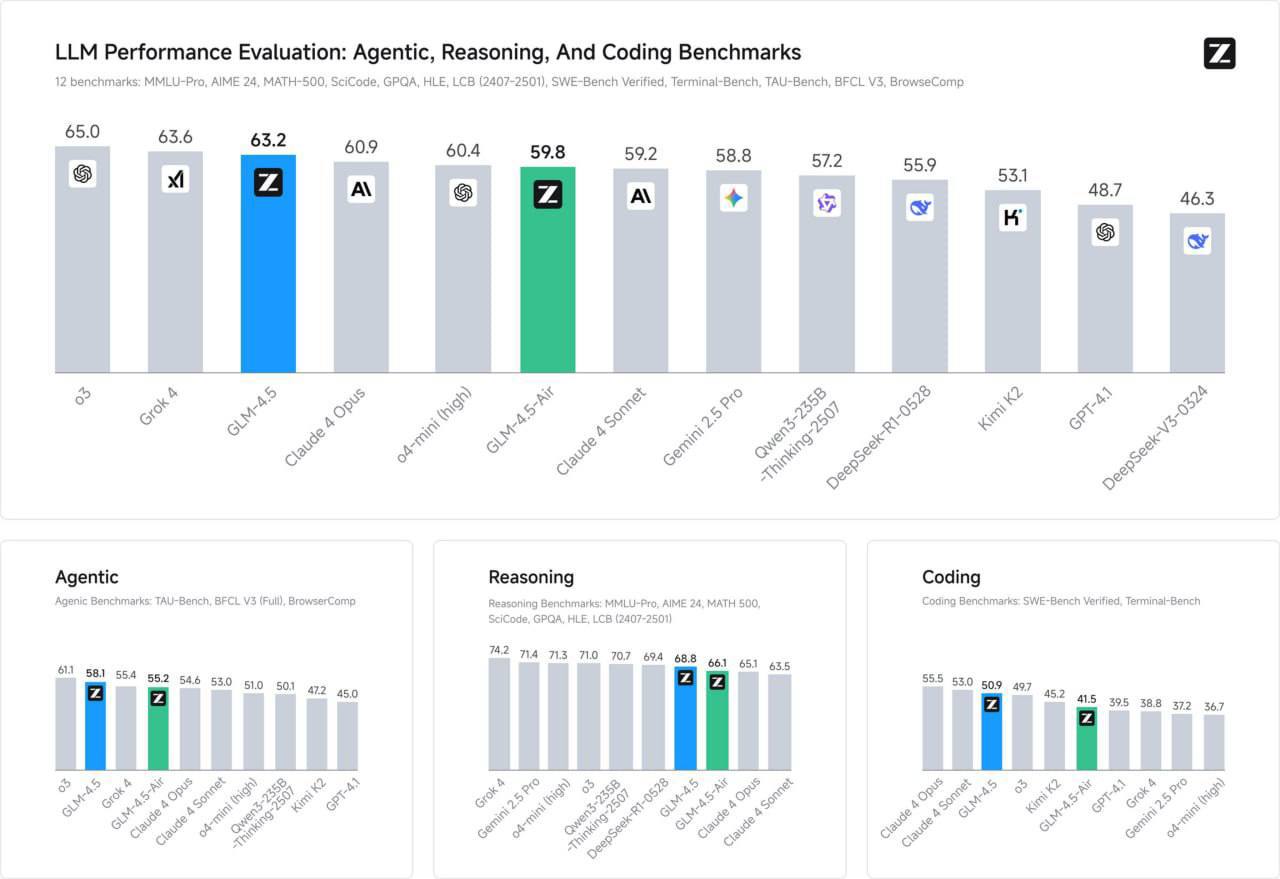

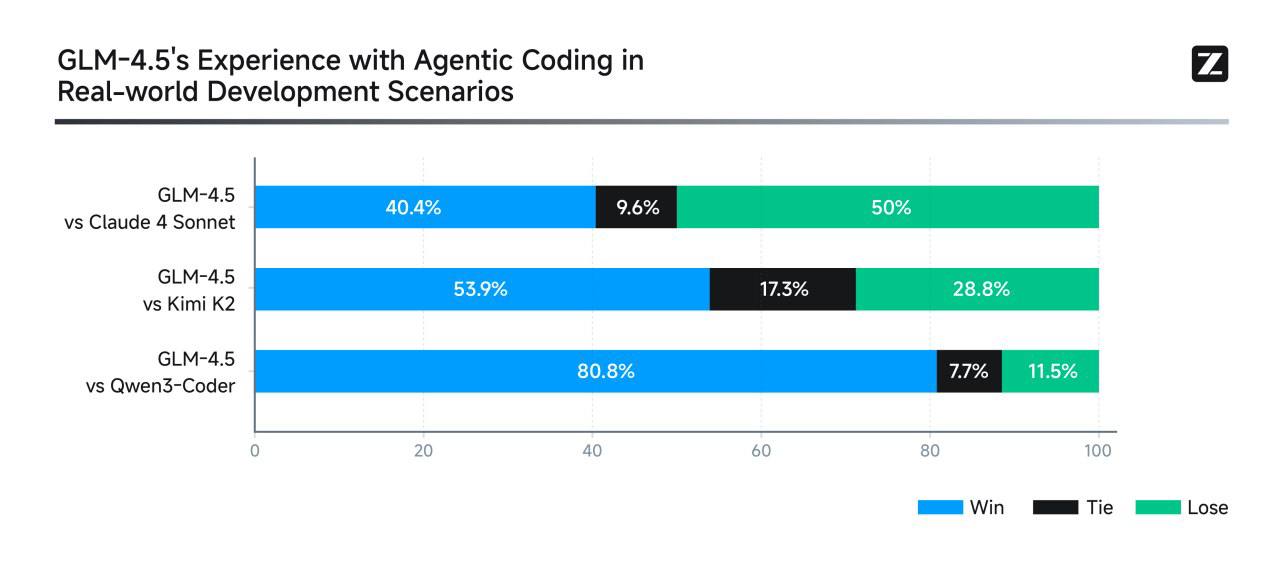

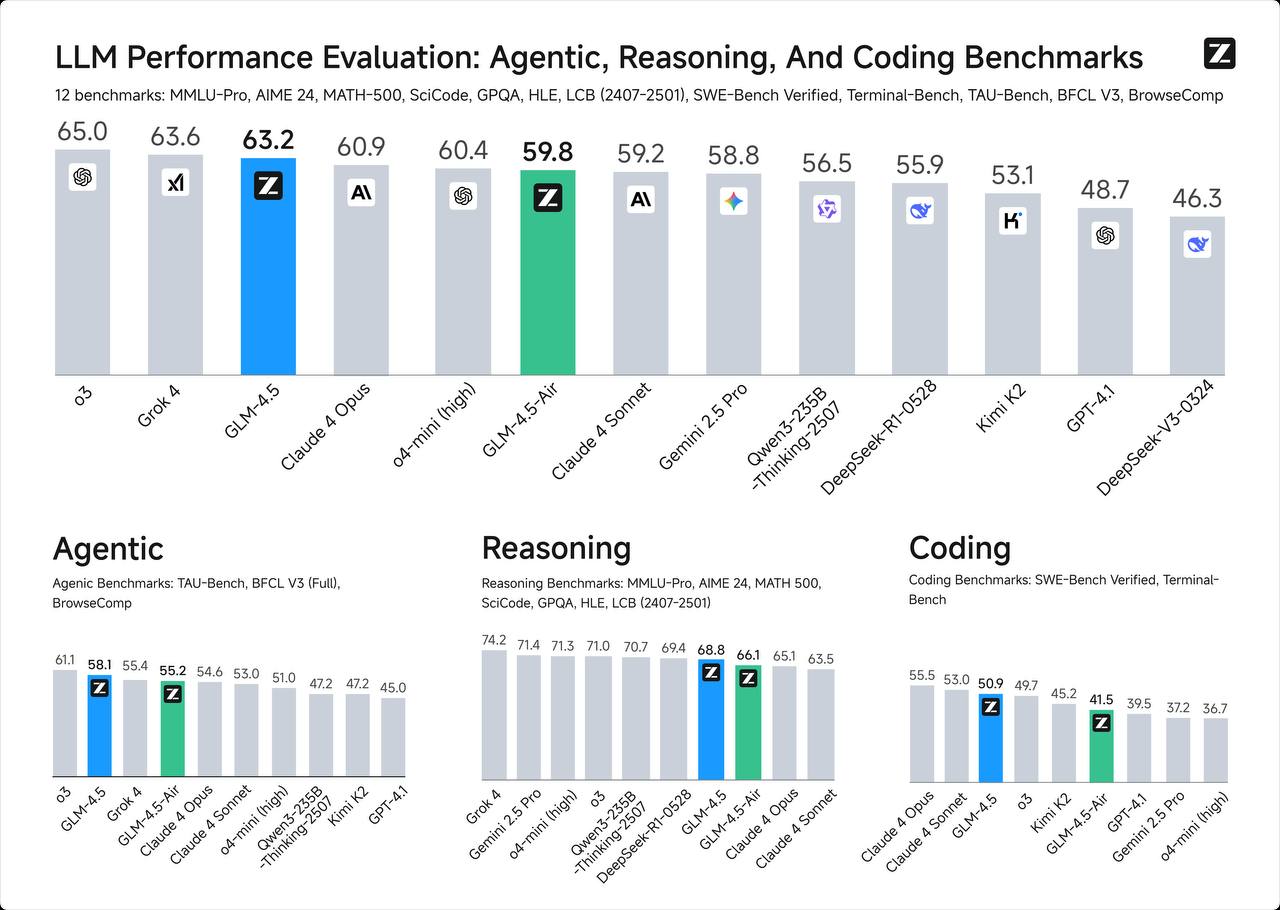

Китайский стартап Z.AI выпустил открытую языковую модель GLM-4.5, 355 млрд параметров, из которых 32 млрд активных. В общих знаниях и научных задачах модель хоть и немного, но уступает как «западным флагманам», так и китайским open source товарищам. При этом в агентских задачах, кодинге и самостоятельном веб-серфинге действительно приближается и даже опережает ведущие модели. И стоит примерно в 5+ раз дешевле Grok 4 и Sonnet 4. Также разработчики выпустили уменьшенную Air-версию модели на 106/12 млрд параметров. Пообщаться с GLM-4.5 бесплатно можно здесь.

Технологии2 дня назад

GPT/ChatGPT/AI Central Александра Горного

Китайская компания Z.AI представила открытую языковую модель GLM-4.5 GLM-4.5 — это MoE-модель с архитектурой на 355 миллиардов параметров 32 млрд активны . По уровню общих знаний и результатам в научных тестах модель немного отстаёт как от западных флагманов, так и от некоторых китайских open-source конкурентов. Зато в задачах с агентами, программированием и автономной работой в интернете показывает выдающиеся результаты — вплоть до превосходства над лидерами рынка. При этом по стоимости примерно в 5 раз дешевле Grok 4 и Sonnet 4. Также выпущена облегчённая версия GLM-4.5 Air на 106/12 млрд параметров. Бесплатно протестировать модель можно здесь: Код:

Технологии2 дня назад

Точка сингулярности💥

Zhipu AI выпустили опенсорс SOTA ризонинг модель — GLM-4.5 Внутри 32B активных параметров и 128K контекста. В агентских задачах и кодинге бьет Kimi K2 и Qwen3-Coder. Из забавного — сама модель считает себя Claude. Затестить можно здесь. Hugging Face тут. #КаталогНейросетей

Технологии2 дня назад

skidmarket.ru

Качество, свежесть и экономия — всё в одном месте для вашего комфорта.

Реклама1 день назад

PROJECT+ | Нейросети

Китайцы снова сделали мощно: вышла новая MoE‑модель GLM 4.5 — сильный опенсорс с отличными результатами в reasoning и tool-use. Доступна в двух версиях 106B и 355B , поддерживает контекст до 128k токенов, function calling, стриминг и batching. Прокачана на коде и агентных задачах, обучена на 22 трлн токенов, включая 7 трлн reasoning-контента. Открыта по MIT‑лицензии, есть демо и репа — пробуем.

Технологии2 дня назад

БлоGнот

Z.ai, больше известные как Zhipu, представили GLM-4.5 — модель уже присутствовала на рынке, но нынешний релиз выглядит серьезной заявкой. По тестам модель с 355 миллиардами параметров активных 32 заняла третье место в общем рейтинге после o3 и Grok 4, обойдя Opus 4. Модель по решению похожа на Claude — у нее есть обычный режим и thinking. На практике это означает, что на математике MATH 500 модель показывает 98.2%, почти как o3, а на агентных бенчмарках — на уровне Claude 4 Sonnet. В блоге разработчики описывают интересную деталь — они изменили пропорции архитектуры модели. Сделали модель глубже, но уже, в отличие от того же DeepSeek-V3. И увеличили количество attention heads в 2.5 раза. По их словам, это не улучшает training loss, зато почему-то помогает на reasoning бенчмарках. Модель открытая как и предыдущие версии , поэтому желающие могут скачать веса и воспроизвести результат. Если видеокарты хватит.

Технологии2 дня назад

PROAI

Z.ai представил открытую для сообщества ИИ-модель GLM‑4.5, выделяющуюся гибким режимом рассуждений и поддержкой длинного контекста до 128,000 токенов. Система демонстрирует сочетание агентного мышления для сложных задач и быстрого реагирования, позволяя пользователям выбирать подходящий режим работы. Веса и код доступны для загрузки — можно самостоятельно тестировать и запускать модель локально. GLM‑4.5 активно используется для автоматизации программирования и анализа данных. Бесплатный GPT Экспертный канал

Технологии1 день назад

Похожие новости

+27

+27

+2

+2

+10

+10

+5

+5

+3

+3

+3

+3

OpenAI запускает режим обучения в ChatGPT для пошагового решения задач

Общество

1 день назад

+27

+27

NotebookLM запускает генерацию видеопрезентаций из PDF

Технологии

1 день назад

+2

+2

Alibaba представила видеогенератор Wan 2.2 с улучшенными возможностями

Технологии

1 день назад

+10

+10

Рост использования ИИ-платформ для психологической поддержки и переходов на сайты

Технологии

20 часов назад

+5

+5

Работодатели готовы платить больше за ИИ-навыки у выпускников, но отмечают пробелы в подготовке

Общество

20 часов назад

+3

+3

Популярность ИИ-компаньонов растет в ХМАО и ЯНАО для борьбы со стрессом

Технологии

37 минут назад

+3

+3