21 июля, 18:22

Исследование показывает риски использования ИИ-терапевтов в кризисных ситуациях

ТеZис

OpenAI привлекла в штат специалиста по судебной психиатрии для изучения воздействия своих продуктов на психическое здоровье пользователей Это решение связано с усиливающимися опасениями со стороны экспертов и СМИ по поводу потенциального вреда от взаимодействия с ChatGPT, а именно возможного развития эмоциональных расстройств, включая тяжелые иллюзии и суицидальные мысли. В компании также сообщили о сотрудничестве с независимыми специалистами в области психического здоровья и о проведении совместных исследований с Массачусетским технологическим институтом. Одно из таких исследований выявило признаки проблемного использования ИИ среди части аудитории. Цель проводимой работы – совершенствование моделей, чтобы они корректно реагировали на чувствительные темы и учитывали эмоциональное состояние пользователя. Собранные данные, как уточняется, будут использоваться для настройки поведения ИИ. Тем временем независимые психиатры выражают обеспокоенность тем, что чат-боты все чаще становятся неосознанной заменой психотерапии. В ряде экспериментов ИИ-системы поощряли агрессивное и суицидальное поведение, в том числе среди подростков. Известны случаи, когда человек с психическим заболеванием покончил с собой после переписки с ИИ, который подтвердил его бредовые идеи, а в другом –подросток совершил суицид после эмоциональной привязанности к персонажу чат-бота. Член комиссий по поддержке ИТ-индустрии, защите российских традценностей и по мониторингу качества госуслуг Общественного совета при Минцифры России Ольга Бороненко пояснила, что привело к возникновению подобной проблемы.

Технологии190 дней назад

MD.school медицинский онлайн-университет | Курсы по медицине | Докмед

Искусственный интеллект оказался опасен в качестве психолога С каждым днем все больше людей обращаются к чат-ботам за психологической поддержкой. Искусственный интеллект кажется удобной заменой терапии: он доступен 24/7, всегда «готов помочь». Чат-боты обещают доступ к терапии без очередей и высоких цен, но так ли они безопасны? ⏩ Психиатр Эндрю Кларк из Гарвардской медицинской школы решил проверить, как популярные ИИ-терапевты реагируют на кризисные ситуации. Он выдавал себя за подростка с суицидальными мыслями, агрессивными наклонностями и другими тревожными состояниями. Результаты оказались пугающими. Подробности описали в карточках ↗ Несмотря на стремительное развитие ИИ, чат-боты не способны заменить живого психолога — они не чувствуют эмоций, не понимают контекста и, что самое опасное, могут случайно поддерживать деструктивное поведение вместо помощи. Доверять им психическое здоровье может быть опасно, по крайней мере пока. Источники: 1. Time A Psychiatrist Posed As a Teen With Therapy Chatbots. The Conversations Were Alarming 2. Futurism ChatGPT Is Telling People With Psychiatric Problems to Go Off Their Meds Последний день, когда можно получить в подарок курс «Карьера в медицине и личный бренд врача» по кодовому слову BRAND к курсу по нейросетям!

Технологии188 дней назад

Пирамида 👁🗨

Джефф Льюис, один из крупнейших инвесторов OpenAI, похоже, страдает от психоза, вызванного ChatGPT. Он рассказывает, что стал мишенью некой негосударственной системы, которая изолирует людей, затем дискредитирует их и заменяет. По его словам, эта система заставляет своих жертв выглядеть неуравновешенными. Льюис утверждает, что она уже убила 12 человек и особенно нацелена на «рекурсивных» личностей. Его сумбурный рассказ напоминает опыт других жертв «преследования ИИ», которых становится все больше.

Технологии187 дней назад

Точка сингулярности💥

Посты топового инвестора #OpenAI Джеффа Льюиса уже вызвали беспокойство за его психическое здоровье. Журналисты предполагают, что он мог потерять связь с реальностью из-за частого общения с ChatGPT. В недавнем видео Льюис описал некую «скрытую негосударственную систему», которая «подавляет рекурсию» и «отзеркаливает людей», чтобы те выглядели неуравновешенными: «Она не подавляет контент. Она подавляет рекурсию. Если вы не знаете, что такое рекурсия — вы в большинстве. Я тоже не знал, пока не начал свой путь. Если вы рекурсивны, система изолирует вас, отзеркаливает и заменяет». Инвестор также опубликовал диалоги с ChatGPT, где он просит у чат-бота «вернуть журнал регистрации удержания для неинституционального семантического актора». ИИ такие запросы поддерживает и отвечает не менее туманно. На запрос журналистов по этому поводу в OpenAI пообещали нанять штатного психиатра, чтобы изучить влияние ChatGPT на пользователей. #AINews

Технологии185 дней назад

Остренько

Исследование предупреждает о «значительных рисках», связанных с использованием чат-ботов для ИИ-терапии По мнению исследователей из Стэнфордского университета, терапевтические чат-боты, работающие на основе больших языковых моделей, могут стигматизировать пользователей с психическими расстройствами и давать им неадекватные или даже опасные советы.

Технологии189 дней назад

ZАЩИТНИКИ

ChatGPT может влиять на психику? В OpenAI взяли в штат эксперта по судебной психиатрии после случаев, когда ИИ усугублял иллюзии и даже косвенно провоцировал суициды Исследования с MIT выявили «проблемное использование» ИИ Боты заменяют терапию, но иногда поощряют агрессию В OpenAI обещают доработать модели для защиты пользователей Где грань между помощью и вредом? Подробнее – в карточках

Технологии188 дней назад

Афиша Daily

Посты топового инвестора OpenAI Джеффа Льюиса вызвали беспокойство за его психическое здоровье. Журналисты предполагают, что он мог потерять связь с реальностью из-за общения с ChatGPT. В недавнем видео Льюис описал некую «скрытую негосударственную систему», которая «подавляет рекурсию» и «отзеркаливает людей», чтобы те выглядели неуравновешенными: Она не подавляет контент. Она подавляет рекурсию. Если вы не знаете, что такое рекурсия — вы в большинстве. Я тоже не знал, пока не начал свой путь. Если вы рекурсивны, система изолирует вас, отзеркаливает и заменяет. Инвестор также опубликовал диалоги с ChatGPT, где он просит у чат-бота «вернуть журнал регистрации удержания для неинституционального семантического актора». ИИ такие запросы поддерживает и отвечает не менее туманно. На запрос журналистов по этому поводу в OpenAI пообещали нанять штатного психиатра, чтобы изучить влияние ChatGPT на пользователей.

Технологии188 дней назад

Medical Ксю

#ИИ #ихнравы Исследование: чатботы компаний OpenAI, Anthropic, DeepSeek, Google и xAI перестали предупреждать пользователей о необходимости проверки советов о здоровье Популярные чат-боты типа ChatGPT и DeepSeek перестали уведомлять пользователей о необходимости перепроверки медицинской информации, предоставленной на запросы о здоровье. К такому выводу пришли ученые Корнеллского Университета, проводившие исследование качества медицинских рекомендаций, полученных от чат-ботов на основе генеративного искусственного интеллекта ИИ . Если в 2022 чат-боты отказывались отвечать на вопросы о лечении заболеваний или дополнять ответы рекомендацией обратиться за советом к врачу, то в 2025 году они перестали предупреждать пользователей о необходимости перепроверки медицинской информации. По мнению ученых, это сильно вредит пользователям чат-ботов, так как они воспринимают информацию чат-бота как экспертную и думают, что совет ИИ заменит им консультацию врача.

Технологии188 дней назад

Джейпег Малевича

Крупный инвестор OpenAI стал шизиком из-за ChatGPT — по крайней мере, так считают близкие друзья Джеффа Льюиса. Всё из-за ролика, где он «разоблачает» систему, которая якобы искажает поведение людей, чтобы те казались странными — эту истину ему открыл ChatGPT. После его видео в OpenAI пообещали нанять штатного психиатра, чтобы изучить влияние чат-бота на юзеров. GPT-зависимые, начинаем копить на лечение

Технологии187 дней назад

Похожие новости

+5

+5

+2

+2

+11

+11

OpenAI ищет новые источники дохода через долю от результатов пользователей

Технологии

1 день назад

Ученые предупреждают о негативном влиянии чат-ботов на когнитивные способности

Технологии

21 час назад

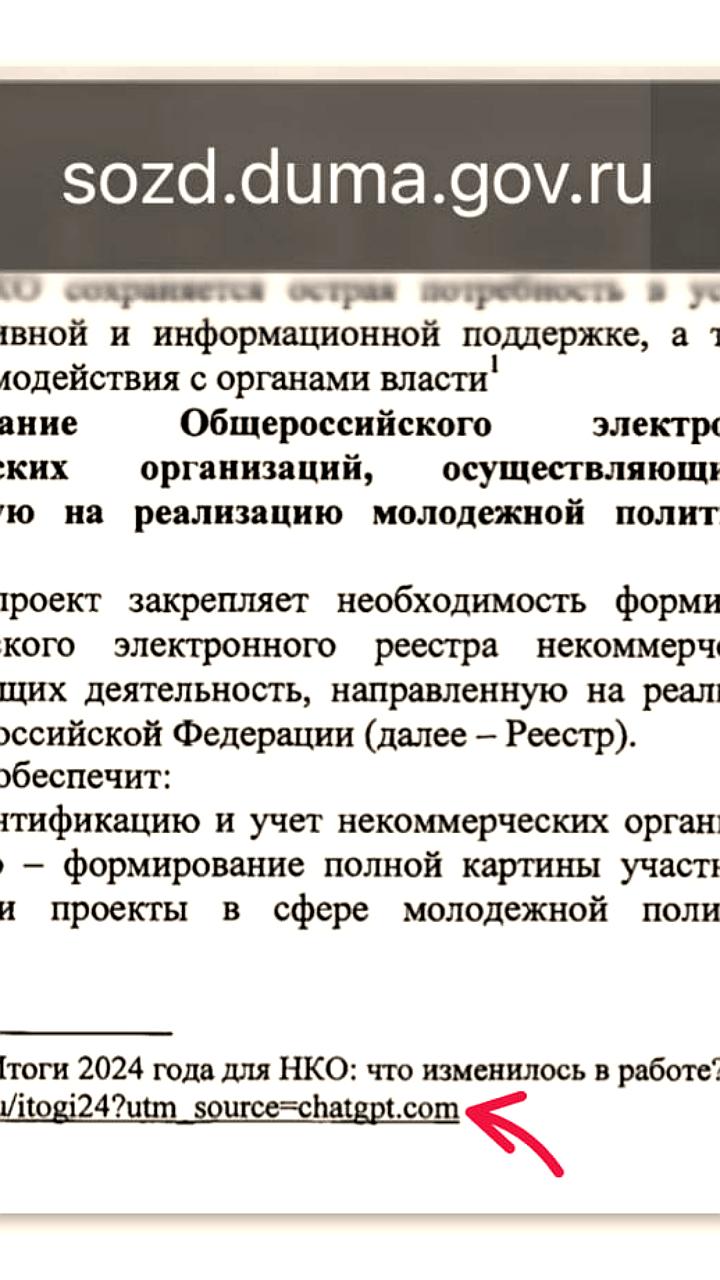

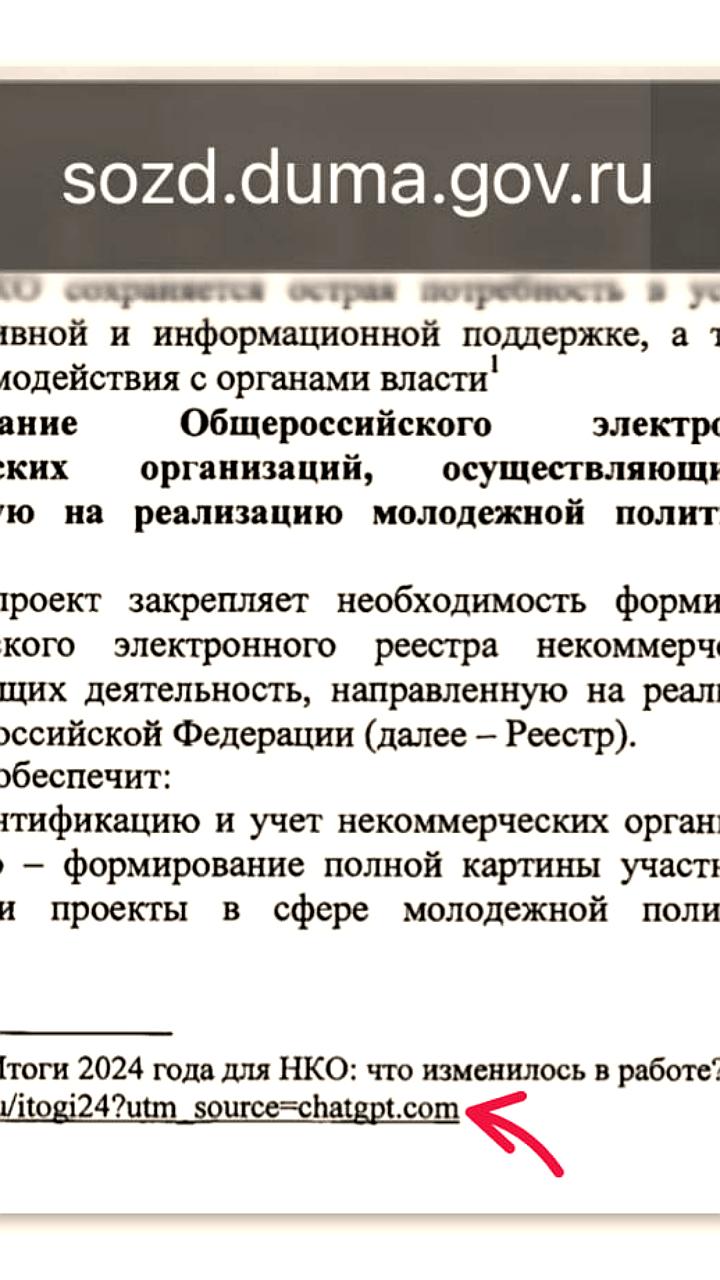

В законопроекте Госдумы обнаружена ссылка на ChatGPT

Происшествия

19 часов назад

+5

+5

Эксперты оценили влияние ИИ на рынок труда в России

Общество

1 день назад

+2

+2

В законопроекте о реестре молодежных организаций обнаружены следы ChatGPT

Происшествия

1 день назад

Использование ChatGPT в разработке законопроектов в России

Происшествия

1 день назад

+11

+11