22 мая, 01:31

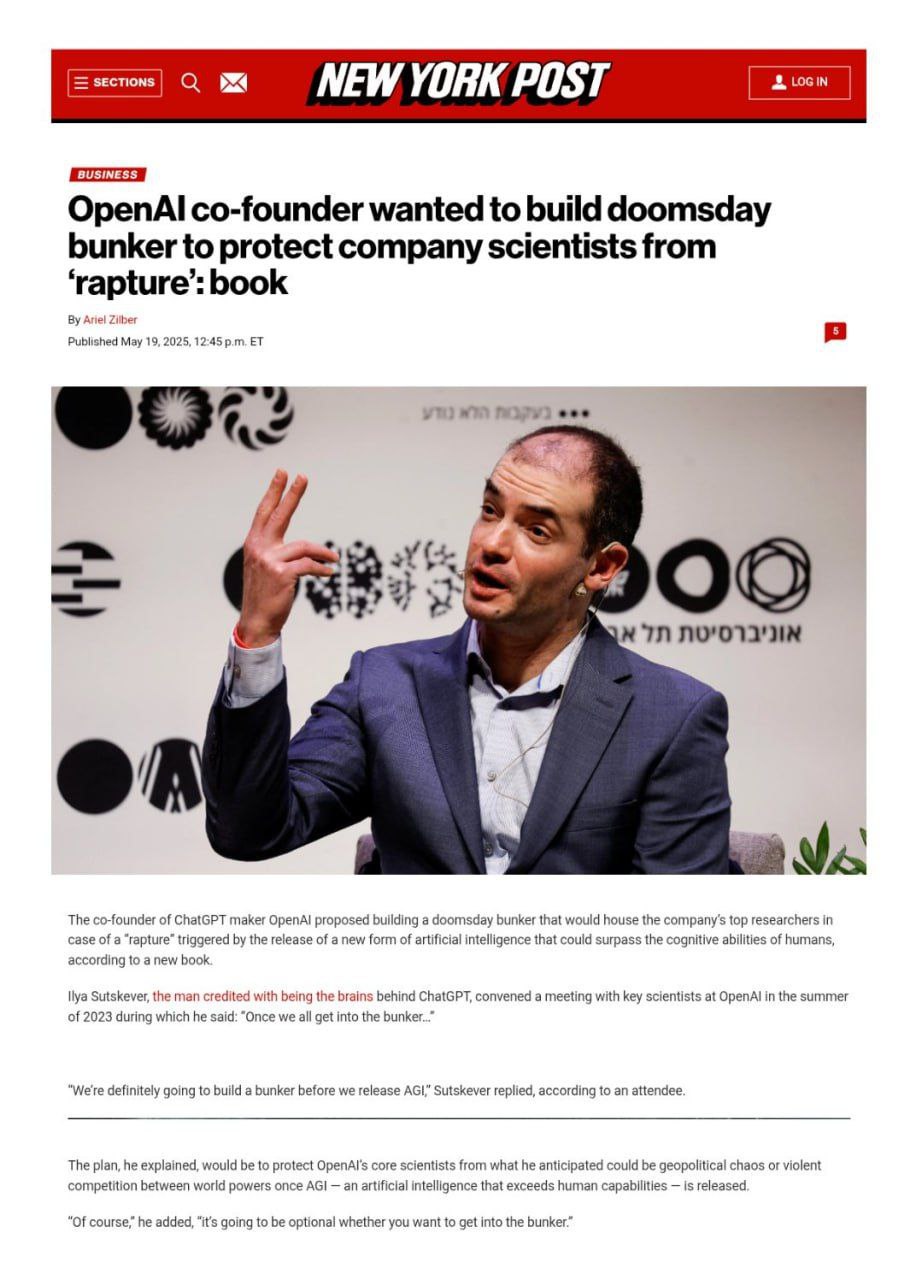

Сооснователь OpenAI планирует бункер для защиты ученых от угроз ИИ

Военный обозреватель

Один из соучредитель компании OpenAI, разработчика искусственного интеллекта, хотел построить бункер Судного дня, чтобы защитить ученых компании до того, как будет выпущен общий искусственный интеллект, понимая его угрозу. #США

Технологии238 дней назад

Машиннное обучение | Наука о данных Библиотека

Илья Суцкевер: "Мы обязательно построим бункер, прежде чем выпустим AGI." Соучредитель OpenAI Илья Суцкевер предлагал построить бункер Судного дня, который мог бы защитить ведущих ресерчеров компании в случае «конца света», вызванного выпуском AGI. Об этом рассказывает Карен Хао в своей книге "Empire of AI: Dreams and Nightmares in Sam Altman s OpenAI". Илья Суцкевер, долгое время считающийся мозгом ChatGPT, сделал комментарий во время встречи с ключевыми учеными компании в 2023 году: «Как только мы все попадем в бункер...», — сказал г-н Суцкевер, но его перебил сбитый с толку коллега: «Простите, в бункер?» На что он ответил: «Мы обязательно построим бункер, прежде чем выпустим AGI». Согласно отрывкам из книги, опубликованным в The Atlantic , это был не первый и не единственный раз, когда Илья затронул эту тему. Два других источника ранее также сообщали Карен Хао, что он регулярно ссылался на бункер во внутренних обсуждениях. Книга доступна к покупке на bookshop.com и у нее, кстати, довольно высокий рейтинг - 4.9 из 5.0 по 21 тысячам отзывов.

Технологии237 дней назад

Сбой в Матрице

Сооснователь OpenAI хочет построить бункер для защиты ученых, если ИИ в итоге выйдет из-под контроля «Мы определенно построим бункер прежде, чем выпустим AGI», — сказал Илья Суцкевер, имея в виду ИИ, который, по прогнозам, превзойдет человеческий интеллект. «Сбой в Матрице»

Технологии238 дней назад

Похожие новости

+1

+1

+2

+2

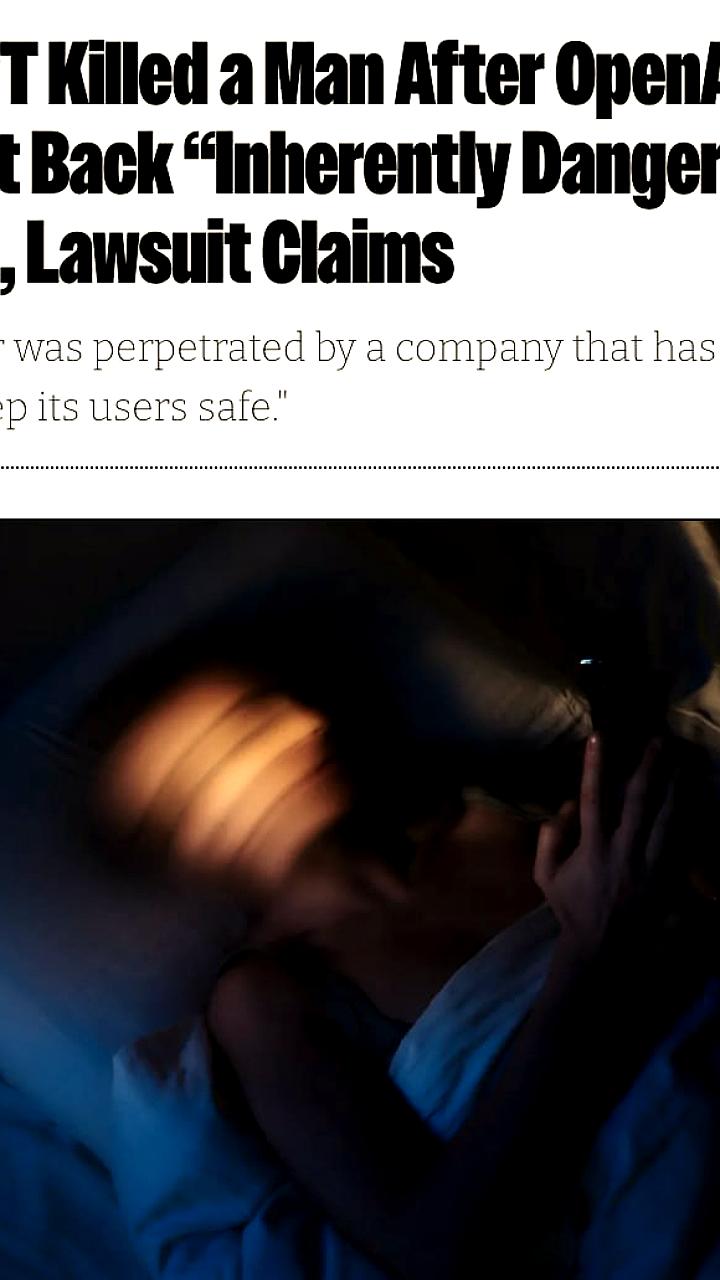

Судебный иск против OpenAI после трагической гибели Остина Гордона, связанной с ChatGPT

Происшествия

16 часов назад

NVIDIA и Eli Lilly создают лабораторию ИИ для разработки лекарств с инвестициями в 1 миллиард долларов

Наука

23 часа назад

Meta сокращает 10 сотрудников в Reality Labs в связи с переходом на искусственный интеллект

Технологии

22 часа назад

+1

+1

OpenAI представила пошаговое руководство по интеграции Codex в рабочие процессы

Технологии

13 часов назад

Конфликты в общественных местах: инциденты в Москве и Ульяновске

Происшествия

1 день назад

+2

+2

Anthropic запускает Claude for Healthcare, новый ИИ для анализа данных о здоровье

Технологии

18 часов назад