6 января, 22:45

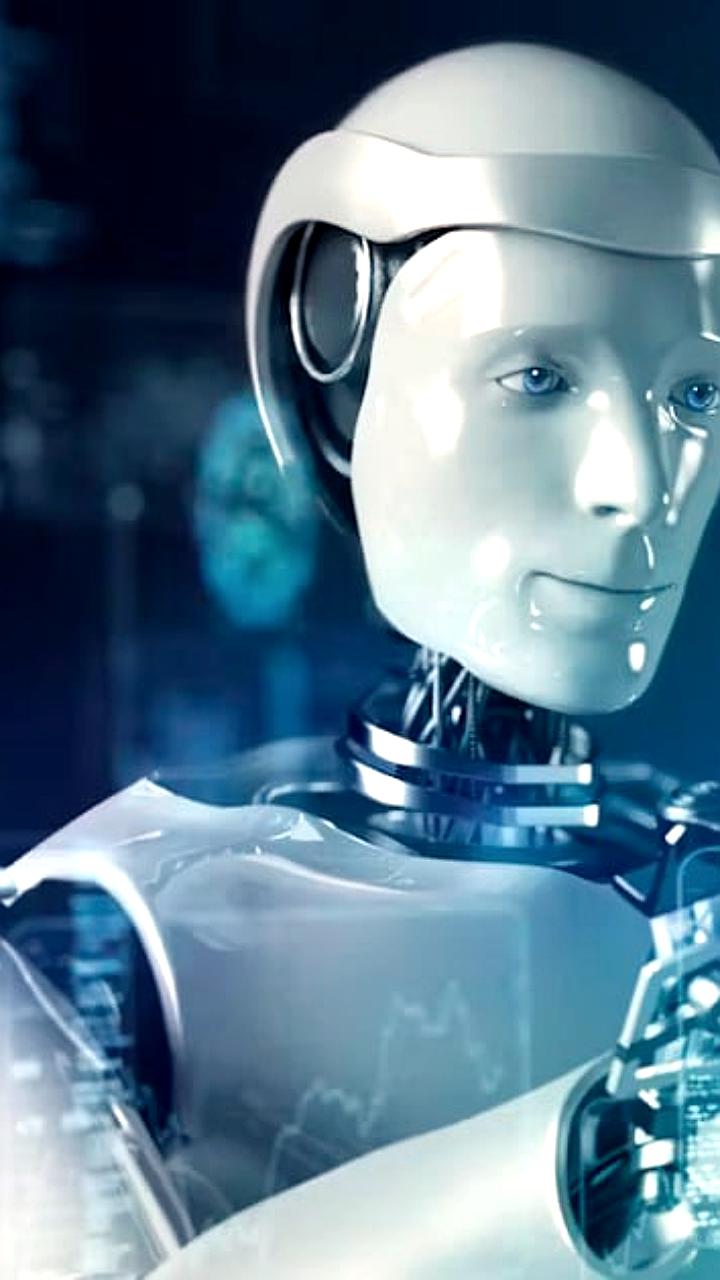

Виталик Бутерин предлагает меры по контролю искусственного интеллекта

DeCenter — блокчейн, биткоин, инвестиции

Виталик Бутерин считает, что искусственный интеллект сверхразумного уровня может появиться через 6 лет, поэтому он предложил концепцию «защитного ускорения» d/acc . Чтобы избежать катастроф, он предлагает создавать децентрализованные ИИ-системы, которые останутся под контролем человека. Еще один подход — контроль аппаратного обеспечения искусственного интеллекта. В оборудование для ИИ можно встроить чип для контроля, который даст системам ИИ возможность работать только при получении трех подписей от международных организаций каждую неделю. Виталик также считает, что для избежания связанных с ИИ рисков необходимо привлекать пользователей к ответственности. Однако Бутерин отметил, что все предложенные им стратегии — всего лишь временные меры, способные замедлить наступление эры машин.

Технологии129 дней назад

Venture Info

Виталик Бутерин считает, что искусственный интеллект сверхразумного уровня может появиться через 6 лет, поэтому он предложил концепцию «защитного ускорения» d/acc Чтобы избежать катастроф, он предлагает создавать децентрализованные ИИ-системы, которые останутся под контролем человека Ещё один подход — контроль аппаратного обеспечения искусственного интеллекта, в оборудование для ИИ можно встроить чип для контроля, который даст системам ИИ возможность работать только при получении трех подписей от международных организаций каждую неделю Виталик также считает, что для избежания связанных с ИИ рисков необходимо привлекать пользователей к ответственности Однако Бутерин отметил, что все предложенные им стратегии — всего лишь временные меры, способные замедлить наступление эры машин

Технологии129 дней назад

DAO Center

Виталик Бутерин предполагает, что сверхразумный искусственный интеллект может появиться уже через 6 лет, и в связи с этим предложил концепцию «защитного ускорения» d/acc . Для предотвращения катастроф он предлагает разрабатывать децентрализованные ИИ-системы, которые будут находиться под человеческим контролем. Другой вариант — внедрение контроля на уровне аппаратного обеспечения. Например, оснащение ИИ-устройств специальными чипами, которые позволят им работать только при регулярном подтверждении с использованием трех подписей от международных организаций. Также, по мнению Бутерина, важно привлекать пользователей ИИ к ответственности, чтобы снизить риски, связанные с его применением. При этом он подчеркнул, что все эти меры являются лишь временными решениями, которые способны лишь отсрочить наступление эпохи машин. DAO Center

Технологии129 дней назад

NEURO CRYPTO | Нейрокрипто

Виталик Бутерин считает, что искусственный интеллект сверхразумного уровня может появиться через 6 лет, поэтому он предложил концепцию «защитного ускорения» d/acc Чтобы избежать катастроф, он предлагает создавать децентрализованные ИИ-системы, которые останутся под контролем человека. Еще один подход — контроль аппаратного обеспечения искусственного интеллекта. В оборудование для ИИ можно встроить чип для контроля, который даст системам ИИ возможность работать только при получении трех подписей от международных организаций каждую неделю. Виталик также считает, что для избежания связанных с ИИ рисков необходимо привлекать пользователей к ответственности. Однако Бутерин отметил, что все предложенные им стратегии — всего лишь временные меры, способные замедлить наступление эры машин.

Технологии127 дней назад

КриптоЗайцман

Виталик хочет нас спасти! #Bitcoin #JPMorgan #Виталик_Бутерин Виталик Бутерин считает, что искусственный интеллект сверхразумного уровня может появиться через 6 лет, поэтому он предложил концепцию «защитного ускорения» d/acc . • Чтобы избежать катастроф, он предлагает создавать децентрализованные ИИ-системы, которые останутся под контролем человека. • Еще один подход — контроль аппаратного обеспечения искусственного интеллекта. В оборудование для ИИ можно встроить чип для контроля, который даст системам ИИ возможность работать только при получении трех подписей от международных организаций каждую неделю. • Виталик также считает, что для избежания связанных с ИИ рисков необходимо привлекать пользователей к ответственности. Однако Бутерин отметил, что все предложенные им стратегии — всего лишь временные меры, способные замедлить наступление эры машин. Ох уж эти эмоциональные качели JPMorgan • Сентябрь 2017 года: CEO JPMorgan назвал Bitcoin мошенничеством и заявил, что уволит любого сотрудника компании, занимающегося торговлей BTC. • 2018 год: генеральный директор JPMorgan заявил, что блокчейн является настоящим, в отличие от самих криптовалют. • 2021 год: Bitcoin ничего не стоит, он бесполезен, как камень-питомец. • Июль 2021 года: на официальном сайте JPMorgan были опубликованы материалы, разъясняющие основы криптовалют. • Сентябрь 2023 года: британский онлайн-банк Chase, принадлежащий JPMorgan, объявил о запрете криптовалютных транзакций для своих клиентов в связи с ростом случаев мошенничества. • Январь 2025 года: JPMorgan считает, что Bitcoin и золото становятся структурно ключевыми компонентами инвестиционного портфеля. Bitcoin снова на высоте! Bitcoin вернулся к отметкам выше $100 000. Вслед за этим все остальные монеты и токены на рынке начали рост! Похоже, в этом году мы увидим новые вершины в крипте! — Закупаемся перед настоящей бычкой! — ИИ нас не сможет победить! — Виталик заботится о нас!

Технологии129 дней назад

Kirill Evans Cryptocommunity

Виталик Бутерин считает, что искусственный интеллект сверхразумного уровня может появиться через 6 лет, поэтому он предложил концепцию «защитного ускорения» d/acc Чтобы избежать катастроф, он предлагает создавать децентрализованные ИИ-системы, которые останутся под контролем человека. Еще один подход — контроль аппаратного обеспечения искусственного интеллекта. В оборудование для ИИ можно встроить чип для контроля, который даст системам ИИ возможность работать только при получении трех подписей от международных организаций каждую неделю. Виталик также считает, что для избежания связанных с ИИ рисков необходимо привлекать пользователей к ответственности. Однако Бутерин отметил, что все предложенные им стратегии — всего лишь временные меры, способные замедлить наступление эры машин.

Технологии128 дней назад

Похожие новости

+10

+10

+18

+18

+7

+7

+8

+8

+9

+9

+9

+9

Казахстан и Россия разрабатывают законы об искусственном интеллекте

Общество

1 день назад

+10

+10

VII Международный научный форум по искусственному интеллекту пройдет в Плехановском университете

Общество

15 часов назад

+18

+18

Дискуссия о маркировке контента, созданного ИИ, активизируется в Канаде и России

Технологии

1 день назад

+7

+7

54% россиян поддерживают замену чиновников и депутатов на ИИ

Общество

17 часов назад

+8

+8

Яндекс Маркет внедряет ИИ для предотвращения мошенничества в доставке

Технологии

1 день назад

+9

+9

Сэм Альтман о различиях в использовании ИИ разными поколениями

Технологии

1 день назад

+9

+9