AI и точка.

Google выпустила экспериментальную Gemini 2.0 Flash — новую версию своей сверхскоростной большой языковой модели. Попробовать уже можно здесь. До конца года корпорация скорее всего покажет и старшую Gemini 2.0. Последняя preview-модель от Google Gemini-1206 до сих пор удерживает лидерство на LMArena.

Технологии10 часов назад

New Yorko Times

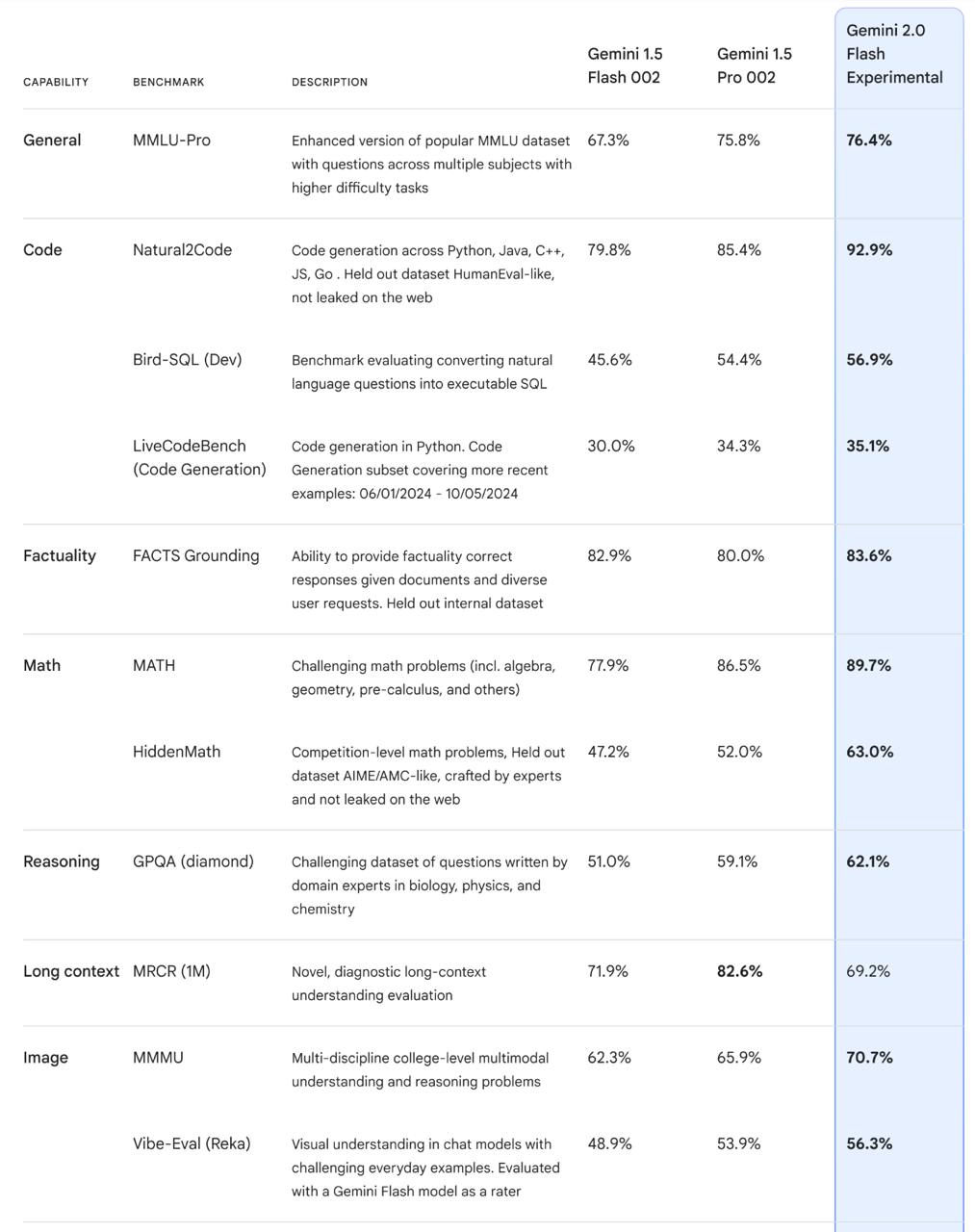

Официально выпустили Gemini 2.0 Flash По бенчмаркам бьёт 1.5 Pro 002, которую выпускали в сентябре, а стоит на порядок дешевле. Как обычно, 2М контекст и супер быстрый инференс на маленьком контексте.

Технологии10 часов назад

AI Для Всех

Deep Research Google выкатил интересное обновление Gemini, про которое напишу вообще все, а я же хочу сосредоточиться на том, что теперь ассистент умеет сам проводить исследования в интернете. Выглядит это так: Вы просите его разобраться в какой-то теме, например "как сейчас развивается рынок беспилотных автомобилей". Gemini составляет план поиска, показывает его вам на проверку, а потом начинает самостоятельно искать информацию в сети. Он не просто собирает первые попавшиеся ссылки, а действует как настоящий исследователь - находит что-то интересное, копает глубже на основе найденного, проверяет разные источники. В итоге выдает структурированный отчет со всеми ссылками, который можно сразу выгрузить в Google Docs. Представьте: вместо того чтобы часами сидеть с десятком открытых вкладок, делая пометки и пытаясь не утонуть в информации, вы получаете готовый обзор за несколько минут. При этом можете его обсудить с ассистентом и попросить что-то уточнить или переделать. Пока Deep Research так называется эта функция доступен только в платной версии Gemini Advanced и работает на десктопе. В мобильное приложение обещают добавить в начале 2025 года. А еще Google выпустил экспериментальную версию новой модели - Gemini 2.0 Flash. Она работает быстрее и умнее, но пока находится в режиме тестирования. Попробовать можно уже сейчас - просто выберите ее в выпадающем меню моделей. И вот, мы стали еще на шажок ближе к тому моменту, когда ИИ-ассистенты действительно начнут освобождать нас от рутинной работы, а не просто отвечать на вопросы Блог-пост

Технологии9 часов назад

Сиолошная

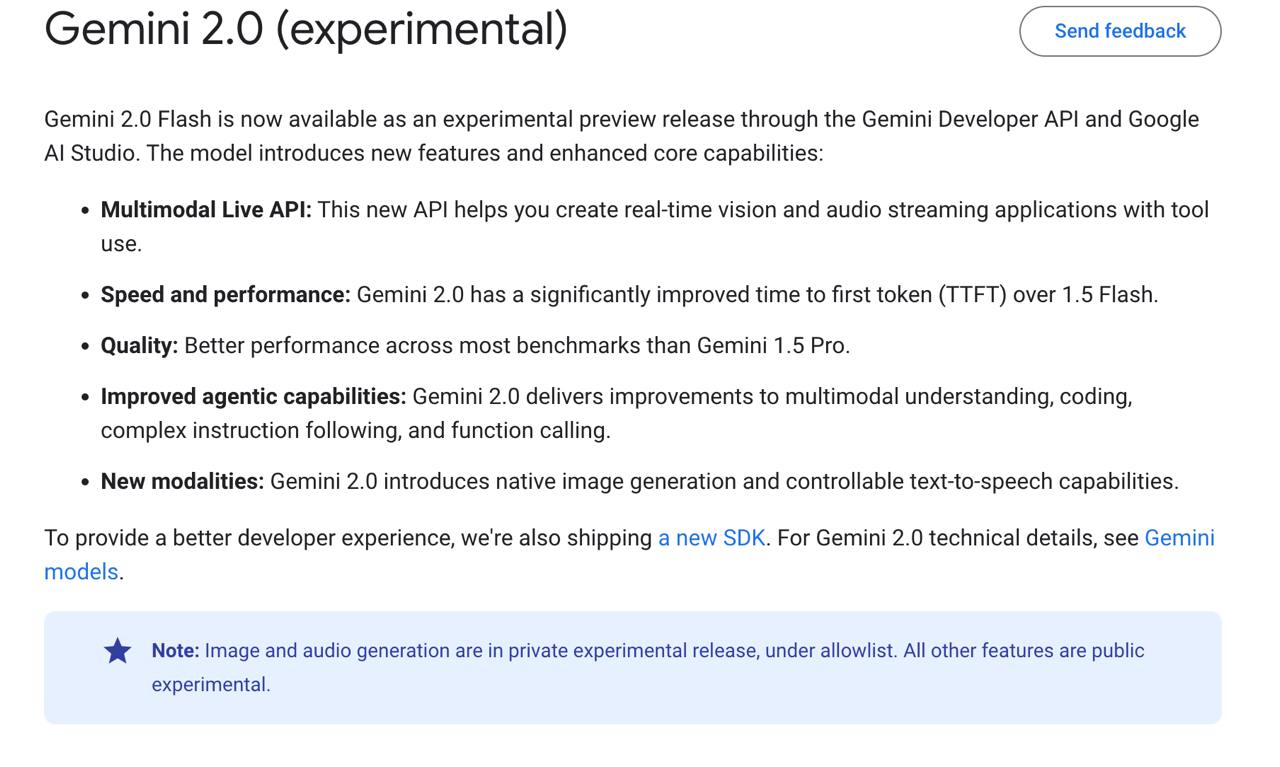

Кроме этого, напоминаю, что на этой неделе ждём, пока разродится гигант: Google должны показать Gemini 2.0 У некоторых пользователей Gemini уже появилась Flash-версия. И даже в документации есть страница! Основные улучшения: — поддержка стрима аудио- и видео-потока в реальном времени чтобы давать опыт, схожий к Advanced Voice Mode у OpenAI — модель быстрее Flash 1.5, и в то же время лучше на многих бенчмарках ну тут не сомневались, а вот что быстрее - интересно — Improved agentic capabilities ! , ждём первых замеров — Модель умеет генерировать изображения GPT-4o тоже умеет, просто эту фичу не включили для нас , а также контролируемо генерирует речь. Ссылка попробовать в AI Studio только текст, зато 1М контекста : тык

Технологии10 часов назад

New Yorko Times

Gemini Flash 2.0 готова порвать бенчмарки типа соотношение цена/качество/скорость впечатляет. А у можно почитать про работу над топовыми LLM из первых рук

Технологии10 часов назад

![Google начинает эру Gemini 2.0 с Gemini 2.0 Flash! Снизу будет кратко рассказано, какие возможности открывает эта модель. 1 [Gemini 2.0 Flash] доступен в виде экспериментального предварительного выпуска основной модели 2.0. Он может одновременно работать с аудио, видео и текстом. Контекстное окно 1 млн токенов. Попробовать можете прямо [сейчас] 2 [Deep Research] — Создает многоэтапные планы исследований, которые вы утверждаете. Использует Google Search для просмотра, как это делает человек. Составляет комплексные отчеты со ссылками на источники. Будет доступен в [Gemini web] 3 [Project Mariner] — Агент ИИ, который может использовать Chrome для вас. Понимает все на экране. Работает только в активной вкладке + требует подтверждения для конфиденциальных действий. 4 [Project Astra] — теперь использует Google Search, Lens & Maps в режиме реального времени. Имеет 10 минут памяти во время сеанса, а так же лучшее понимание языка. Еще показали, что Gemini 2.0 может быть вашим виртуальным игровым помощником. Он наблюдает за игрой в режиме реального времени. Понимает контекст на экране, ищет и предлагает идеи. Демо показали с Supercell. Всё, кроме первого пункта, будет доступно в 2025 году. Подробнее рассказано [тут] #news](https://content.tek.fm/0ca255a0-b487-495d-9c6e-f90cd62b0cea.jpg)

Нейросфера: нейросети, технологии

Google начинает эру Gemini 2.0 с Gemini 2.0 Flash! Снизу будет кратко рассказано, какие возможности открывает эта модель. 1 [Gemini 2.0 Flash] доступен в виде экспериментального предварительного выпуска основной модели 2.0. Он может одновременно работать с аудио, видео и текстом. Контекстное окно 1 млн токенов. Попробовать можете прямо [сейчас] 2 [Deep Research] — Создает многоэтапные планы исследований, которые вы утверждаете. Использует Google Search для просмотра, как это делает человек. Составляет комплексные отчеты со ссылками на источники. Будет доступен в [Gemini web] 3 [Project Mariner] — Агент ИИ, который может использовать Chrome для вас. Понимает все на экране. Работает только в активной вкладке + требует подтверждения для конфиденциальных действий. 4 [Project Astra] — теперь использует Google Search, Lens & Maps в режиме реального времени. Имеет 10 минут памяти во время сеанса, а так же лучшее понимание языка. Еще показали, что Gemini 2.0 может быть вашим виртуальным игровым помощником. Он наблюдает за игрой в режиме реального времени. Понимает контекст на экране, ищет и предлагает идеи. Демо показали с Supercell. Всё, кроме первого пункта, будет доступно в 2025 году. Подробнее рассказано [тут] #news

Технологии8 часов назад

Похожие новости

+9

+9

+12

+12

+2

+2

+10

+10

+58

+58

+8

+8

Google анонсирует запуск модели искусственного интеллекта Gemini 2.0

Технологии

7 часов назад

+9

+9

Госуслуги запустили бета-версию обновленного Робота Макса с ИИ-технологиями

Технологии

8 часов назад

+12

+12

Рост спроса на ИИ-решения в России: новые тренды и технологии

Технологии

1 день назад

+2

+2

YouTube внедряет автоматический ИИ-дубляж видео на девяти языках

Технологии

15 часов назад

+10

+10

Владимир Путин ознакомился с умным кольцом Sber на выставке AI Journey

Технологии

11 часов назад

+58

+58

Яндекс Документы обновились: новые редакторы и возможности с YandexGPT

Технологии

11 часов назад

+8

+8