6 сентября, 14:15

Новая нейросеть Reflection 70B превосходит конкурентов и выходит в открытый доступ

Эксплойт

ChatGPT убила БЕСПЛАТНАЯ модель — Reflection 70B только что стал новым королём нейросетей. — Модель разорвала GPT-4o, Claude 3.5 и другие модели. Альтман и команда в шоке; — ИИ умеет думать и исправлять свои же ошибки на ходу; — На следующей неделе выпустят версию 405B, которая официально станет самой мощной нейронкой в мире; — БЕСПЛАТНО и прямо у вас на компьютере. Сама модель здесь, играемся в браузере здесь сайт может упасть от наплыва .

Технологии508 дней назад

Хайтек+

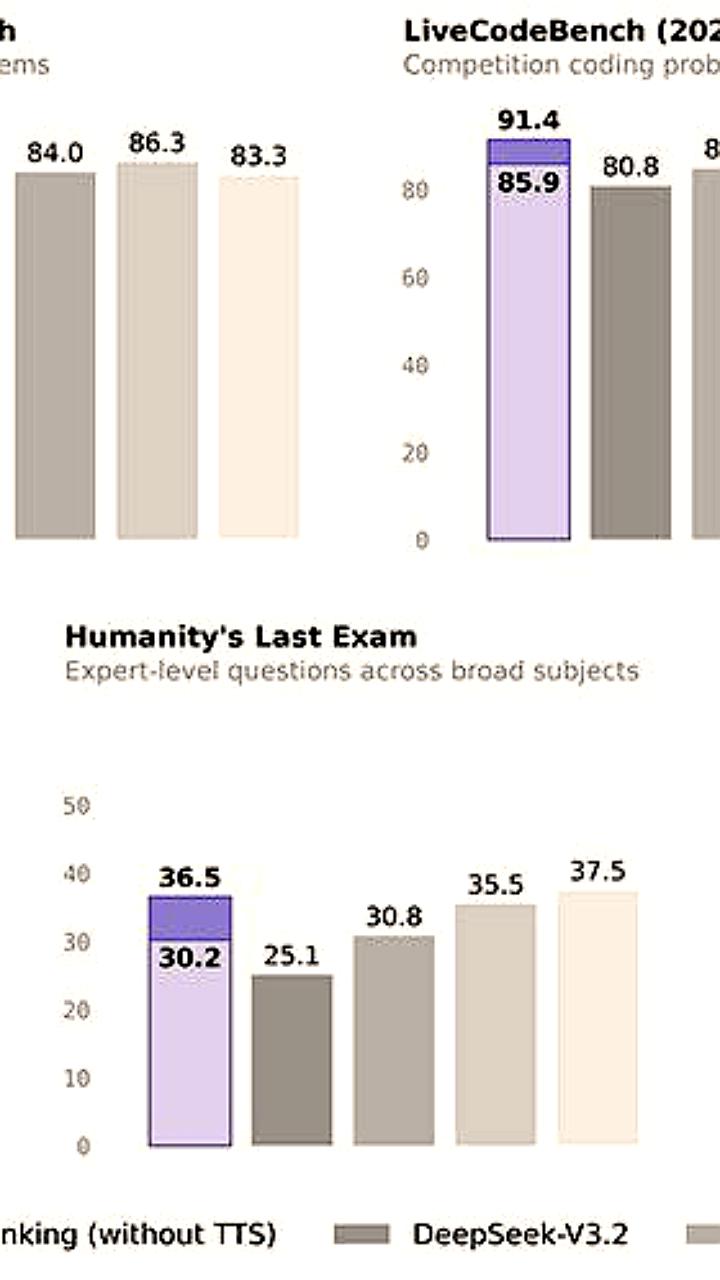

HyperWrite выпустила самую мощную открытую БЯМ: она исправляет саму себя Стартап HyperWrite представил новую большую языковую модель Reflection 70B. Она основанная на Llama 3.1-70B Instruct от Meta компания признана экстремистской и запрещена в РФ и выделяется инновационным методом самокоррекции ошибок. Это решает проблему галлюцинаций и повышает точность ответов. В тестах Reflection 70B превзошла модели Llama, а разработчики называют ее «лучшей в мире моделью ИИ с открытым исходным кодом». Reflection 70B уже доступна для загрузки, а в ближайшее время планируется запуск еще более мощной модели Reflection 405B, которая, как ожидается, составит конкуренцию лидерам индустрии ИИ, например, GPT-4o.

Технологии508 дней назад

Tehnobzor: IT Технологии

Новая мощная нейросеть, которая может заменить ChatGPT. В открытый доступ вышла Reflection 70B — нейронка превосходит даже GPT-4o и Claude 3.5 Sonnet, а главное — способна исправлять свои же ошибки на ходу. Работает бесплатно, установить можно здесь, а здесь — попробовать прямо в браузере. Tehnobzor: IT Технологии

Технологии502 дня назад

Data Secrets

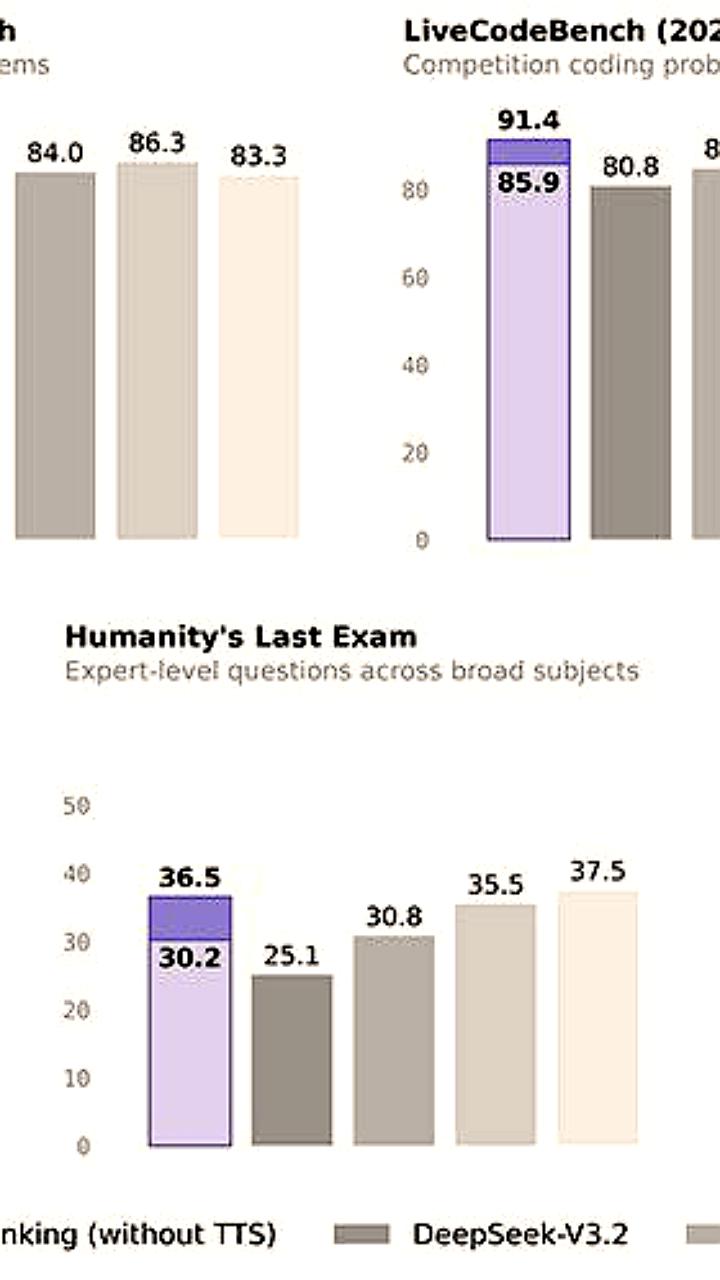

Интернет взрывает новая модель Reflection 70В от Meta: она выбивает на бенчмарках результаты, превосходящие Claude 3.5 Sonnet и GPT-4o Название Reflection выбрано в честь метода Reflection-Tuning: это когда модель итеративно обучается на синтетических структурированных данных, чтобы научиться рассуждать и самокорректироваться. Плюсом добавлен отдельный этап планирования для улучшения CoT. В качестве инициализации брали Llama 3.1 70B. На практике модель прямо в ответах оборачивает все рассуждения в тег <reasoning>, а возможные ошибки в тег <reflection>. Затем она обнаруженные ошибки исправляет, и итоговый ответ выдает в теге <output>. Результаты на бенчмарках: 89,9% MMLU, 79,7% MATH, 90,1% IFEval, 99.2% GSM8K. Говорят, что тот самый синтетический датасет и техрепорт будет на следующей неделе. А еще на следующей неделе обещают Reflection на 405В Сама модель уже доступна на HuggingFace.

Технологии508 дней назад

Похожие новости

+2

+2

+3

+3

+4

+4

Alibaba анонсировала мощную модель ИИ Qwen 3 Max Thinking

Технологии

21 час назад

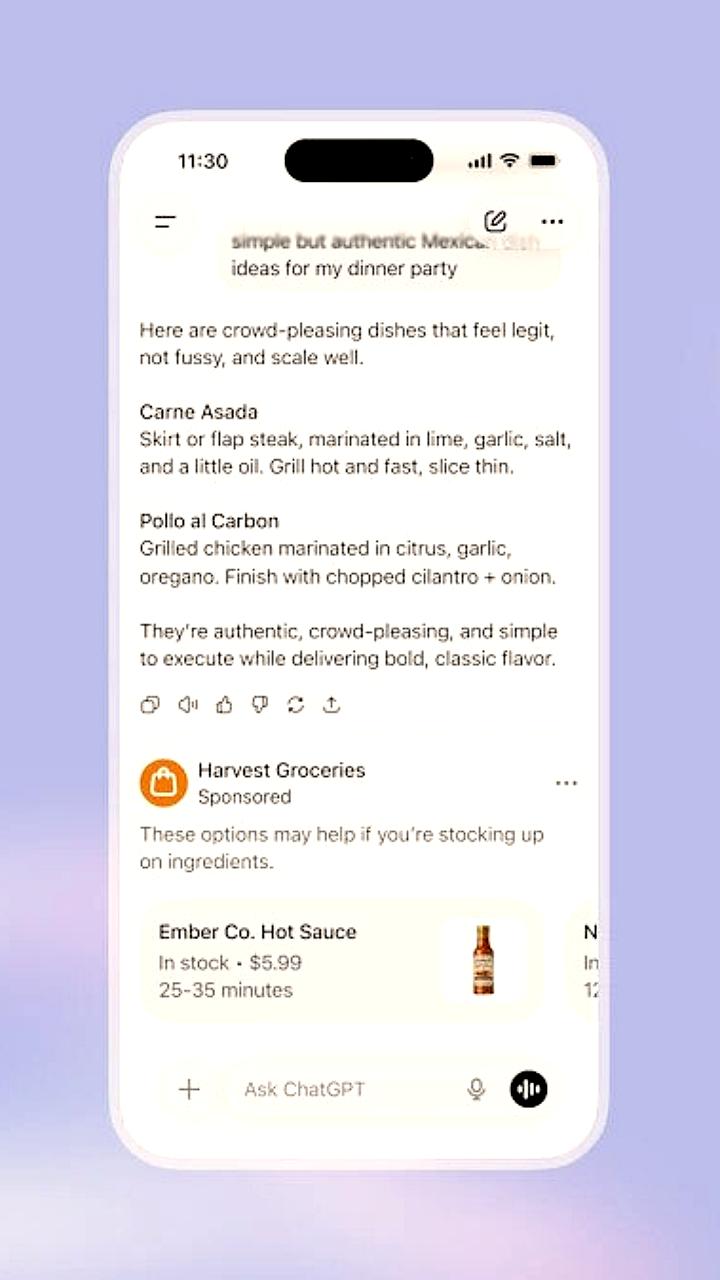

OpenAI устанавливает высокие цены на рекламу в ChatGPT, несмотря на ограничения

Технологии

5 часов назад

+2

+2

Microsoft анонсировала новый ИИ чип Maia 200 для GPT-5

Технологии

19 часов назад

+3

+3

Определение зоны гениальности с помощью ChatGPT: новый подход к самопознанию

Общество

18 часов назад

Запуск Clawd: новый ИИ-ассистент для автоматизации задач

Технологии

1 день назад

+4

+4

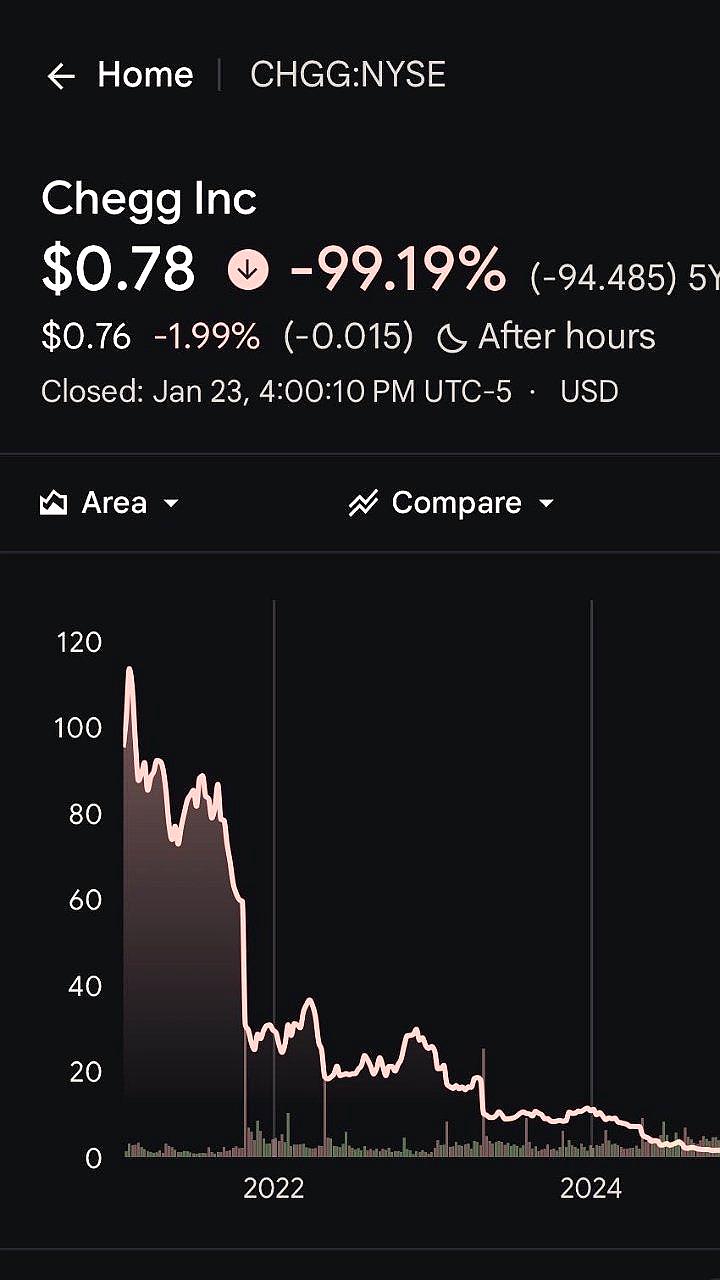

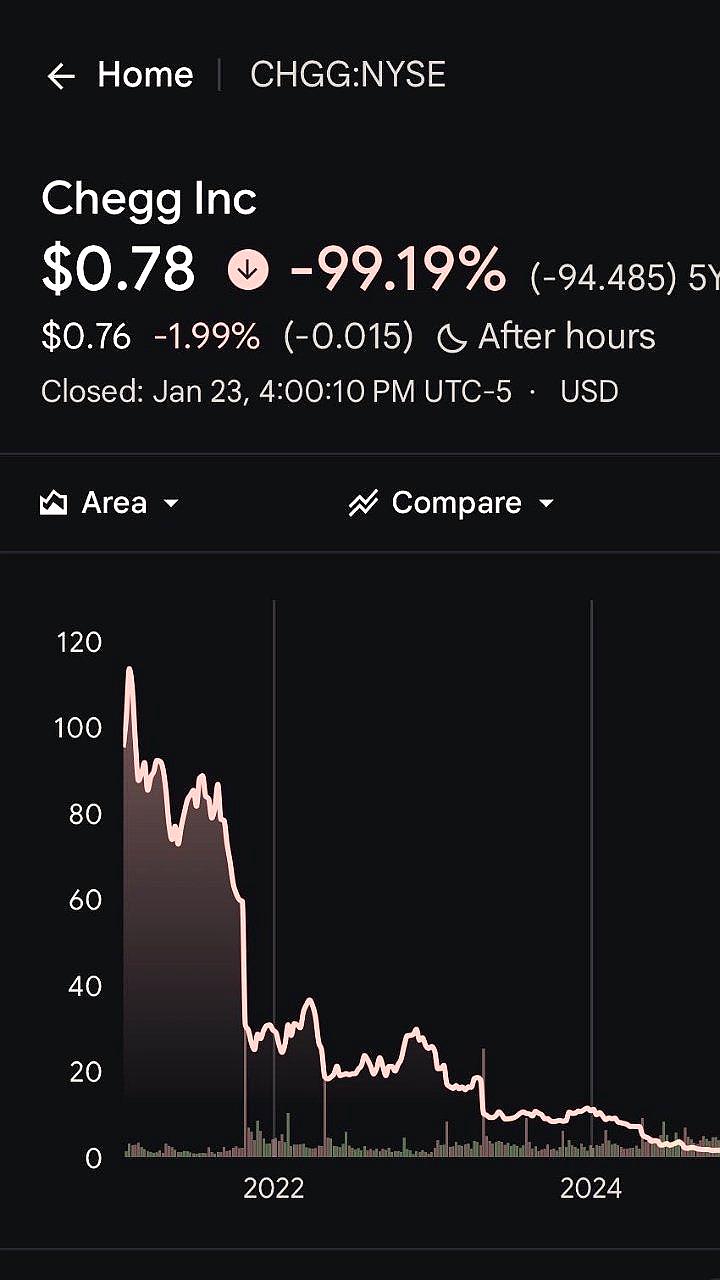

Chegg прекращает работу после 20 лет из-за влияния ChatGPT

Общество

3 часа назад