AI и точка.

OpenAI выпустили две новые открытые модели для задач классификации безопасности gpt oss safeguard основаны на семействе gps oss имеют те же размеры 20B и 120B Нейросети предназначены для применения правил безопасности к контенту фильтрации или маркировки Например форум об играх может настроить бота который будет распознавать обсуждения о читах или онлайн магазин сможет выявлять поддельные отзывы Веса выложены на Hugging Face

Технологии90 дней назад

GPT/ChatGPT/AI Central Александра Горного

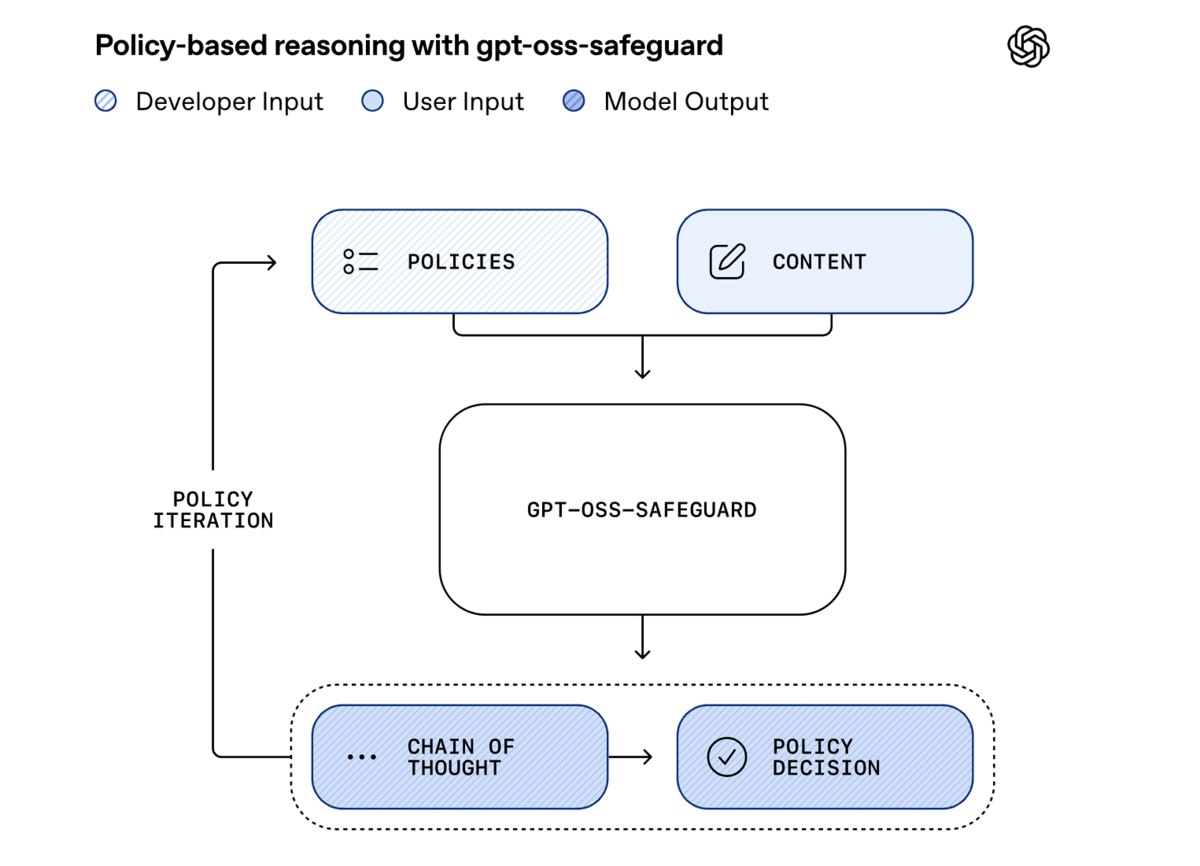

OpenAI выпустила бесплатные модели для модерации контента Модели gpt oss safeguard 120b и gpt oss safeguard 20b обучены искать опасный или неприемлемый контент Например они могут искать на сайте поддельные отзывы или токсичные комментарии Политику задаёт разработчик Как и базовая gpt oss модели умеют рассуждать и показывать цепочку мыслей которая привела к принятию решения Скачать можно тут huggingface co collections openai gpt oss safeguard

Технологии89 дней назад

vc.ru

OpenAI выпустила открытые модели gpt oss safeguard которые оптимизированы для модерации контента отзывов комментариев и запросов пользователей Они учитывают индивидуальные правила площадок указанные разработчиками Веса моделей выложили на Hugging Face vc ru ai 2308077

Технологии89 дней назад

Data Secrets

OpenAI релизнули две новые открытые модели gpt oss safeguard 20B и 120B Они основаны на gpt oss и обучены специально для задач классификации текста на предмет безопасности Важно что правила фильтрации не сразу зашиты в модель а определяются самим пользователем уже на этапе инференса и могут быть какими угодно Это что то новенькое И вообще кажется что область очень узкая Но на самом деле задач связанных со всевозможной модерацией контента вокруг море и с ростом популярности ИИ их становится еще больше И в этом смысле модели актуальные OpenAI пишут что работают они прямо отлично но только при условии что вы зададите четкие непротиворечивые инструкции Если политика продуманная то gpt oss safeguard якобы смогут обрабатывать даже сложные пограничные случаи Внутри стартапа эти модели уже частично используются для оценки безопасности запросов и элаймента моделей Это удобно потому что в разных случаях политика может быть разная для несовершеннолетних пользователей одна для самих моделей другая для бизнеса третья И обучать несколько разных классификаторов не нужно достаточно задать одной и той же модели разные инструкции и она подстроится openai com index introducing gpt oss safeguard

Технологии90 дней назад

Похожие новости

+4

+4

+2

+2

+3

+3

+11

+11

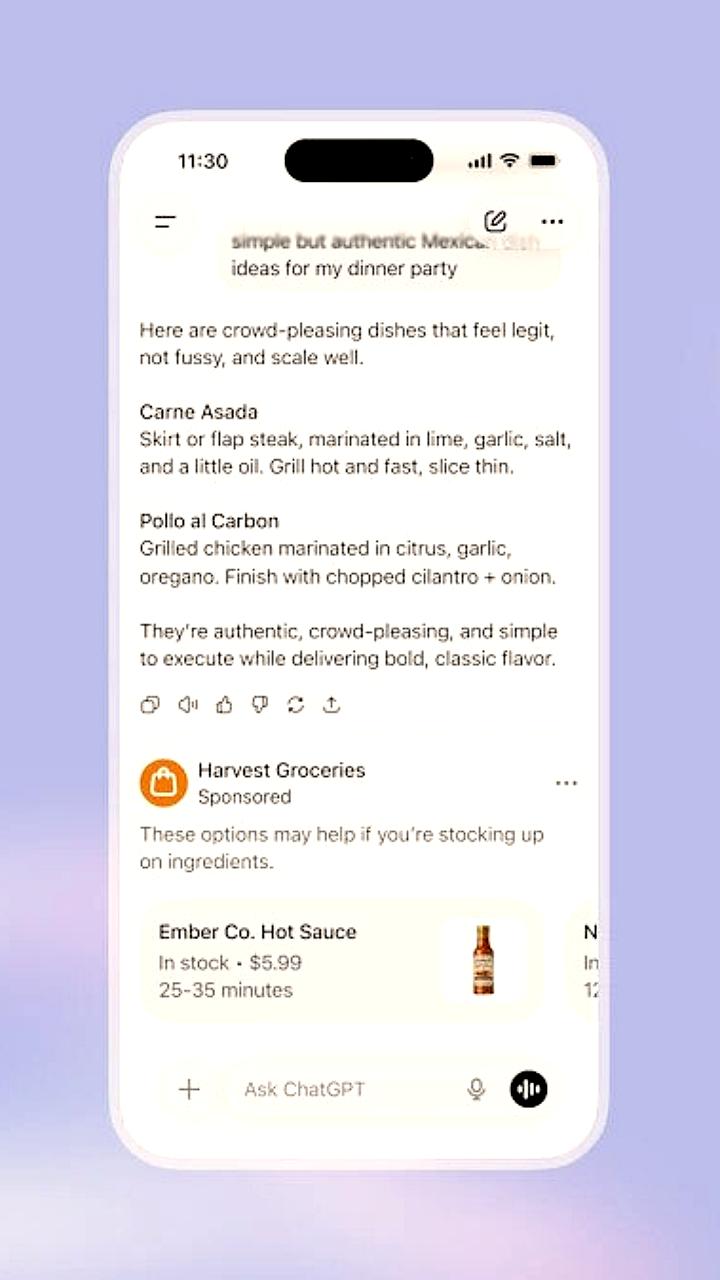

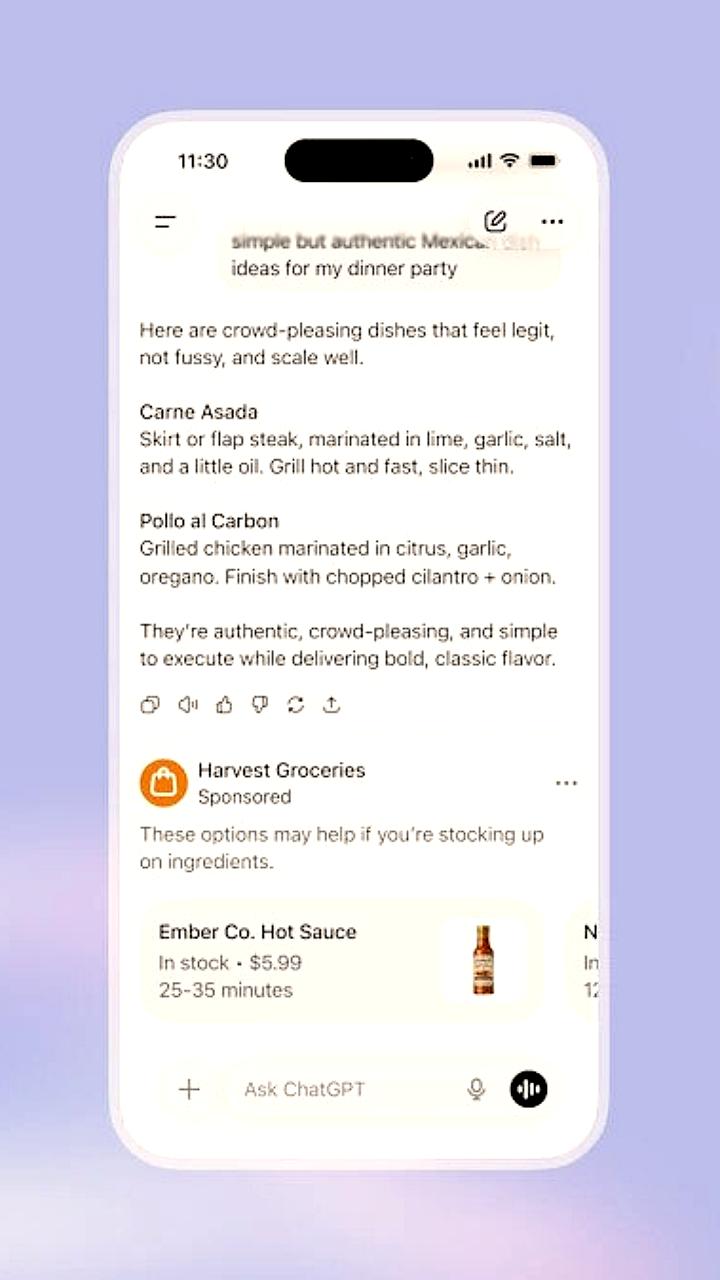

OpenAI устанавливает высокие цены на рекламу в ChatGPT, несмотря на ограничения

Технологии

6 часов назад

+4

+4

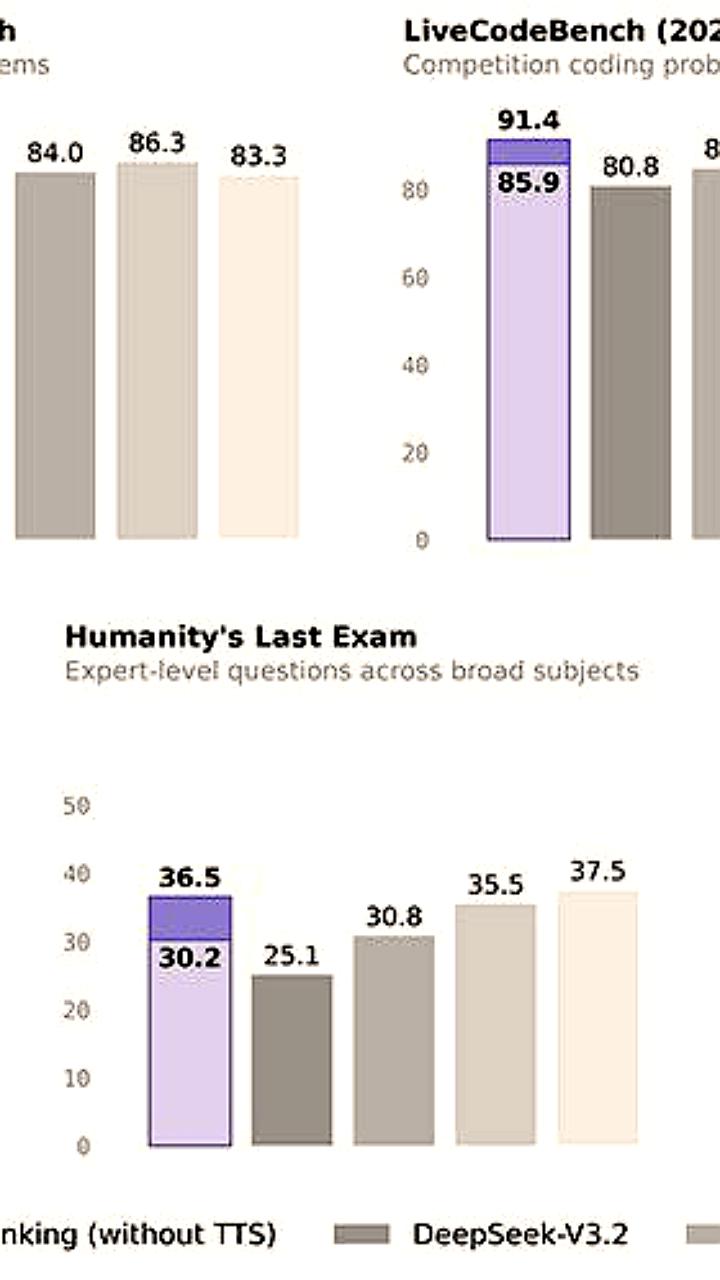

Alibaba анонсировала мощную модель ИИ Qwen 3 Max Thinking

Технологии

22 часа назад

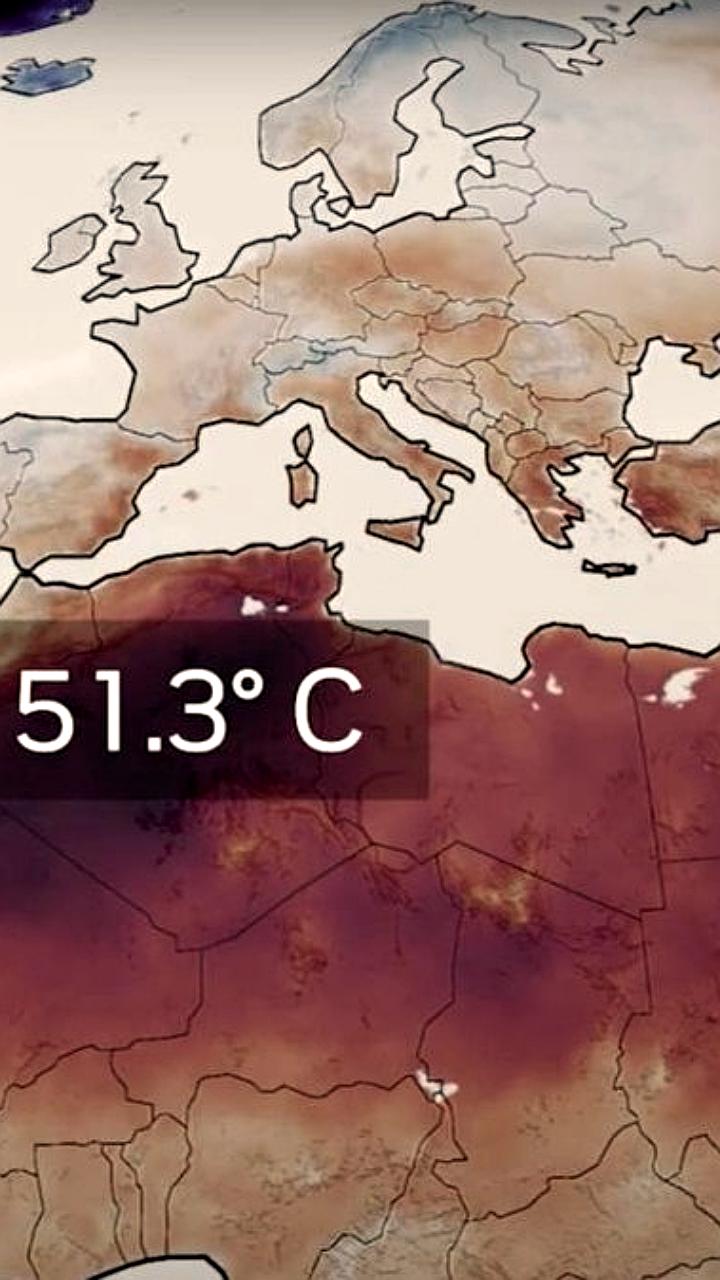

NVIDIA запускает платформу Earth 2 для улучшения метеопрогнозов с помощью ИИ

Технологии

22 часа назад

+2

+2

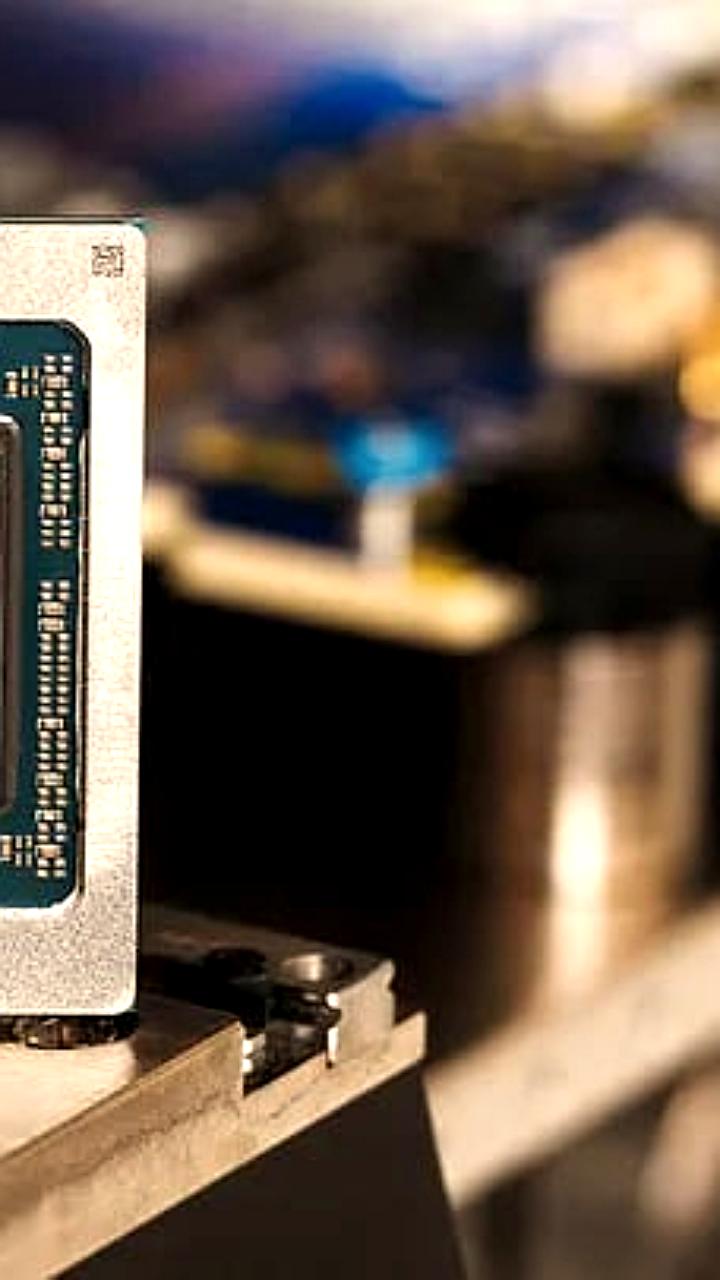

Microsoft анонсировала новый ИИ чип Maia 200 для GPT-5

Технологии

20 часов назад

+3

+3

Еврокомиссия инициировала расследование против чат бота Grok за создание неприемлемого контента

Происшествия

1 день назад

+11

+11

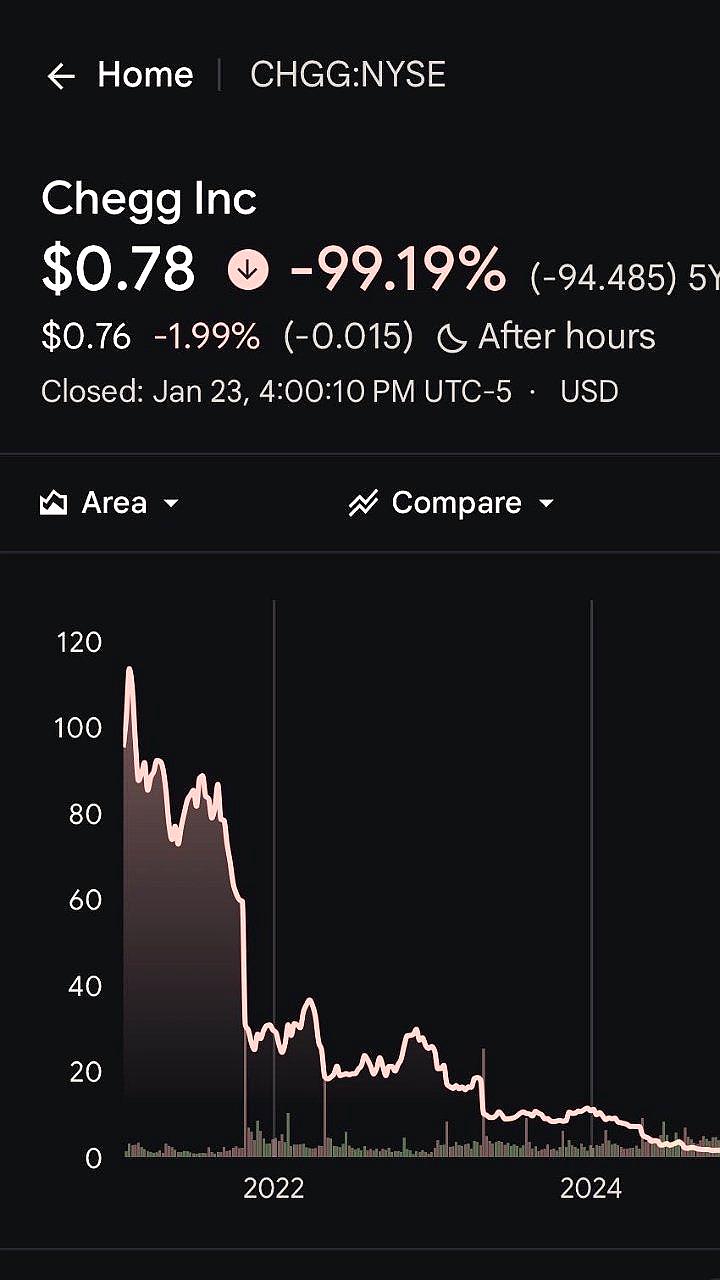

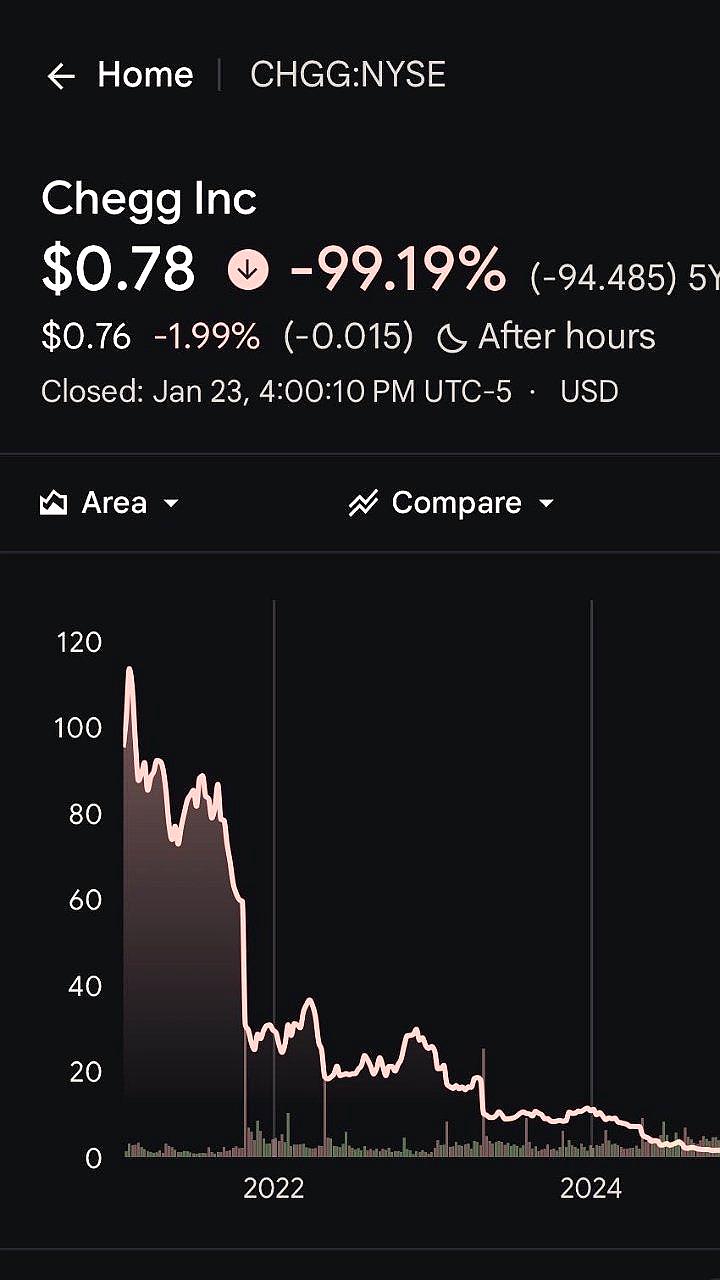

Chegg прекращает работу после 20 лет из-за влияния ChatGPT

Общество

4 часа назад