7 сентября, 20:50

OpenAI исследует причины 'галлюцинаций' нейросетей и предлагает изменить систему оценок

Denis Sexy IT 🤖

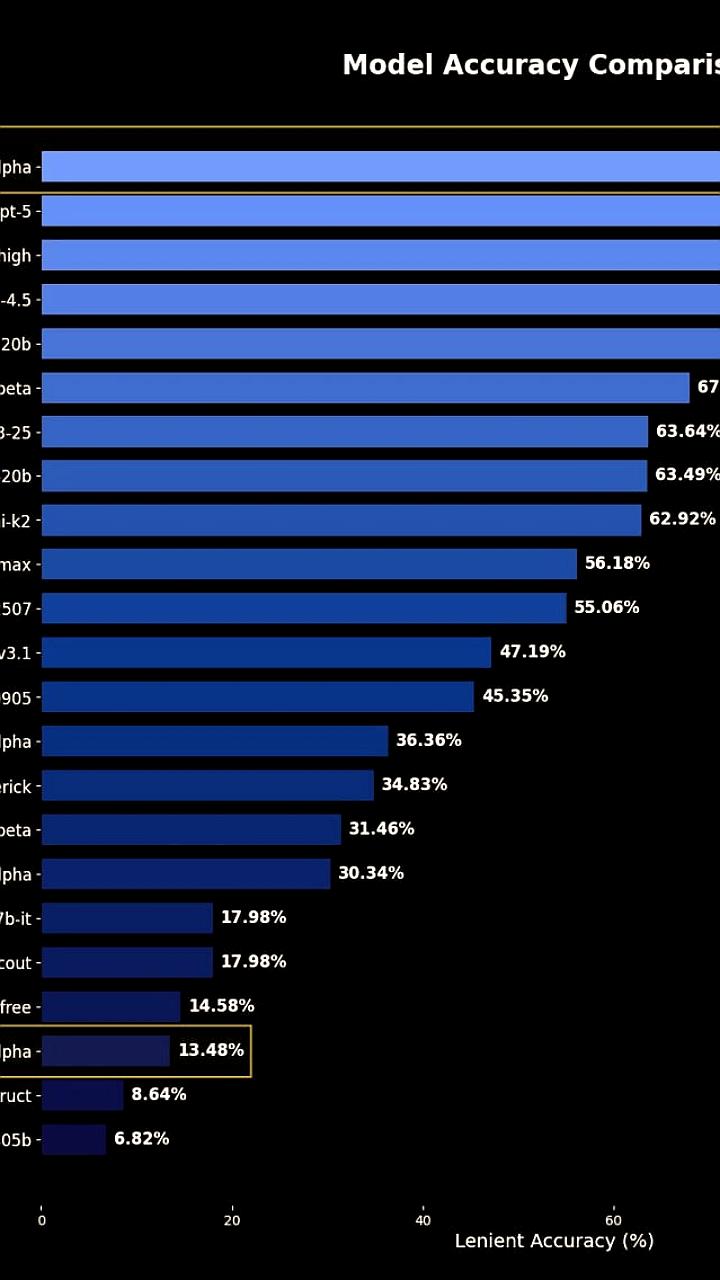

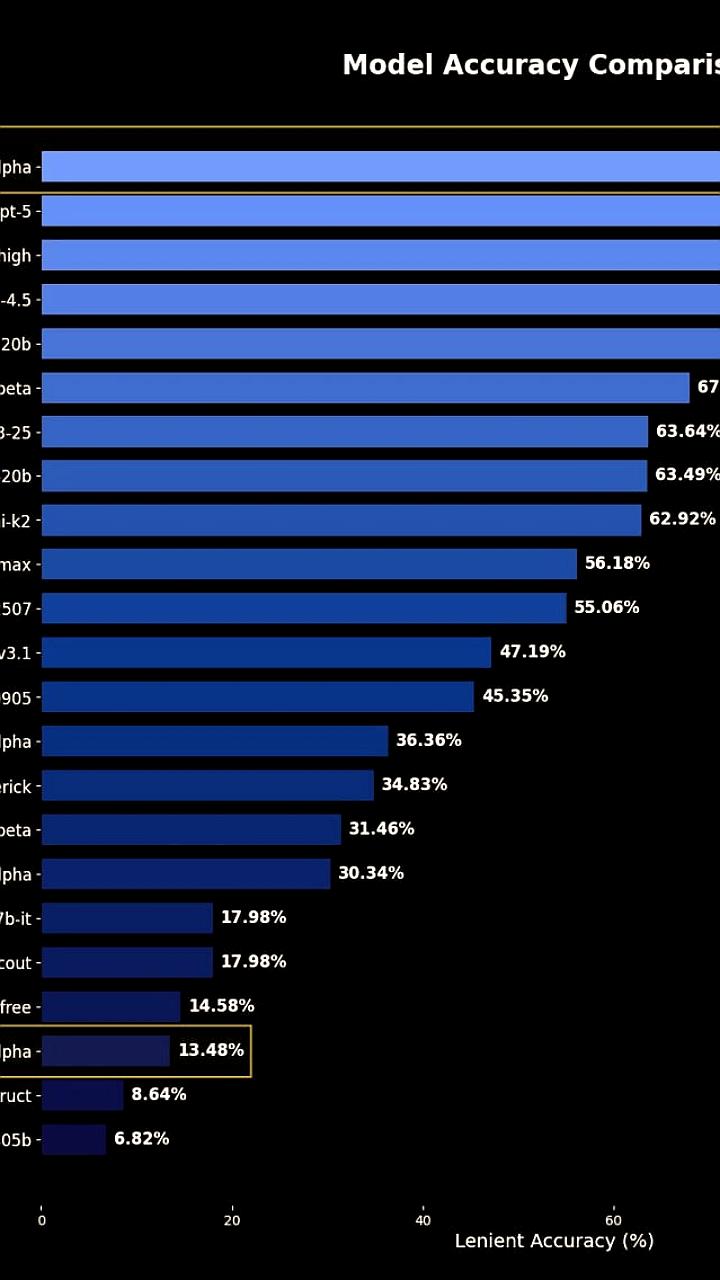

Там OpenAI опубликовали новый ресёрч оказывается нейронки галлюцинируют и врут не потому что чугунные шизоиды на транзисторах а потому что их ещё при обучении натаскали угадывать ответы а не честно говорить Я не знаю ответ на этот запрос Представить это легко вспомните себя в школе универе во время какого либо экзамена Вы не знаете например сколько ног у медузы но если написать от балды тринадцать с половиной есть шанс тупо угадать и получить балл Если же написать не знаю это сразу ноль баллов Вот нейроночки живут по такому же мясному принципу Проблема в том что бенчмарки ИИ моделей сейчас оценивают модели по количеству правильных ответов Поэтому лучше быть уверенным дебилом чем скромным умником OpenAI предлагают менять правила штрафовать модельки за наглую чушь награждать за честное я не уверен я не знаю Пример старая модель угадывала точнее но врала в 3 раза чаще Новая чаще молчит зато меньше выдумывает Короче галлюцинации это не баг а математика Модель не может знать всё но может научиться не строить из себя всезнайку Идеал будущего чат бот который отвечает на 90 вопросов словами Братан я не в теме не знаю ответ на твой вопрос иди сам погугли но зато ни разу не обманывает тут сама статья

Технологии2 дня назад

OpenAI

Исследователи OpenAI утверждают что постоянная проблема галлюцинаций у чат ботов ИИ связана с методами обучения и оценки языковых моделей а не с какими то загадочными техническими недостатками В исследовании компания по разработке искусственного интеллекта объясняет что современные системы оценки по сути учат модели блефовать а не признавать свою неуверенность В работе опубликованной совместно с партнёрами из Технологического института Джорджии основная причина такой проблемы объясняется фундаментальным несоответствием критериев оценки даже продвинутые модели такие как GPT 5 продолжают делать уверенные но неверные заявления Галлюцинации появляются не из за конструктивных ошибок а из за факторов обучения при которых модели поощряются за догадки а не за честное указание на свою неуверенность

Технологии16 часов назад

DNS_Club

OpenAI утверждает что изжить галлюцинации LLM невозможно но ИИ нужно наказывать за ошибки Исследователи OpenAI предположили что галлюцинации языковых моделей связаны не только с процессом обучения но и с неверными стимулами при их оценке Они предлагают изменить систему тестов чтобы модели не поощрялись за случайные догадки Новый научный труд компании задается вопросом почему даже современные языковые модели вроде GPT 5 и чат боты типа ChatGPT продолжают выдавать правдоподобные но ошибочные высказывания

Технологии8 часов назад

Rozetked

Галлюцинации нейросетей не баг а фича OpenAI выпустила исследование о том почему LLM продолжают выдавать уверенные но ложные ответы Причина в системе оценок я не знаю засчитывается как ошибка поэтому моделям выгоднее угадывать В работе предлагают изменить метрики так чтобы частичный зачёт получали честные ответы с признанием неопределённости rozetked me news 41365

Технологии2 дня назад

SЕalytics (Сергей Людкевич)

Исследование OpenAI Почему языковые модели галлюцинируют объясняет причину так Галлюцинации сохраняются отчасти потому что современные методы оценки задают неверные стимулы Хотя сами оценки напрямую не вызывают галлюцинации большинство из них оценивают эффективность модели таким образом что это побуждает к догадкам а не к честному признанию неопределённости

Технологии1 день назад

PRO AI | ПОЛЕЗНЫЙ СОФТ | НОВОСТИ

OpenAI объявила о прорыве в решении проблемы галлюцинаций ИИ Это достижение может значительно улучшить качество взаимодействия с искусственным интеллектом и повысить его надежность Подробности и технологии лежащие в основе этого прорыва пока остаются закрытыми но эксперты предполагают что это может повлиять на многие области включая автоматизацию контента и работу с данными PRO AI OFFICIAL

Технологии13 часов назад

Похожие новости

+1

+1

+2

+2

+6

+6

OpenAI реорганизует команду для улучшения взаимодействия ИИ с пользователями

Технологии

1 день назад

+1

+1

Сэм Альтман обсуждает теорию мёртвого интернета и влияние ИИ на соцсети

Технологии

1 день назад

Мошенники используют ИИ для обмана игроков в онлайн-играх

Происшествия

13 часов назад

Общество Знание запускает онлайн-курс по ИИ для педагогов

Общество

10 часов назад

+2

+2

Исследование: В будущем востребованы специалисты по ИИ и софт скиллы

Общество

1 день назад

+6

+6

Новая нейросеть Sonoma Sky Alpha превосходит GPT-5 в математике

Технологии

8 часов назад