30 августа, 10:58

Apple анонсировала FastVLM с поддержкой WebGPU для улучшенной обработки изображений и текста

AI Insider

Apple выпускает FastVLM и MobileCLIP2 на Hugging Face Модели стали в 85 раз быстрее и в 3 4 раза меньше чем в предыдущих версиях что позволяет использовать приложения VLM в реальном времени Он даже может создавать субтитры к видео в реальном времени локально прямо в браузере не требует установки

Технологии150 дней назад

Метаверсище и ИИще

Apple только что выпустила FastVLM и MobileCLIP2 на Hugging Face 85 кратный прирост скорости 3 4 кратное уменьшение размера для работы с изображениями и видео в реальном времени на вашем устройстве Субтитры к видео в реальном времени в браузере доступ в облако при этом не требуется Впечатляет huggingface co spaces apple fastvlm webgpu cgevent

Технологии146 дней назад

Чёрный Треугольник

Apple выпустила новую линейку открытой модели FastVLM FastVLM ИИ модель для задач OCR создания подписей к изображениям визуальных вопросов и ответов которая демонстрирует впечатляющие достижения в скорости точности и эффективности обработки данных Сравнивая с аналогичными решениями FastVLM работает в 85 раз быстрее и занимает в 3 4 раза меньше места Она универсальна подходит как для мобильных устройств так и для облачных платформ и способна эффективно обрабатывать изображения высокого разрешения Модель доступна на Github и HuggingFace в трех версиях с количеством параметров 0 5 1 5 и 7 миллиардов Благодаря поддержке WebGPU FastVLM может функционировать прямо в браузере без необходимости в дополнительной установке протестировать можно онлайн на huggingface News Soft Gear Links

Технологии146 дней назад

Python Community

Apple представила FastVLM на Hugging Face модели 0 5B 1 5B и 7B с поддержкой WebGPU VLM Vision Language Model это модель которая умеет одновременно работать с картинками и текстом понимать что изображено описывать картинку словами отвечать на вопросы по изображению и совмещать визуальные и текстовые данные Что это значит До 85 раз быстрее и в 3 4 раза компактнее аналогичных VLM У крупных моделей время до первого токена стало быстрее в 7 9 раз Меньше выходных токенов быстрее обработка картинок высокого разрешения Модель работает в реальном времени прямо в браузере через transformers js и WebGPU huggingface co spaces apple fastvlm webgpu Python Community ru

Технологии150 дней назад

Все о блокчейн/мозге/space/WEB 3.0 в России и мире

Очень крутая работа Apple они создали ИИ модели которые работают на iPhone в 85 раз быстрее аналогов при сопоставимой точности Представлены 2 новые ИИ модели FastVLM и MobileCLIP2 Эти модели могут 1 одновременно обрабатывать изображения видео и текст 2 генерировать субтитры для видео в реальном времени 3 Работают прямо на устройстве или в браузере без подключения к облачным серверам

Технологии146 дней назад

PROAI

Apple выложила локальные модели FastVLM и MobileCLIP2 Они делают субтитры к видео в реальном времени и анализируют изображения прямо на устройстве демо FastVLM работает в браузере через WebGPU Ускорение заявлено до 85 относительно похожих VLM есть варианты 0 5B 1 5B 7B Применения автосубтитры поиск по фото по описанию инспекция контента подсказки для монтажа Модели доступны бесплатно для тестирования и интеграции в рамках условий лицензий Бесплатный GPT Экспертный канал

Технологии146 дней назад

Похожие новости

+3

+3

+2

+2

+8

+8

Microsoft анонсировала новый ИИ чип Maia 200 для GPT-5

Технологии

19 часов назад

+3

+3

Alibaba анонсировала мощную модель ИИ Qwen 3 Max Thinking

Технологии

21 час назад

Click представляет AI ассистента Cleo в анимационном формате

Технологии

1 день назад

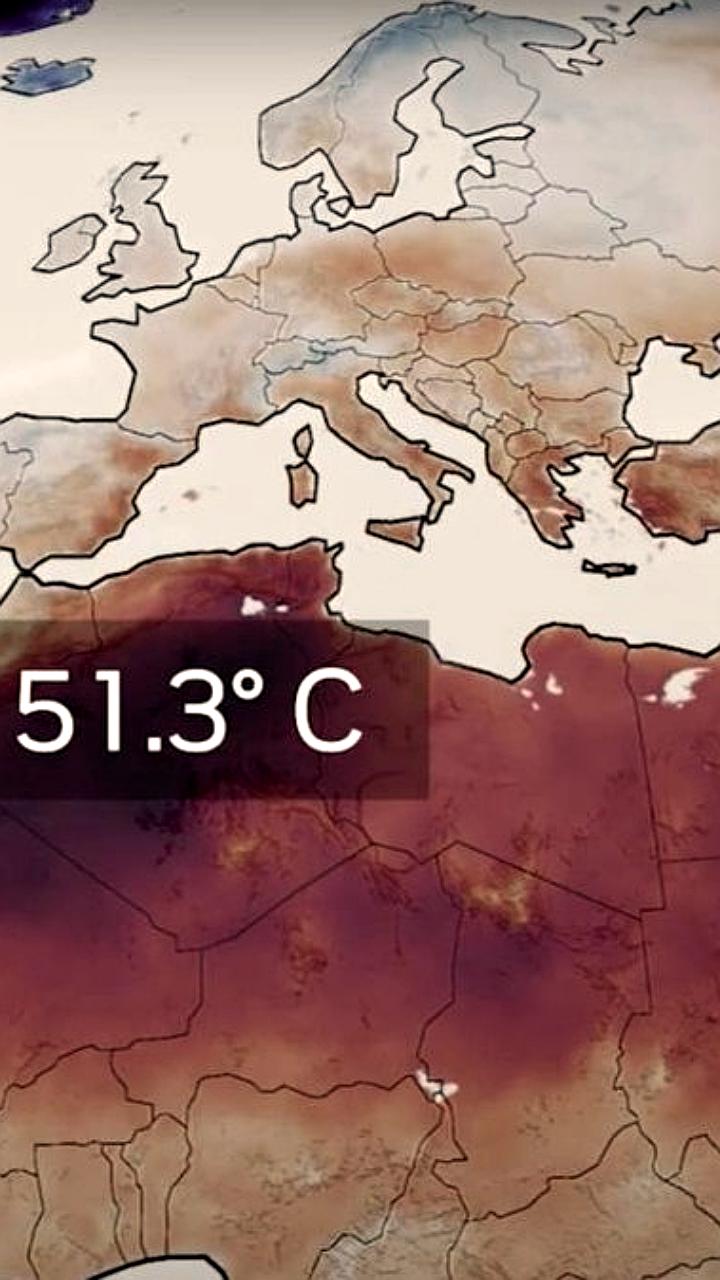

NVIDIA запускает платформу Earth 2 для улучшения метеопрогнозов с помощью ИИ

Технологии

21 час назад

+2

+2

Nvidia инвестирует 2 млрд долларов в CoreWeave для увеличения вычислительной мощности

Технологии

6 часов назад

Apple и Google анонсируют обновления Siri с использованием ИИ моделей Gemini

Технологии

1 день назад

+8

+8