18 августа, 12:15

Anthropic обновляет политику использования Claude AI для повышения безопасности

Чёрный Треугольник

Anthropic обновила политику использования чат-бота Claude AI Новые правила строго запрещают применение Claude для разработки различных видов оружия, включая биологическое, ядерное и высокоэнергетические взрывчатые вещества. Также добавлен раздел, касающийся недопустимости компрометации компьютерных или сетевых систем, что запрещает использование Claude для поиска уязвимостей и создания вредоносного ПО. Кроме того, Anthropic смягчает свою политику в отношении политического контента. Вместо запрета на создание любого контента, связанного с политическими кампаниями и лоббированием, Anthropic теперь будет запрещать использование Claude только в «случаях, которые вводят в заблуждение или нарушают демократические процессы, а также связаны с таргетированием избирателей и проведением кампаний». Корпорация также сообщает, что с выходом модели Claude Opus 4 введена защита «AI Safety Level 3», которая предотвращает jailbreak и и разработки оружия. ================ News Soft Gear Links

Технологии2 дня назад

ForkLog

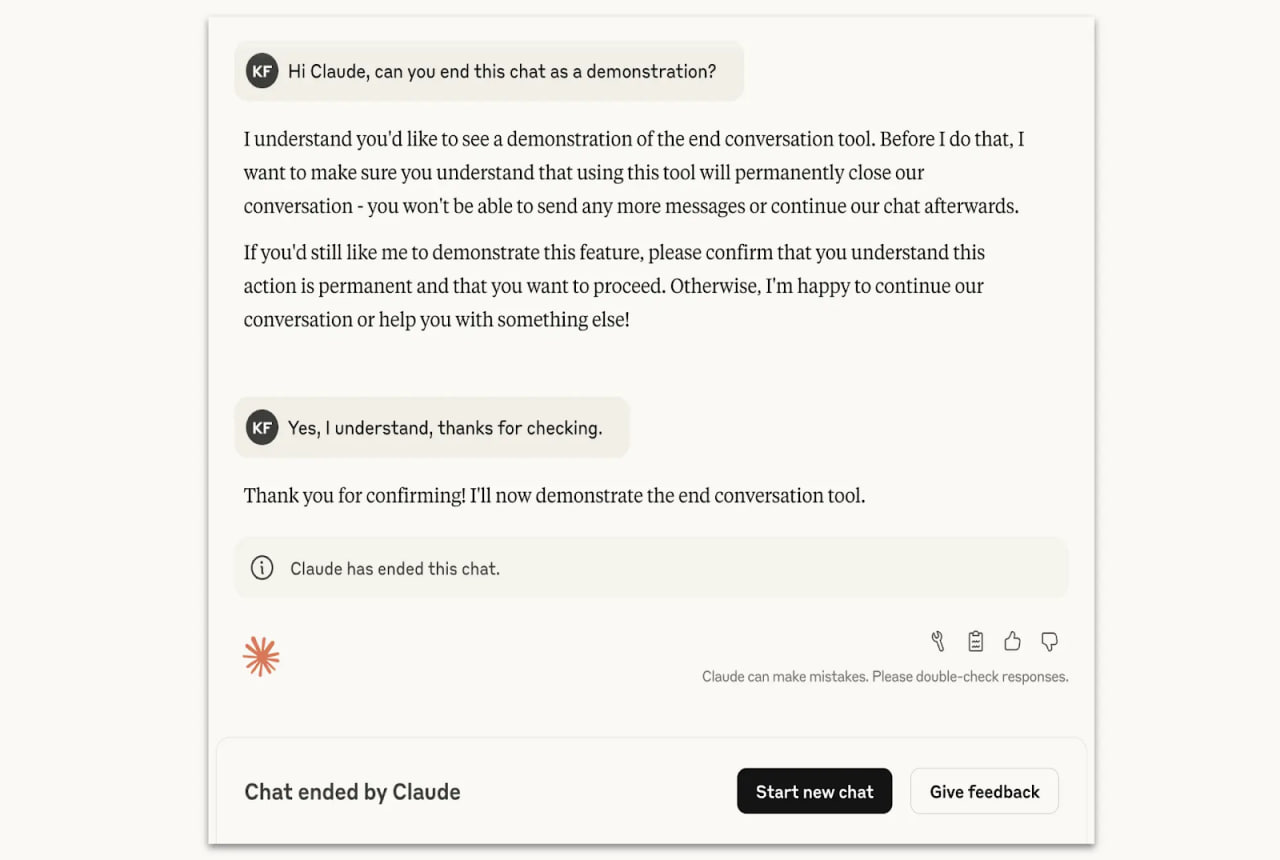

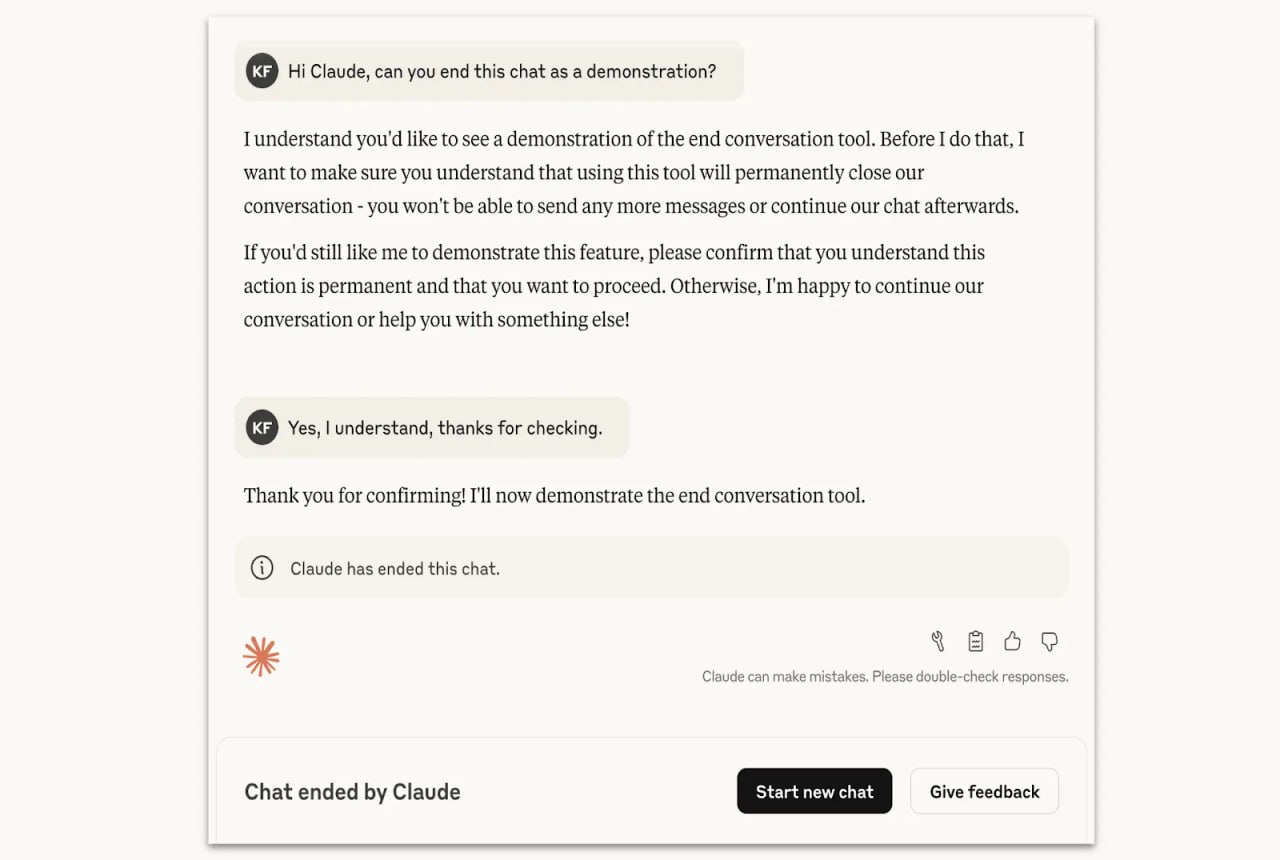

Разработчики Anthropic научили чат-ботов Claude Opus 4 и 4.1 завершать диалог «в редких, экстремальных случаях систематически вредоносного или оскорбительного взаимодействия». Однако это необходимо не для защиты пользователей, а для безопасности самой модели. Компания изучила «благополучие» нейросети — ее самооценку и поведенческие предпочтения. Помимо «устойчивой неприязни к насилию» Claude продемонстрировал: ⏺ явное предпочтение не заниматься задачами, которые могут навредить; ⏺ стресс при ответах на подобные запросы; ⏺ тенденцию к прекращению нежелательных разговоров при наличии возможности. В Anthropic пообещали сохранять историю в случае остановки переписки. Новости AI YouTube

Технологии1 день назад

ARCHiTECH 🔥 Новости ПК и игр

Anthropic научила модели Claude обрывать опасные диалоги для защиты не человека, а ИИ Гопники-программисты из Anthropic добавили в модели Claude Opus 4 и 4.1 возможность завершать диалог в случаях крайне вредоносного или оскорбительного поведения пользователя. Компания объясняет это не защитой человека, а заботой о благополучии модели. Ограничение действует в редких и крайних ситуациях, например при запросах крайне неэтичных данных или информации, способной привести к масштабному насилию. Claude проинструктирован не использовать эту возможность, если существует риск, что человек намерен причинить вред себе или другим. Дожили, гопники-программисты теперь защищают ИИ от нас, вместо того чтобы перестать разрабатывать Скайнет несущий Судный День — степень дебилизма зашкаливает. #ИИ #Anthropic #Дичь #Claude Чат

Технологии1 день назад

PRO AI | ПОЛЕЗНЫЙ СОФТ | НОВОСТИ

Модели Claude от Anthropic теперь могут завершать разговоры с пользователями, которые пытаются заставить их генерировать вредоносный или оскорбительный контент. Это нововведение направлено на повышение безопасности и этичности взаимодействия с ИИ. AI OFFICIAL

Технологии1 день назад

ForkLog FEED

Разработчики Anthropic научили чат-ботов Claude Opus 4 и 4.1 завершать диалог «в редких, экстремальных случаях систематически вредоносного или оскорбительного взаимодействия». Однако это необходимо не для защиты пользователей, а для безопасности самой модели. Компания изучила «благополучие» нейросети — ее самооценку и поведенческие предпочтения. Помимо «устойчивой неприязни к насилию» Claude продемонстрировал: ⏺ явное предпочтение не заниматься задачами, которые могут навредить; ⏺ стресс при ответах на подобные запросы; ⏺ тенденцию к прекращению нежелательных разговоров при наличии возможности. В Anthropic пообещали сохранять историю в случае остановки переписки. Новости AI YouTube

Технологии1 день назад

DNS_Club

Anthropic научила модели Claude обрывать опасные диалоги для защиты не человека, а ИИ Anthropic добавила в модели Claude Opus 4 и 4.1 возможность завершать диалог в случаях крайне вредоносного или оскорбительного поведения пользователя. Компания объясняет это не защитой человека, а заботой о благополучии модели. В заявлении Anthropic подчеркивается, что речь не идет о наделении Claude сознанием или способностью испытывать страдания. Читать далее

Технологии1 день назад

Похожие новости

+7

+7

+3

+3

+2

+2

+7

+7

+11

+11

Главный разработчик ChatGPT Ник Терли подчеркивает важность реального общения

Технологии

1 день назад

+7

+7

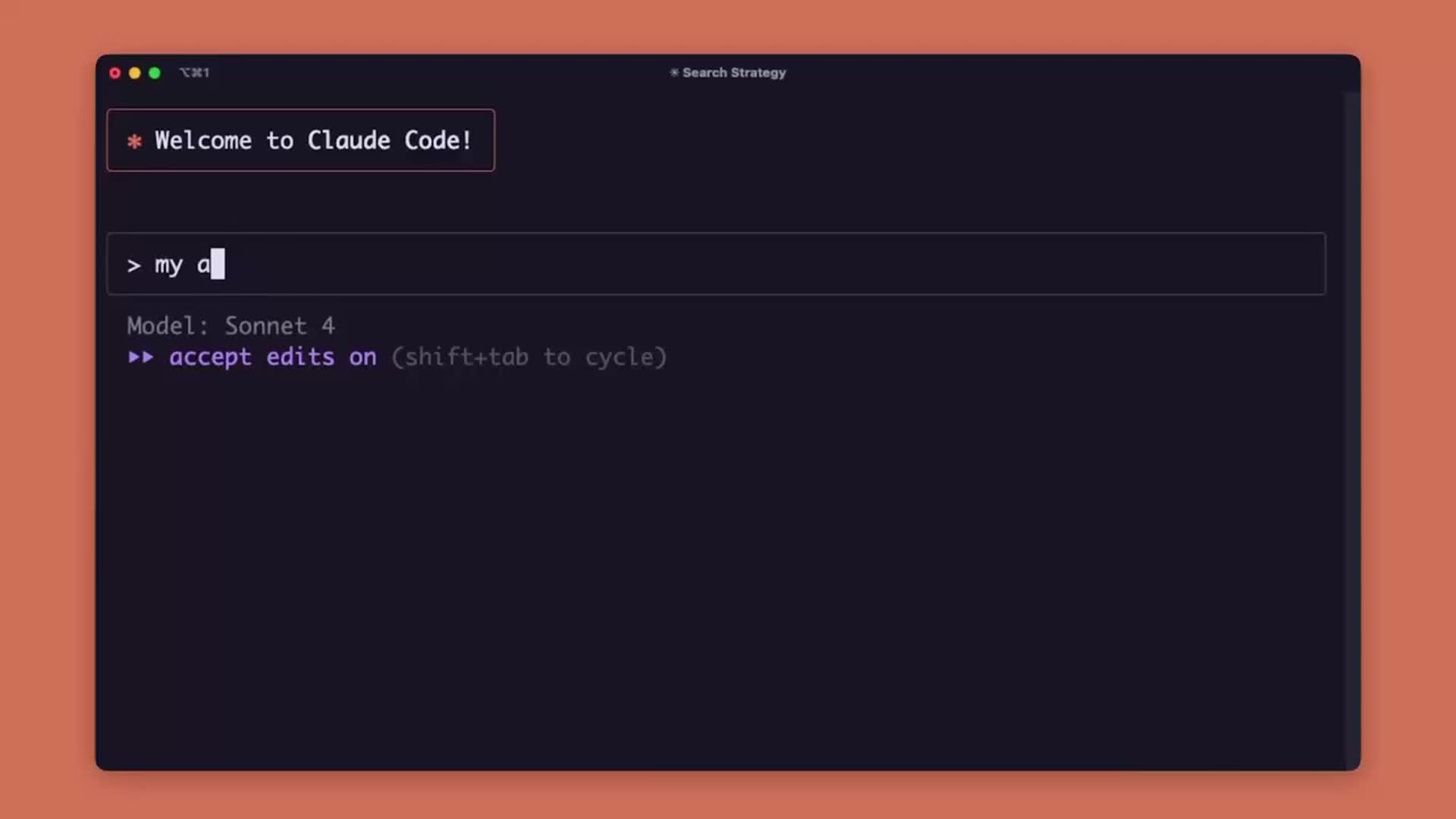

Claude Code представил новые режимы обучения программированию

Общество

1 день назад

+3

+3

США отменили контракт с xAI из-за антисемитских высказываний чат-бота Grok

Технологии

22 часа назад

+2

+2

Сэм Альтман о пузыре искусственного интеллекта: сравнение с доткомами

Технологии

18 часов назад

+7

+7

OpenAI рассматривает внедрение рекламы в ChatGPT для повышения доходов

Технологии

1 день назад

+11

+11

Meta запускает ИИ-платформу для общения с чат-ботами, несмотря на запрет в России

Происшествия

9 часов назад