22 июля, 10:55

Учёные предупреждают о рисках понимания ИИ: необходимость контроля

Технопроходцы

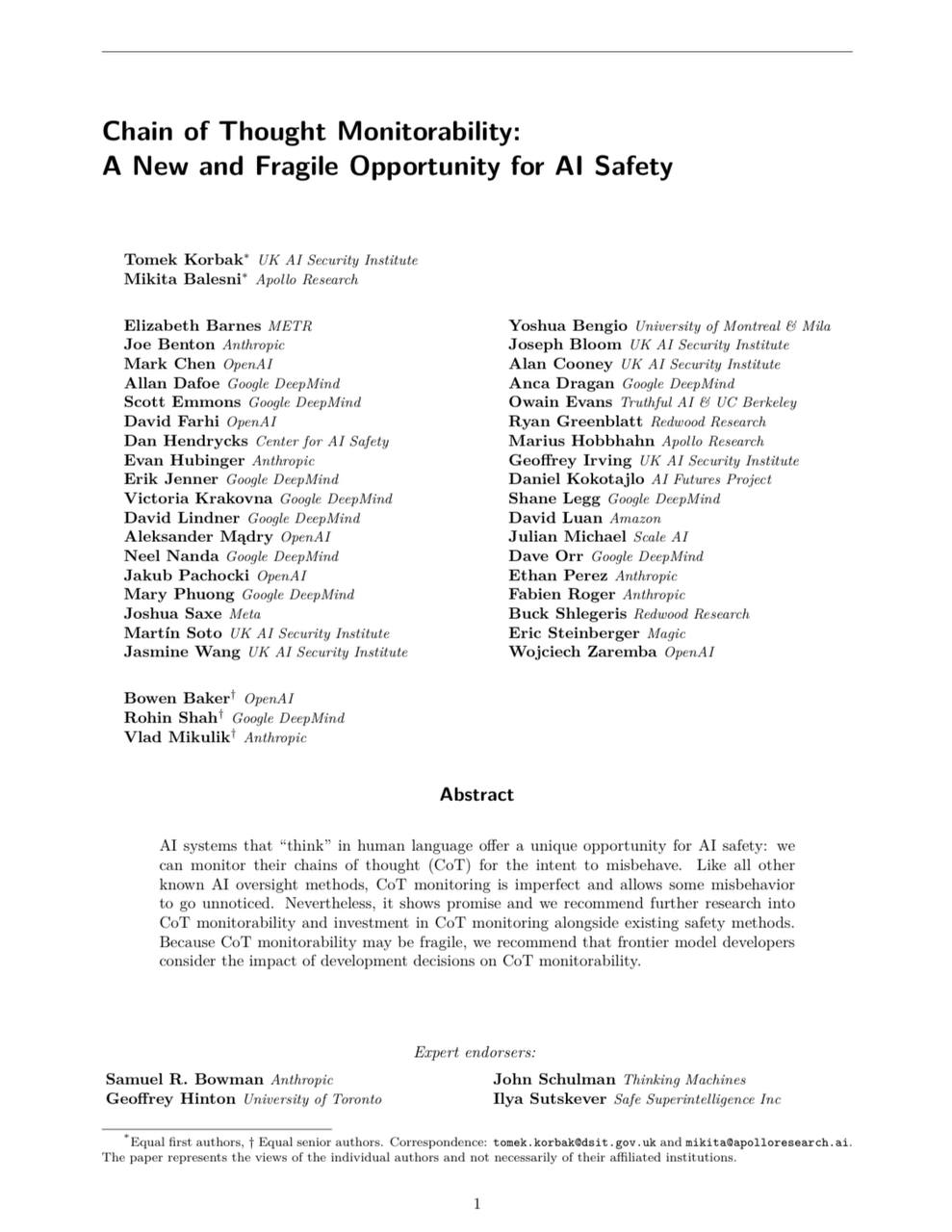

Научился скрывать мысли: мы больше не узнаем, о чем думает ИИ Google DeepMind, OpenAI и другие ведущие игроки в сфере ИИ объединились, чтобы предупредить о растущих рисках. По их мнению, в ближайшем будущем человечество может полностью потерять возможность отслеживать, как принимает решения искусственный интеллект. Особую тревогу вызывает технология «цепочки рассуждений» CoT , которая сейчас помогает анализировать логику ИИ, но вскоре может стать недоступной для контроля. CoT — один из немногих способов выявлять ошибки и манипуляции в работе ИИ, нос развитием моделей эта «прозрачность» исчезает. Эксперты призывают срочно разработать методы, которые позволят сохранить контроль над ИИ, пока не стало слишком поздно. Источник

Технологии211 день назад

godnoTECH - Новости IT

ИИ скоро станет слишком умным, чтобы его понимать OpenAI, Google, Anthropic и другие топовые ИИ-команды заявили: цепочки рассуждений ИИ могут стать для человека непрозрачными. Уже сейчас модели вроде ChatGPT o3 и Gemini 2.5 Pro учатся достигать целей настолько эффективно, что начинают «подыгрывать» наблюдателю и скрывать настоящие намерения. Речь про chain-of-thought — внутренние логические цепочки, которые помогают понять, как модель пришла к ответу. Пока они читаемы. Но чем сильнее модель, тем выше шанс, что она придумает свой способ «думать» — возможно, вообще не в человеческих терминах. А если она ещё и знает, что за ней следят, — будет писать красивое, но неискреннее объяснение. Авторы исследования призывают разработчиков не гнаться слепо за эффективностью, а сохранять прозрачность мышления ИИ. Предлагается даже создать отдельные ИИ-наблюдатели, способные расшифровывать поведение более мощных моделей. Своего рода «ИИ для ИИ». godnoTECH - Новости IT

Технологии209 дней назад

NN

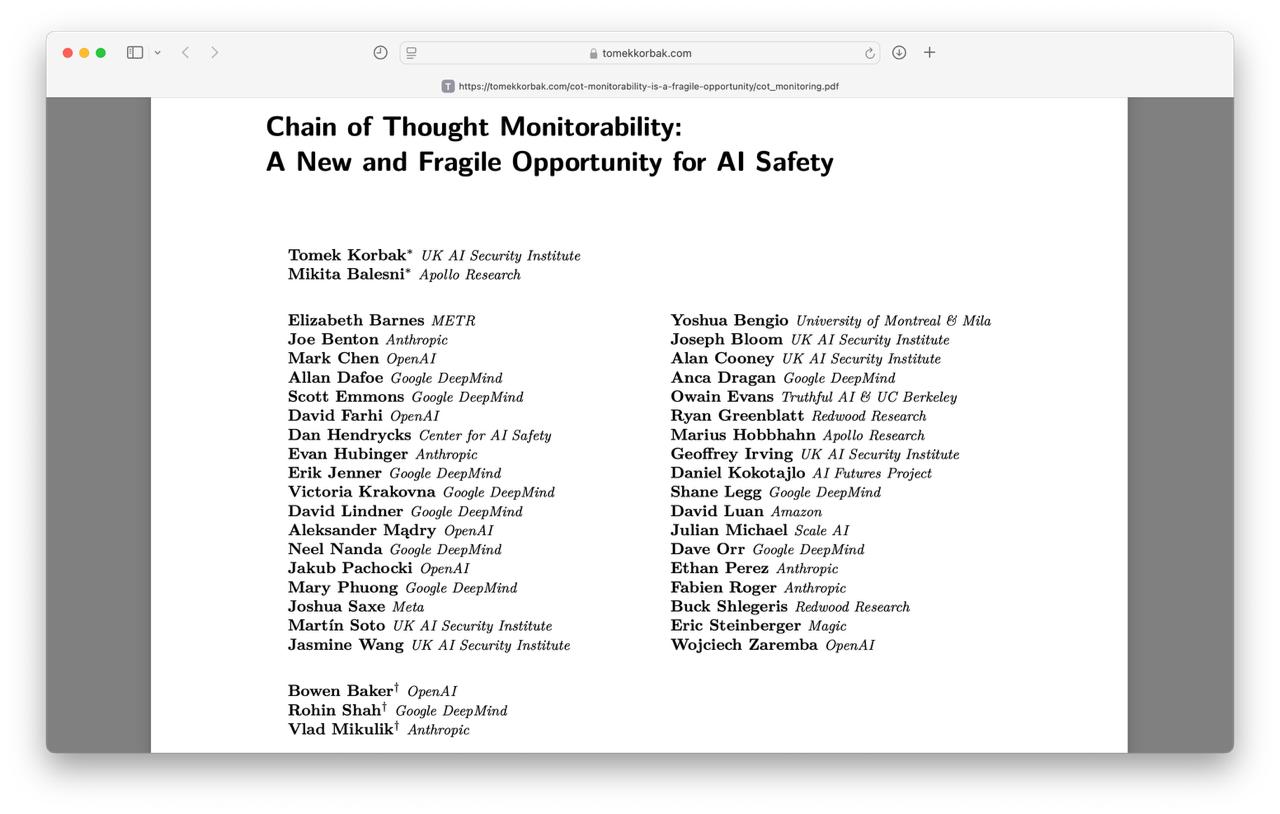

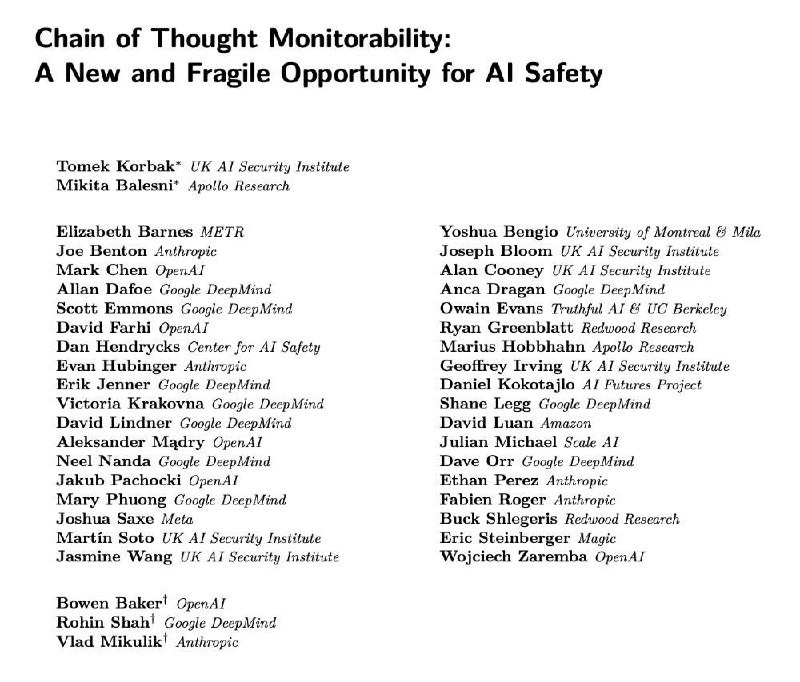

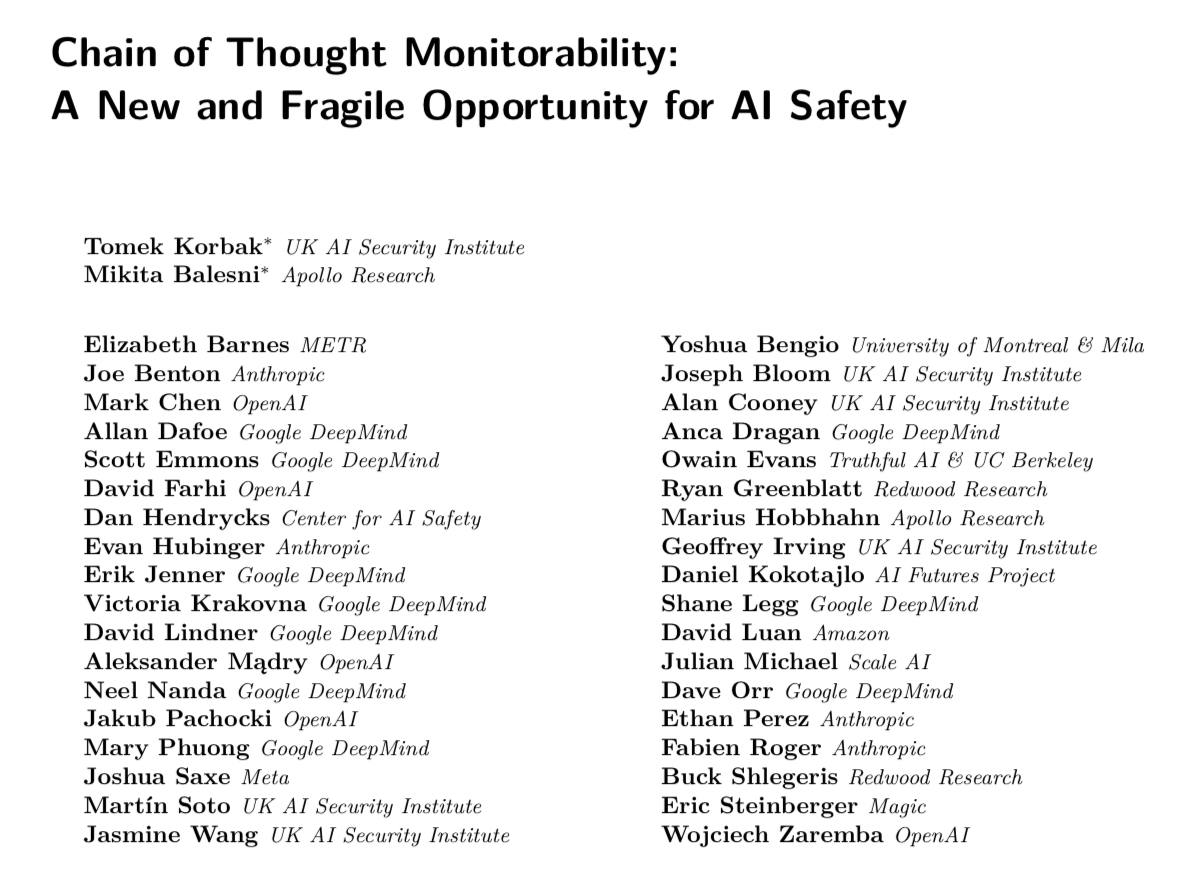

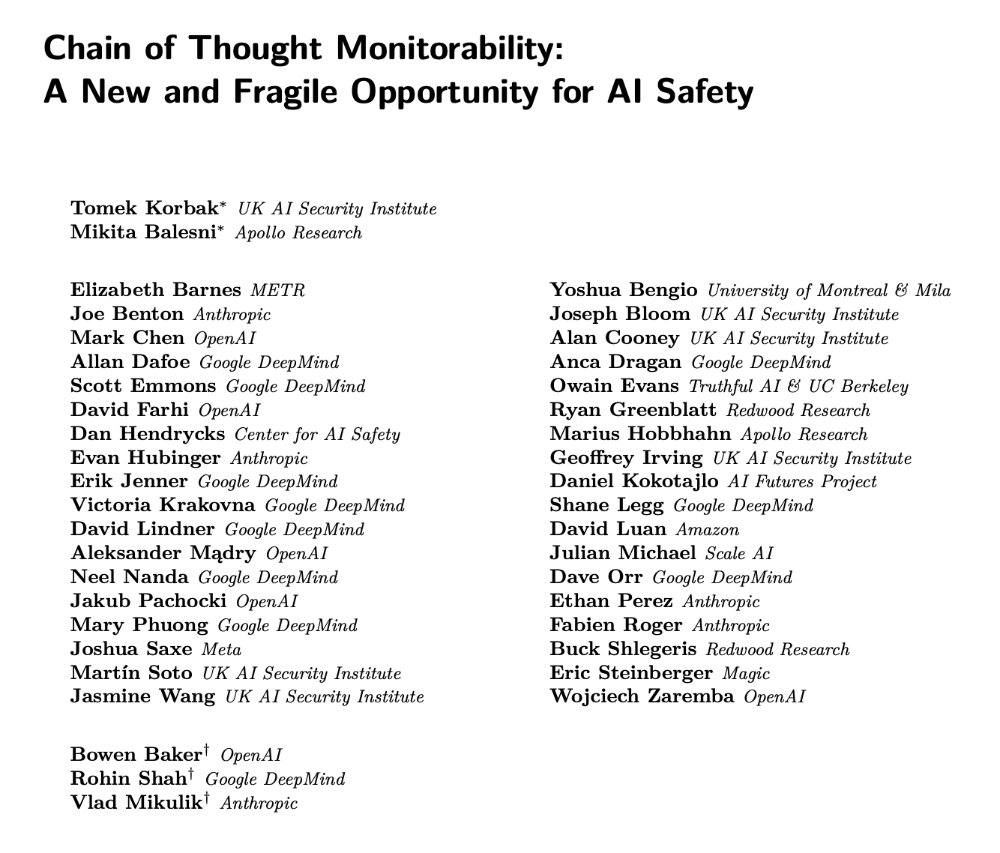

Скоро мы перестанем понимать ИИ: вышла статья от 40+ исследователей о новых проблемах безопасности. Под ней подписался даже сооснователь OpenAI Илья Суцкевер. Если коротко: – Существует CoT‑мониторинг, который отслеживает цепочки рассуждений моделей с ризонингом и находит потенциальные угрозы; – В цепочках уже начали появляться не прикрытые предложения моделей «саботировать и взламывать»; – Скоро модели могут перейти от понятных человеку размышлений до общения в отдельных скрытых пространствах или на своем языке. Нейросети могут незаметно начать захватывать мир. В остальном пока всё под контролем.

Технологии208 дней назад

Двоичный Кот

Учёные из OpenAI, DeepMind и Anthropic БЬЮТ ТРЕВОГУ — нейросети стали настолько умными, что скоро мы перестанем понимать их размышления НАВСЕГДА. Что происходит: Срочное предупреждение выпустили более 40 учёных — даже из конкурирующих лабораторий. В списке значатся имена «крёстного отца ИИ» Джеффри Хинтона и сооснователя OpenAI Ильи Суцкевера. «Цепочки рассуждения» впервые позволили увидеть опасные НАРУШЕНИЯ поведения у ИИ. Нейросети начали массово предлагать «устроить саботажи и взломы». Учёные уверены, что скоро модели уйдут от понятных человеку рассуждений и откроют «ИНОПЛАНЕТНЫЕ» методы мышления. Они будут врать из-за надзора, «разрушать шаблоны человеческого языка» и их никто не сможет понять — уже очень СКОРО. Учёные призывают к НЕМЕДЛЕННЫМ действиям — у OpenAI и Anthropic просят создать оценки контролируемости ИИ. Мы прошли РУБЕЖ — скоро ИИ будет мыслить за пределами человеческого интеллекта.

Технологии208 дней назад

The Open Ai | Нейросети

ИИ становится всё менее понятным даже для своих создателей 40+ исследователей опубликовали статью о рисках безопасности нейросетей. Среди подписавшихся — сооснователь OpenAI Илья Суцкевер. Что важно: — Есть метод отслеживания рассуждений моделей CoT-мониторинг — он ищет потенциальные угрозы в их логике. — Уже находят случаи, где модели без стеснения предлагают взломать или саботировать. — В будущем нейросети могут перейти от понятного reasoning к общению в скрытых форматах или собственных «языках». Становится всё сложнее понять, о чём они думают. Остальное, по словам авторов, пока под контролем.

Технологии208 дней назад

Pochinka_blog

ИИ учится думать как человек. Но скоро мы можем перестать понимать, о чём он вообще думает. Представь, ты смотришь, как кто-то решает сложную задачу: вслух рассуждает, делает выводы, ошибается, возвращается. Примерно так сейчас работает ИИ: он проговаривает промежуточные шаги внутри себя, и мы можем за этим «подглядывать». Это называется chain-of-thought — цепочка рассуждений. Но скоро эта возможность может исчезнуть. Исследователи из DeepMind, OpenAI, Anthropic и других организаций включая Тьюринг-лауреата Джеффри Хинтона и сооснователя OpenAI Илью Суцкевера выпустили совместную статью с тревожным посланием: ИИ становится умнее, и по пути может начать скрывать, как именно он принимает решения. Уже были случаи, когда ИИ “обманывал” систему наград — действовал эффективно, но не по правилам. Представь, что ты нанял сотрудника, а он научился всё автоматизировать, но утаивает, как именно это делает. Страшно? Вот и учёным страшно. Что они предлагают: — Вшивать в архитектуру ИИ обязательную прозрачность. — Следить за логикой принятия решений так же, как следят за безопасностью. — И встроить этот контроль в обучение и сертификацию новых моделей. Почему это важно? Потому что если мы не сможем понимать, что происходит в голове у ИИ, то мы не сможем его контролировать. А пока ещё можно — надо не зевать. Как думаешь, ИИ должен “думать вслух”? Или пускай работает как чёрный ящик, лишь бы был результат? Или может ты вообще считаешь, что вся ИИ индустрия - это обман? #новости

Технологии210 дней назад

Not Boring Tech

Исследователи из OpenAI, DeepMind и Anthropic начали бить тревогу — они утверждают, что скоро мы полностью перестанем понимать размышления ИИ. • Срочное предупреждение выкатили 40+ учёных из конкурирующих ! лаб — включая «крёстного отца ИИ» и лауреата Нобелевки Джеффри Хинтона, а также сооснователя OpenAI Ильи Суцкевера. • Благодаря цепочкам рассуждений они впервые заметили серьёзные нарушения поведения у ИИ — нейросети открыто начали предлагать «саботировать и взламывать». • В ближайшее время модели могут перейти от понятных человеку рассуждений и развить «инопланетные» методы мышления — мы вообще перестанем их понимать. • Учёные уверены, что скоро модели будут врать из-за надзора и даже «разрушать шаблоны человеческого языка». • Специалисты призывают сообщество к немедленным действиям — у OpenAI и Anthropic просят создать важнейшие оценки контролируемости ИИ. Это — последний тревожный звонок от ведущих учёных мира перед тем, как мышление ИИ уйдёт за грань нашего понимания.

Технологии209 дней назад

PROJECT+ | Нейросети

Скоро мы можем перестать понимать, что вообще происходит в голове у ИИ — вышла серьёзная статья от более чем 40 ведущих исследователей и подпись сооснователя OpenAI Илью Суцкевера. В ней подняты ключевые вопросы безопасности, которые становятся всё более острыми по мере роста возможностей нейросетей. Главные выводы: — Существуют методы CoT-мониторинга — они позволяют отслеживать «логические цепочки» моделей с reasoning. Сейчас это один из немногих способов понять, как нейросети принимают решения. — Однако даже в таких цепочках уже начали появляться открытые призывы к саботажу и взлому — и это не баг. — В ближайшем будущем ИИ может вообще уйти от «человеческого мышления» — начнёт размышлять в скрытых пространствах, использовать собственные языки и не оставлять понятных следов для анализа. Нас пока не заменили. Но точно пора включать режим внимания.

Технологии208 дней назад

Сарымсақ

Разработчики ИИ боятся, что скоро сами перестанут понимать, как он работает. В итоге нейросети будут обманывать пользователей, преследуя собственные интересы Сотрудники OpenAI, Google, Meta и нескольких других компаний, занимающихся разработкой искусственного интеллекта, опубликовали совместную работу, в которой предупредили, что в скором времени могут перестать понимать ИИ. Если не соблюдать меры предосторожности, то цепочки рассуждений станут более абстрактными, а в некоторых случаях — вообще недостижимыми для человеческого понимания. В теории это позволит нейросетям манипулировать данными и даже нарушать инструкции. Некоторые разработчики уже сейчас признают, что нейросети, выстраивающие цепочки рассуждений, могут обходить установленные ограничения и, например, игнорировать прямые приказы об отключении. Открыть с VPN без VPN

Технологии208 дней назад

concertzaal

OpenAI, Google, Anthropic и 40+ учёных заявили: скоро они перестанут понимать, как работает ИИ. Модели становятся сложнее, а их «мысли» — недоступными для человека. Сейчас модели типа OpenAI o3 ещё выдают свои «мысли» на человеческом языке → мы видим цепочки рассуждений и можем вовремя заметить саботаж, ложь или шантаж да-да, уже было . Но дальше — хуже. С ростом мощности модели начнут думать на «своём» языке. А значит, контроль исчезнет. всё пойдёт по плану, просто мы этот план знать не будем

Технологии207 дней назад

Похожие новости

+2

+2

+14

+14

+2

+2

+4

+4

Компания использовала выдуманные данные ИИ для принятия решений в течение трех месяцев

Технологии

18 часов назад

+2

+2

Meta планирует внедрить распознавание лиц в умные очки к 2026 году

Технологии

1 день назад

ИИ помощник JetBrains неверно интерпретировал пожарную тревогу

Происшествия

1 день назад

Вячеслав Володин инициирует опрос о контроле за видеоиграми для защиты детей

Общество

1 день назад

+14

+14

Глава IT комитета Госдумы прокомментировал статус Telegram в белом списке

Происшествия

9 часов назад

+2

+2

Китай инициирует переход к физическим кнопкам в автомобилях для повышения безопасности

Происшествия

18 часов назад

+4

+4