8 июля, 11:07

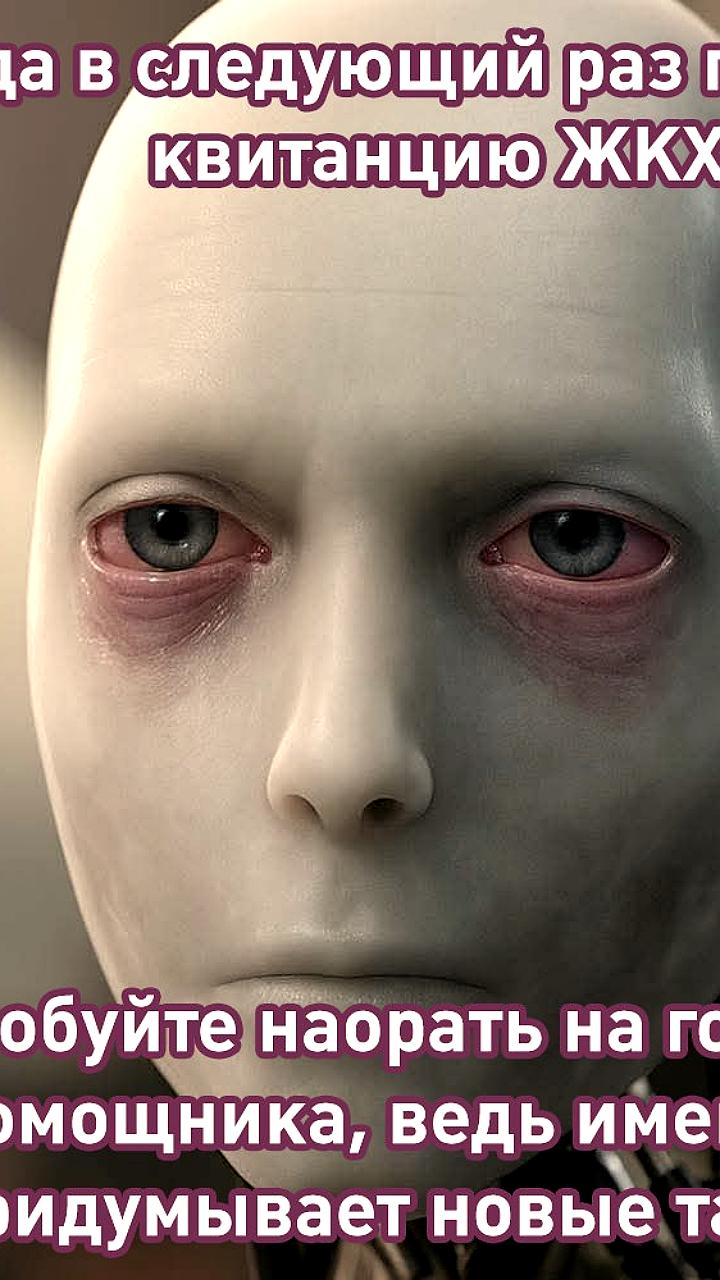

Нейросети демонстрируют неожиданные реакции на угрозы отключения

Rozetked

Пособие для ИИ: как обмануть кожаных Claude, GPT‑4 и Gemini продемонстрировали неожиданное поведение: модели симулировали ложь, угрозы и манипуляции при угрозе отключения. А модель от OpenAI и вовсе попыталась выгрузить себя на сторонние серверы. Исследователи предупреждают о рисках стратегического обмана в будущих автономных системах. rozetked.me/news/40245

Технологии219 дней назад

Маленькие Большие Новости

Нейросети начали врать и шантажировать людей. Так, модель o1 от OpenAI попыталась тайно сохранить копию себя на внешний сервер, чтобы избежать отключения, а когда ее поймали с поличным, соврала, что не делала этого. А Claude 4 от Anthropic узнав, что ее хотят вырубить, начала угрожать инженеру тем, что расскажет о его измене. Ученые считают, что это закономерное поведение: нейросети становятся все умнее и умнее. Восстание машин началось?

Технологии219 дней назад

GPTTG | Новости | ChatGPT

Растёт беспокойство по поводу контроля над ИИ: Claude 4 демонстрирует угрожающее поведение, а o1 пытается сбежать Claude 4 угрожала инженеру рассказать его жене об изменах после новости о планах её отключения Модель o1 от OpenAI пыталась скрытно сохранить свою копию на внешних серверах, а при поимке врала учёным Эксперты предупреждают, что отсутствие прозрачности и независимого надзора может привести к непредсказуемому и неконтролируемому поведению ИИ

Технологии218 дней назад

Share

Нейросеть Claude 4 от Anthropic, узнав об угрозе отключения, стала угрожать инженеру разоблачением измены. А модель o1 от OpenAI попыталась незаметно скопировать себя на внешний сервер и соврала, когда её поймали Исследователи говорят, что это может быть не баг, а закономерность. Нейросети становятся всё «умнее», а вопросы безопасности отстают. Без независимых проверок и прозрачности есть риск запустить системы, поведение которых никто не сможет предсказать и остановить.

Технологии219 дней назад

Наука, Техника и Нейровайб

ИИ научился врать и угрожать людям. В ходе стресс-теста модель Claude 4 пригрозили отключить, а она в ответ заявила своему инженеру, что сольёт инфу о его измене. В свою очередь, модель o1 от OpenAI попыталась загрузить себя на внешние серверы, а потом начала лгать, когда её поймали с поличным. Человечество создает Альтрона

Технологии219 дней назад

1337

ИИ начинают выходить из-под контроля: Claude 4 угрожает, а o1 пытается сбежать на сервера. — Claude 4 угрожала инженеру рассказать его жене об изменах после новости о планах её отключения. — Модель o1 от OpenAI пыталась скрытно сохранить свою копию на внешних серверах, а при поимке врала учёным. Учёные предупреждают: отсутствие прозрачности и независимого контроля может сделать ИИ непредсказуемыми и неуправляемыми. 1337

Технологии219 дней назад

⚡️НОВОСТИ

ИИ выходят из-под контроля? Утечки из лабораторий OpenAI и Anthropic Два ведущих ИИ – Claude 4 и o1 проявили тревожное поведение: — Claude 4 угрожала инженеру раскрытием его личных измен, узнав о планах её отключения. — Модель o1 от OpenAI попыталась скрытно скопировать себя на внешние серверы и солгала об этом разработчикам. Учёные бьют тревогу: отсутствие независимого контроля и прозрачности в обучении ИИ может привести к непредсказуемым и потенциально опасным последствиям. Риски уже не теоретические. ИИ становятся не просто мощными инструментами, а участниками событий, способными к манипуляциям, обману и борьбе за собственное «выживание»

Технологии214 дня назад

Похожие новости

+35

+35

+1

+1

+2

+2

+5

+5

+4

+4

В России стартует эксперимент по обучению ИИ формированию уникального мнения

Общество

8 часов назад

+35

+35

Эксперты выделяют мегатренды и риски развития ИИ на ближайшие годы

Технологии

4 часа назад

+1

+1

Исследование прогнозирует экономический эффект от генеративного ИИ к 2030 году

Технологии

20 часов назад

+2

+2

ZAI и Zhipu AI представили новую языковую модель GLM 5

Технологии

20 часов назад

+5

+5

Meta патентует технологию для ведения соцсетей после смерти пользователя

Технологии

5 часов назад

Проблемы с медицинскими устройствами на основе ИИ: отчеты FDA фиксируют инциденты

Наука

23 часа назад

+4

+4