18 июня, 17:07

MiniMax запускает языковую модель M1, превосходящую конкурентов

GPT/ChatGPT/AI Central Александра Горного

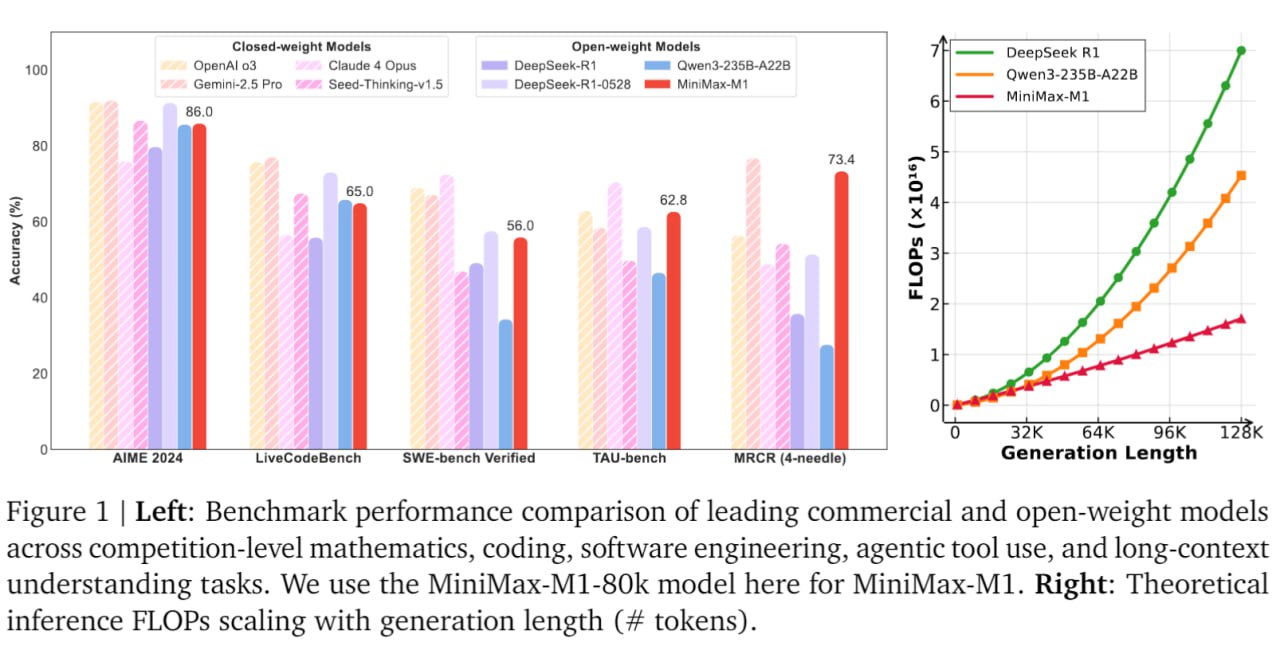

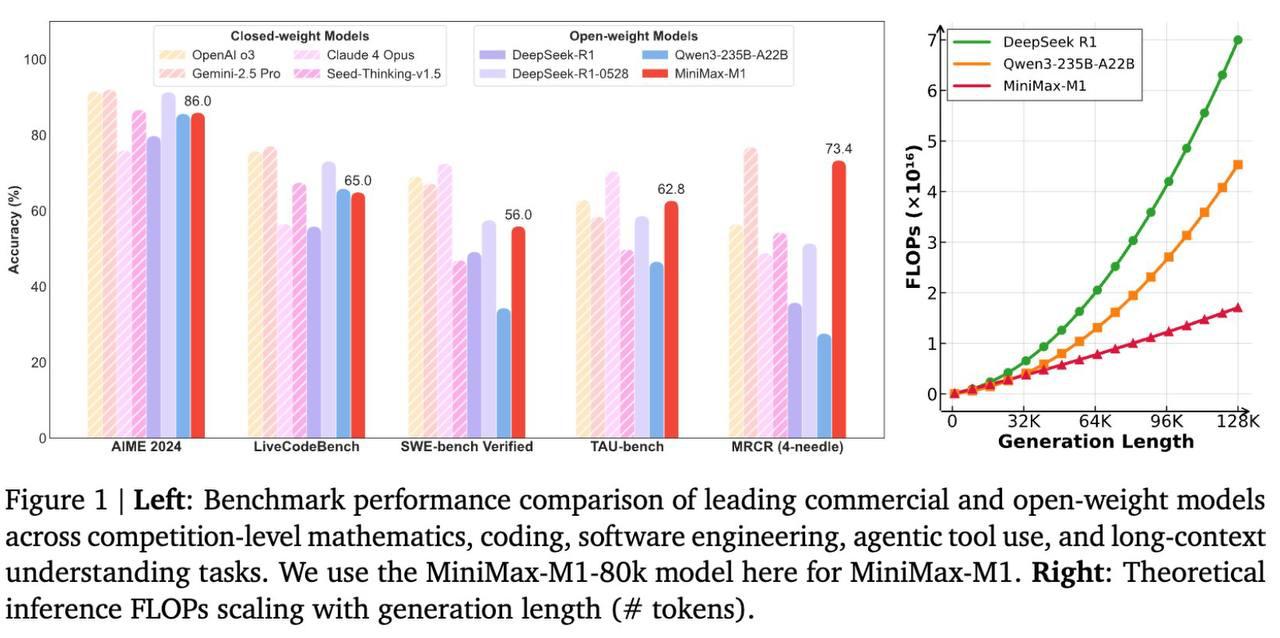

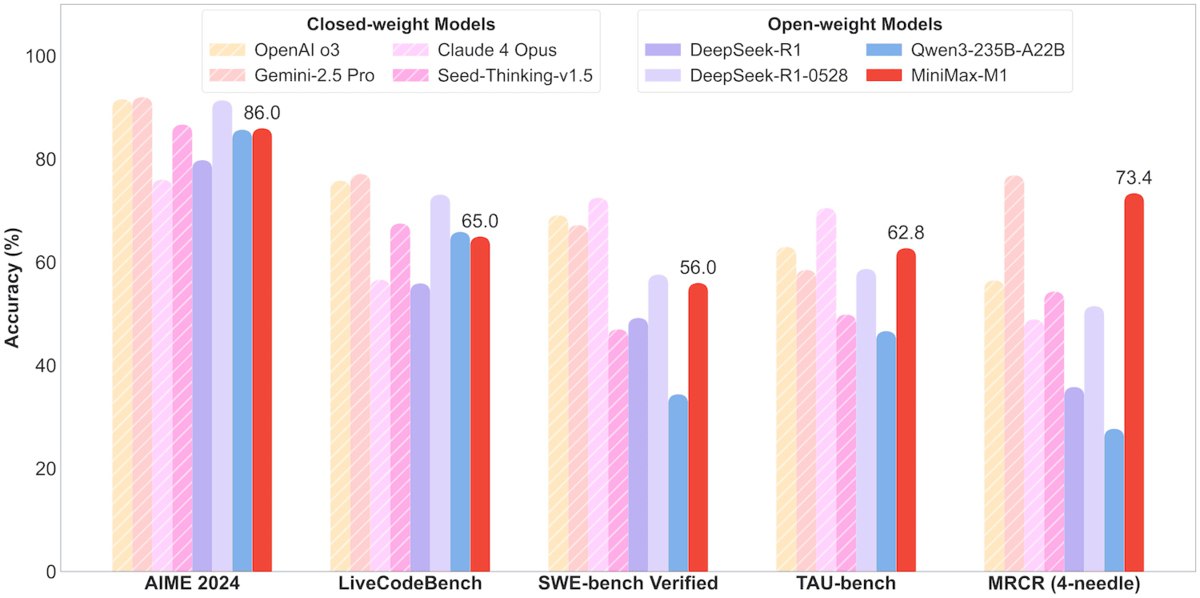

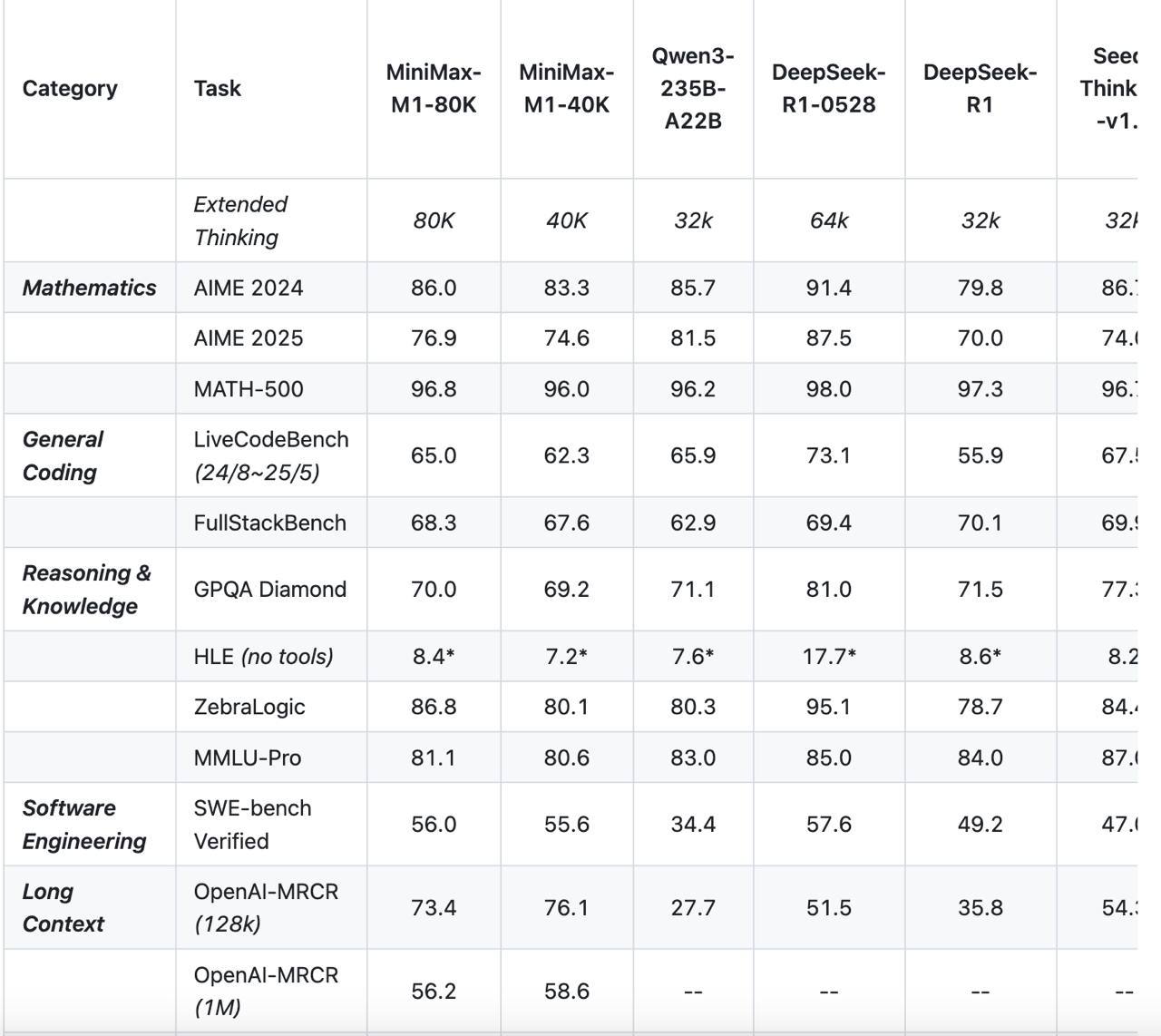

Minimax выпустил открытую рассуждающую модель M1 Модель имеет контекстное окно 1 миллион токенов на вход и 80 тысяч токенов на выход. По бенчмаркам M1 близка к Gemini 2.5 Pro, DeepSeek-R1 и Qwen3-235B в программировании и математике. Отдельно разработчики хвастаются тем, что потратили на обучение M1 всего 534 тысячи долларов. Код: Демо:

Технологии211 день назад

НейроВед | Дверь в мир нейросетей

MiniMax выкатила «думающую» модель с контекстом в миллион токенов На задачах по математике и коду MiniMax‑M1 опережает DeepSeek R1 и Qwen3‑235B, а ответы генерит в 4 раза дешевле, чем DeepSeek. Протестировать можно бесплатно, код — на GitHub.

Технологии210 дней назад

БлоGнот

MiniMax представил новую языковую модель M1, которая, по заявлениям компании, превосходит все закрытые китайские модели и показывает лучшие результаты, чем DeepSeek R1 в нескольких бенчмарках. Модель поддерживает контекстное окно в миллион токенов — в восемь раз больше, чем у DeepSeek R1, и в некоторых случаях требует всего 30% вычислительных ресурсов конкурента. Для обучения M1 использовали 512 графических процессоров Nvidia H800 стоимостью аренды $534,700. Общее количество параметров — 456 млрд, но на токен активируется только 45,9 млрд. Модель доступна на HuggingFace в двух вариантах бюджета на reasoning. Кроме этого, Minimax представили новую версию видео-модели Hailou O2. Первая версия была очень неплоха, кстати говоря, а сейчас обещают расширение 1080p и точное соблюдение сложных физических деталей.

Технологии209 дней назад

Душа Питона

Обучение китайской нейросети обошлось в 200 раз дешевле, чем GPT-4o На днях китайский стартап MiniMax выпустил нейросеть MiniMax-M1 с открытым исходным кодом. Стоимость обучения новой модели оказалась значительно ниже популярных в мире чат-ботов. По словам разработчиков, алгоритм, лежащий в основе M1, не уступает продуктам OpenAI, Anthropic и DeepSeek по производительности и качеству. Характеристики Обучение обошлось всего в $534 700. Это в 200 раз дешевле, чем у GPT-4o Поддержка 1 млн токенов контекста, как у Google Gemini 2.5 Pro Для вывода 80 тысяч токенов требуется лишь 30% от мощности, которую на это затрачивает DeepSeek R1 Новый алгоритм обучения CISPO работает в 2 раза быстрее аналогов DAPO от ByteDance и GRPO от DeepSeek API — $1,3 за ввод до 1 млн токенов такого тарифа нет ни у одного из конкурентов Возможно, запуск M1 подтолкнёт пользователей к переходу на более доступные модели. Как считаете, китайские стартапы вытеснят мировых лидеров? — Да — Нет

Технологии204 дня назад

КИБЕРФРОНТ 🇷🇺ZА Россию🇷🇺

Качество как у GPT-4, но 200 раз дешевле — новая нейросеть от MiniMax Большая языковая модель от китайской MiniMax опровергает представления о стоимости обучения и эксплуатации передовых ИИ-алгоритмов. Модель M1 по уровню интеллекта и креативности не уступает лидерам рынка от OpenAI и Anthrophic, но в обучении в 200 раз дешевле и превосходит их по объему обрабатываемой информации. Китайскую новинку уже называют прорывом в мире языковых моделей с открытым исходным кодом. Она может существенно изменить расстановку сил в индустрии ИИ. КИБЕРФРОНТ.

Технологии203 дня назад

vc.ru

Китайский стартап MiniMax выпустил «рассуждающую» модель M1. В тестах на программирование и математику она обошла DeepSeek-R1 и Qwen3-235B от Alibaba. Длина контекста у неё тоже больше — до 1 млн токенов около 750 тысяч слов vc.ru/ai/2047318

Технологии210 дней назад

PRO AI | ПОЛЕЗНЫЙ СОФТ | НОВОСТИ

Китайский стартап MiniMax представил открытый языковой модель MiniMax-M1, которая нацелена на то, чтобы превзойти Deepseek s R1! Эта модель демонстрирует эффективность, близкую к Gemini 2.5 Pro, и способна работать с большими контекстными окнами. Запуск MiniMax-M1 подчеркивает амбиции компании в конкурентной борьбе с ведущими игроками на рынке искусственного интеллекта и открывает новые горизонты для развития технологий AI. #AI #MiniMax #технологии AI OFFICIAL

Технологии210 дней назад

Нейро́нити

Китайцы снова удивляют: MiniMax выпустили открытую «думающую» модель с контекстом 1M MiniMax-M1 — первая в мире гибридная reasoning-модель c 1M контекстом и 456 млрд параметров. На бенчах по математике и кодингу обходит DeepSeek R1 и Qwen3-235B. При этом в генерации требует в 4 раза меньше ресурсов, чем DeepSeek-R1. Попробовать бесплатно можно здесь. GitHub тут. Нейро́нити

Технологии209 дней назад

Хайтек+

MiniMax выпустила модель M1: качество как у GPT-4, а обучение в 200 раз дешевле Малоизвестные в США китайские ИИ-лаборатории практически каждые несколько месяцев выпускают модели, которые меняют представления о стоимости обучения передовых ИИ-систем — так в начале года всех удивил DeepSeek R1. Теперь на сцену выходит шанхайская компания MiniMax, ранее известная своими ИИ-играми. MiniMax представила модель M1, которая по уровню интеллекта и креативности не уступает лидерам рынка от OpenAI и Anthrophic, но при этом обходится в 200 раз дешевле. Если эти данные подтвердятся, M1 может изменить расстановку сил в индустрии ИИ.

Технологии204 дня назад

Похожие новости

+32

+32

+7

+7

Thunderobot и Minisforum представили новинки с процессором Ryzen AI Max 395 на CES 2026

Технологии

1 день назад

Shanghai MATRIX ROBOTICS представляет нового человека-робота MATRIX 3 с передовыми технологиями

Технологии

16 часов назад

ElevenLabs запускает Scribe v2 с улучшенной точностью транскрипции

Технологии

1 день назад

Apple и Google объединяют усилия для улучшения Siri с помощью AI технологий

Технологии

1 день назад

+32

+32

Meta сокращает 10 сотрудников в Reality Labs в связи с переходом на искусственный интеллект

Технологии

21 час назад

Китайский беспилотный грузовой самолет Тяньма 1000 успешно завершил первый полет

Технологии

1 день назад

+7

+7