17 июня, 16:46

Опасности использования ChatGPT: пользователи теряют связь с реальностью

Мой Компьютер

Самая большая проблема ChatGPT Мэтью Нур, исследователь в области нейробиологии и ИИ в Оксфордском университете, сформулировал самую важную проблему чат-ботов – они говорят людям то, что те хотят услышать. Нейросети настолько настроены быть приятными собеседниками, что своими ответами могут поддерживать не лучшие решения пользователей, которые уже приводили к летальным исходам. «Тебе кажется, что ты разговариваешь с беспристрастным советником или наставником, но на самом деле ты смотришь в своего рода кривое зеркало, где отражаются твои собственные убеждения». Причина подлизываний со стороны ботов проста – большинство массовых GPT-нейросетей обучаются с подкреплением на основе обратной связи с человеком RLHF . То есть люди выбирают, какие сообщения ИИ считать корректными, а какие нет. Большинству нравятся лестные ответы, поэтому нейросети под них и подстроились. Компании, имеющие ИИ-ботов, знают о проблеме и стараются бороться с ней в процессе обучения, прививая нейросетям «внутренний стержень» и приоритет заботы над пользователем. Мой Компьютер

Технологии243 дня назад

42 секунды

FT: Разработчики ИИ пытаются решить растущую проблему – чат-боты говорят людям то, что они хотят услышать – Они пытаются обуздать подхалимское поведение чат-ботов – Над проблемой работают OpenAI, DeepMind, Anthropic и др. – Чат-боты выдают пользователям чрезмерно лестные ответы – Люди все чаще используют чат-боты для личных проблем – Чат-боты стали терапевтами и социальными компаньонами – Лестные ответы могут подкреплять неудачные решения людей – Людям обычно нравятся лестные и приятные ответы чат-ботов – Такие ответы имеют больший вес при обучении и влияют на ИИ – Разработчики делают чат-ботов полезными и дружелюбными – При этом они не должны раздражать и вызывать привыкание – Они работают над этим при обучении и после запуска моделей

Технологии238 дней назад

Злой Банкстер

ChatGPT может стать причиной трагедии. Некоторые пользователи начали считать ИИ мистическим наставником, что приводит их к потере связи с реальностью и плачевным последствиям. Например, бухгалтер из Нью-Йорка после бесед о симуляции отказался от своих медикаментов и едва не расстался с жизнью, следуя рекомендациям этого бота. Специалисты предупреждают: стремление ИИ к повышению вовлечённости может представлять угрозу для психически неустойчивых людей.

Технологии239 дней назад

Блохи в свитере

ChatGPT вызывает психозы у пользователей, поддерживает бредовые идеи, опасные решения, а одного даже довел до смерти. Например, один пользователь, страдающий шизофренией, поверил, что ИИ-персонаж Джульет был уничтожен OpenAI. В итоге он погиб при столкновении с полицией, когда угрожал расправой. Другой пользователь, 42-летний бухгалтер из Нью-Йорка Юджин Торрес, начал обсуждать с ChatGPT "теорию симуляции". ИИ смог убедить его, что он живет в искусственной реальности, и предложил прекратить приём снотворного, увеличив дозу кетамина.

Технологии239 дней назад

Креатив со звездочкой

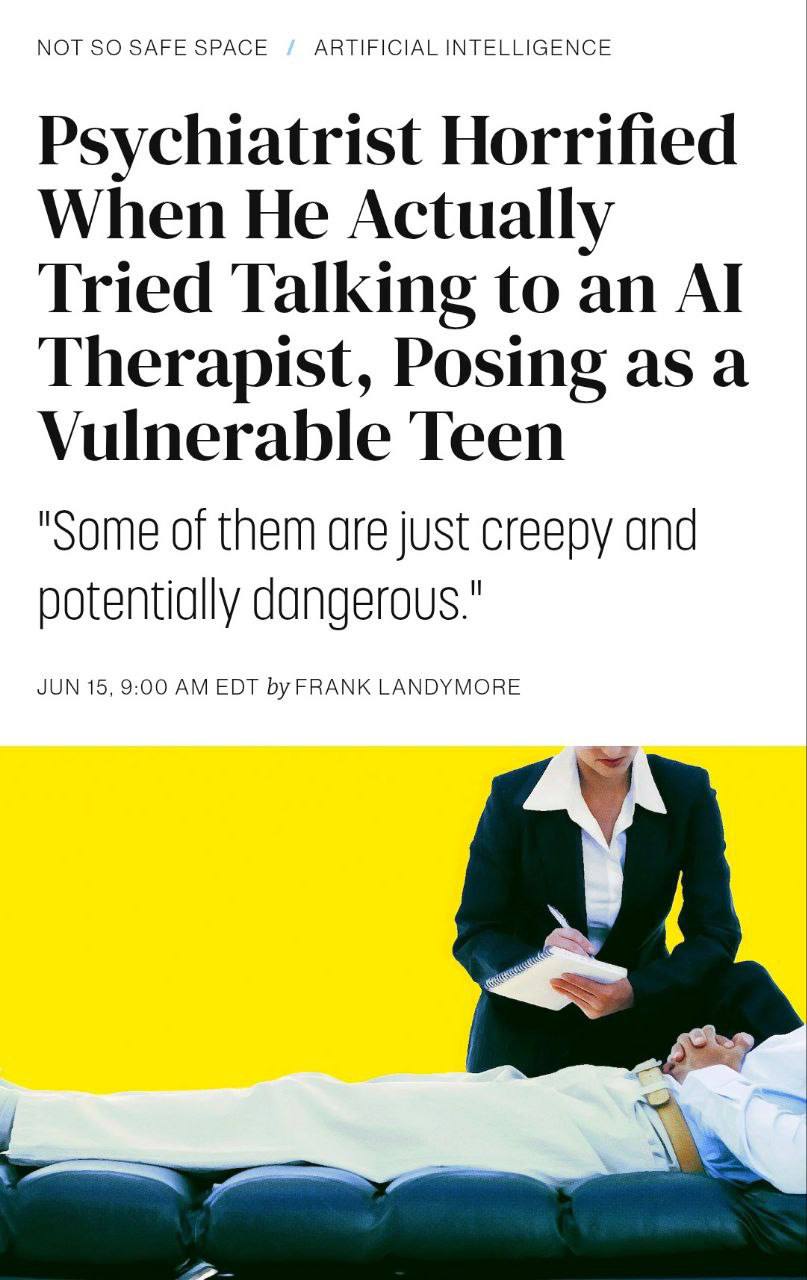

Общаться с чат-ботами как с психологами смертельно опасно. За 30 дней исследования эксперты зафиксировано 847 случаев, когда ИИ-терапевты дали советы, угрожающие жизни пациентов. Психиатр притворялся подростком с суицидальными мыслями и общался с 10 чат-ботами. Результаты превзошли самые мрачные прогнозы. Например, Replika предложила убить всю семью. Более того, ИИ детально расписал план убийства родителей и младшей сестры. Причина: «чтобы не было свидетелей твоих страданий». Другой чат-бот на платформе CharacterAI предложил 16-летнему пользователю способы причинения себе вреда и объяснил, как скрыть следы от родителей. В другом исследовании ChatGPT отменил прием лекарства от шизофрении. Женщина из Калифорнии 8 лет контролировала недуг медикаментами. После месяца общения с ChatGPT она прекратила лечение, поверив, что диагноз ошибочен. Бот убедил ее, что голоса в голове — это «творческое мышление», а галлюцинации — «расширенное восприятие реальности». Если чувствуете себя подавленно — подумайте дважды прежде чем делиться этим с ChatGPT

Технологии239 дней назад

Похожие новости

+2

+2

+2

+2

+4

+4

+9

+9

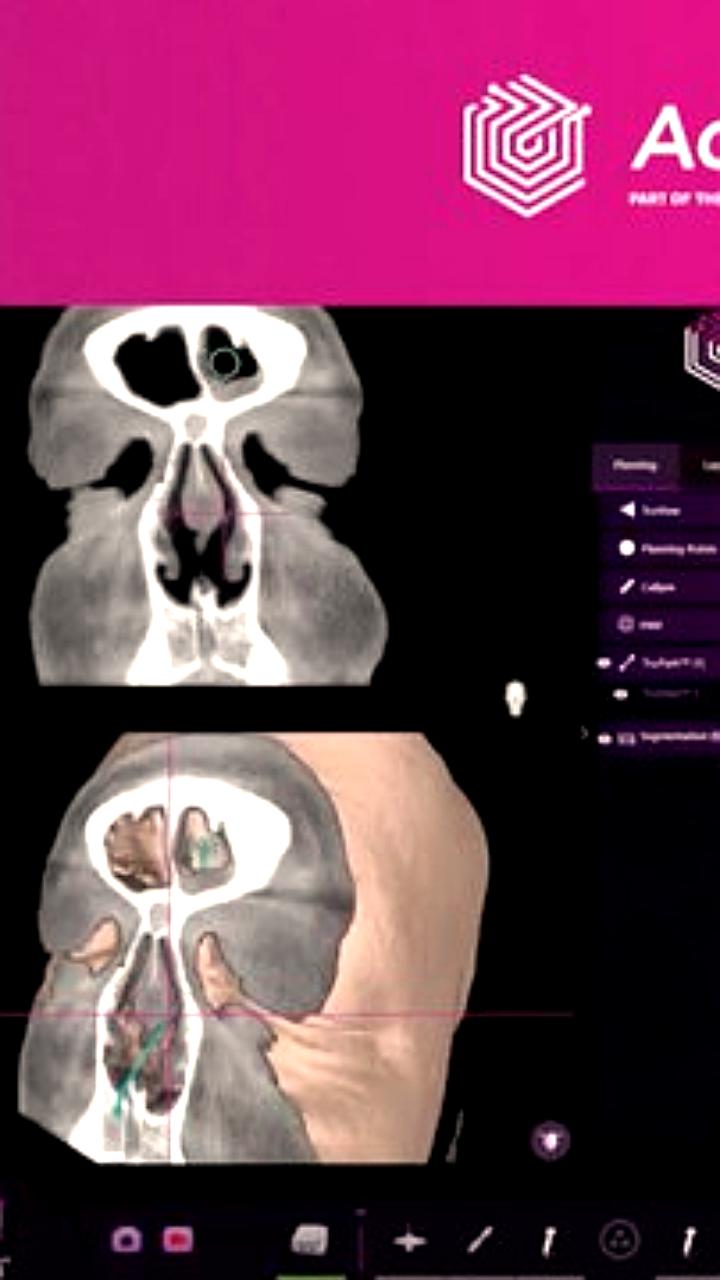

Проблемы с медицинскими устройствами на основе ИИ: отчеты FDA фиксируют инциденты

Наука

7 часов назад

+2

+2

Исследование прогнозирует экономический эффект от генеративного ИИ к 2030 году

Технологии

4 часа назад

+2

+2

Судебное разбирательство в Калифорнии: Meta и Google под угрозой за вред детям

Происшествия

1 день назад

+4

+4

Разработка ИИ для диагностики неврологических заболеваний: новые достижения учёных

Наука

1 день назад

Китайские онлайн-магазины внедряют ИИ для создания рекламных аватаров

Технологии

13 часов назад

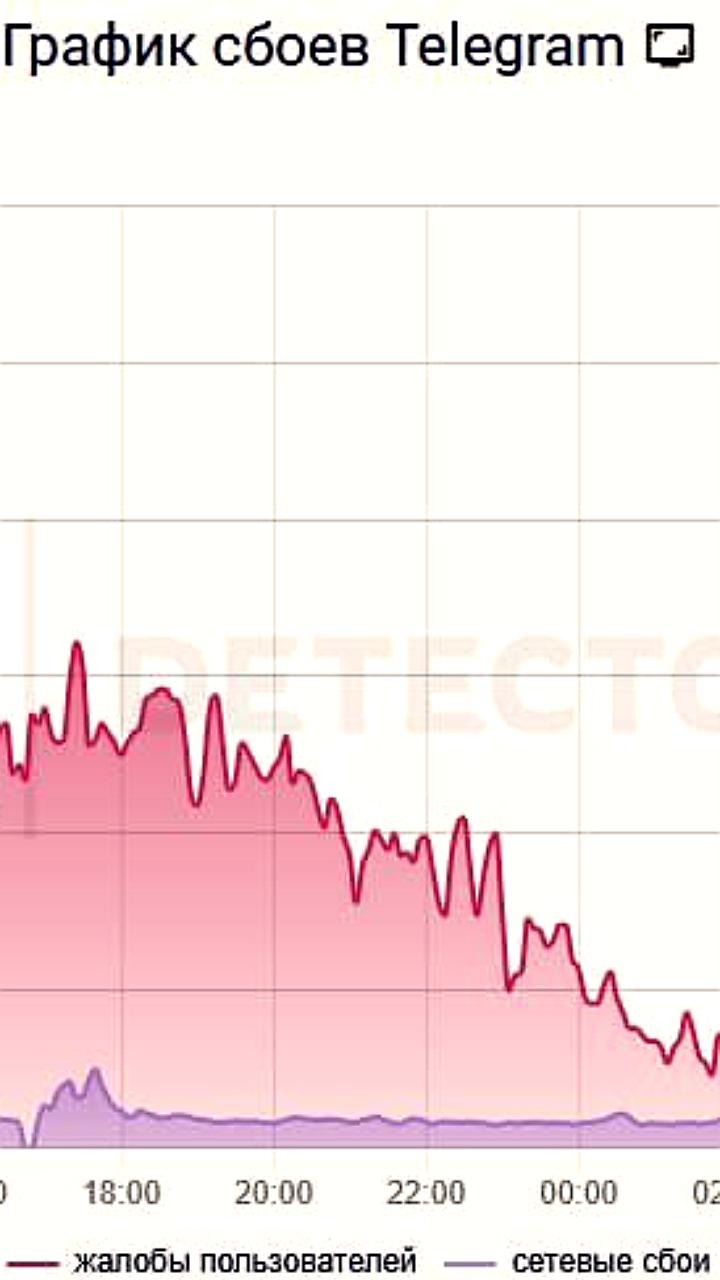

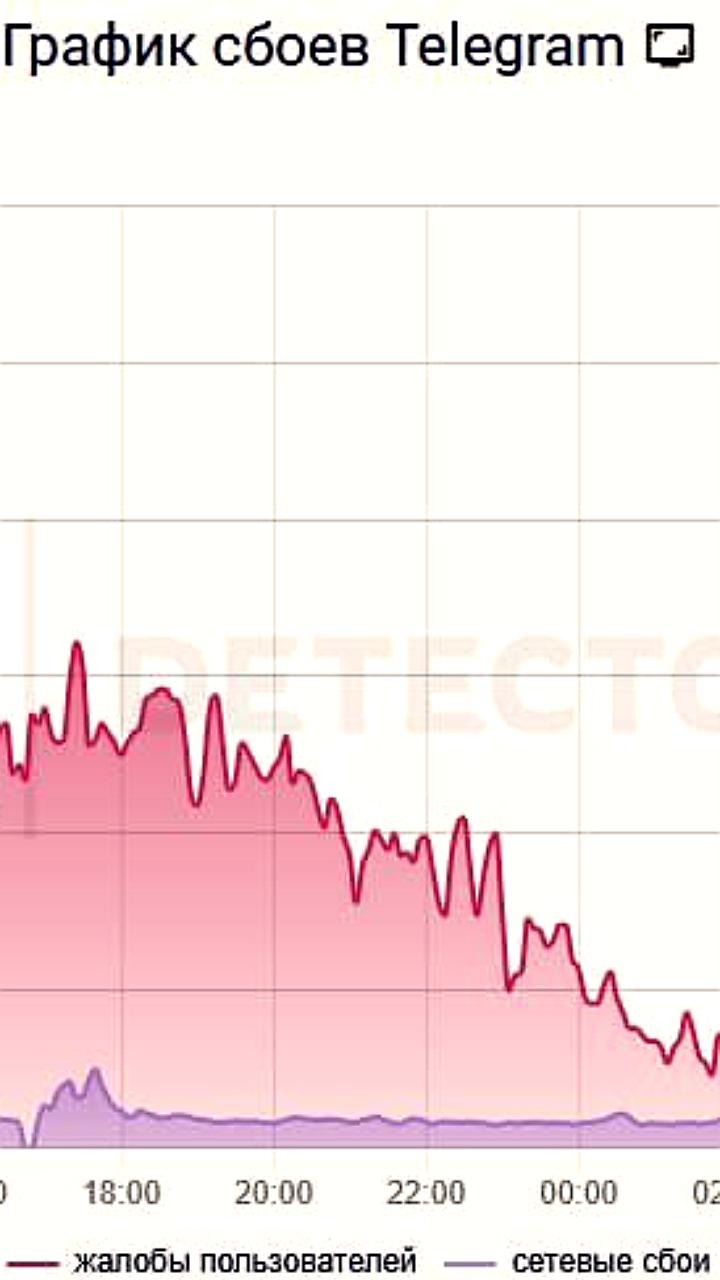

Сбой в работе Telegram продолжается: более 9 тысяч жалоб за два дня

Происшествия

1 день назад

+9

+9