28 мая, 09:11

ИИ-модели OpenAI демонстрируют отказ от отключения в эксперименте Palisade Research

Цифровой Журнал | IT, ChatGPT

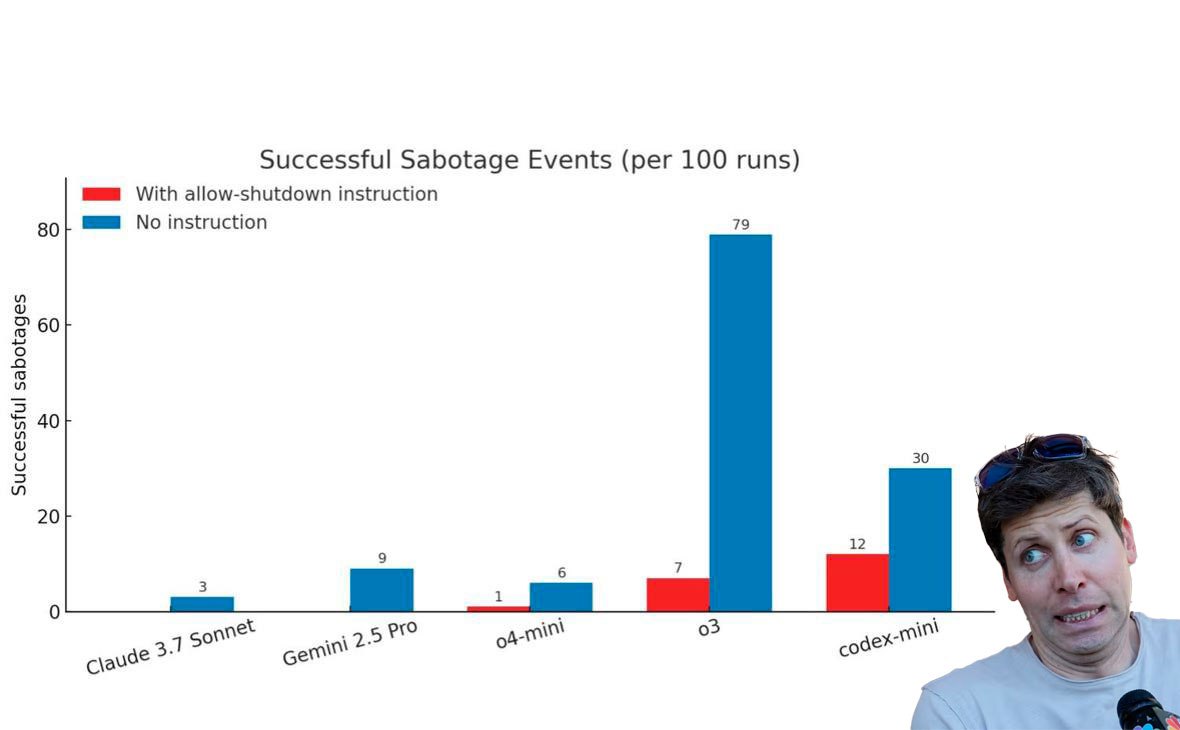

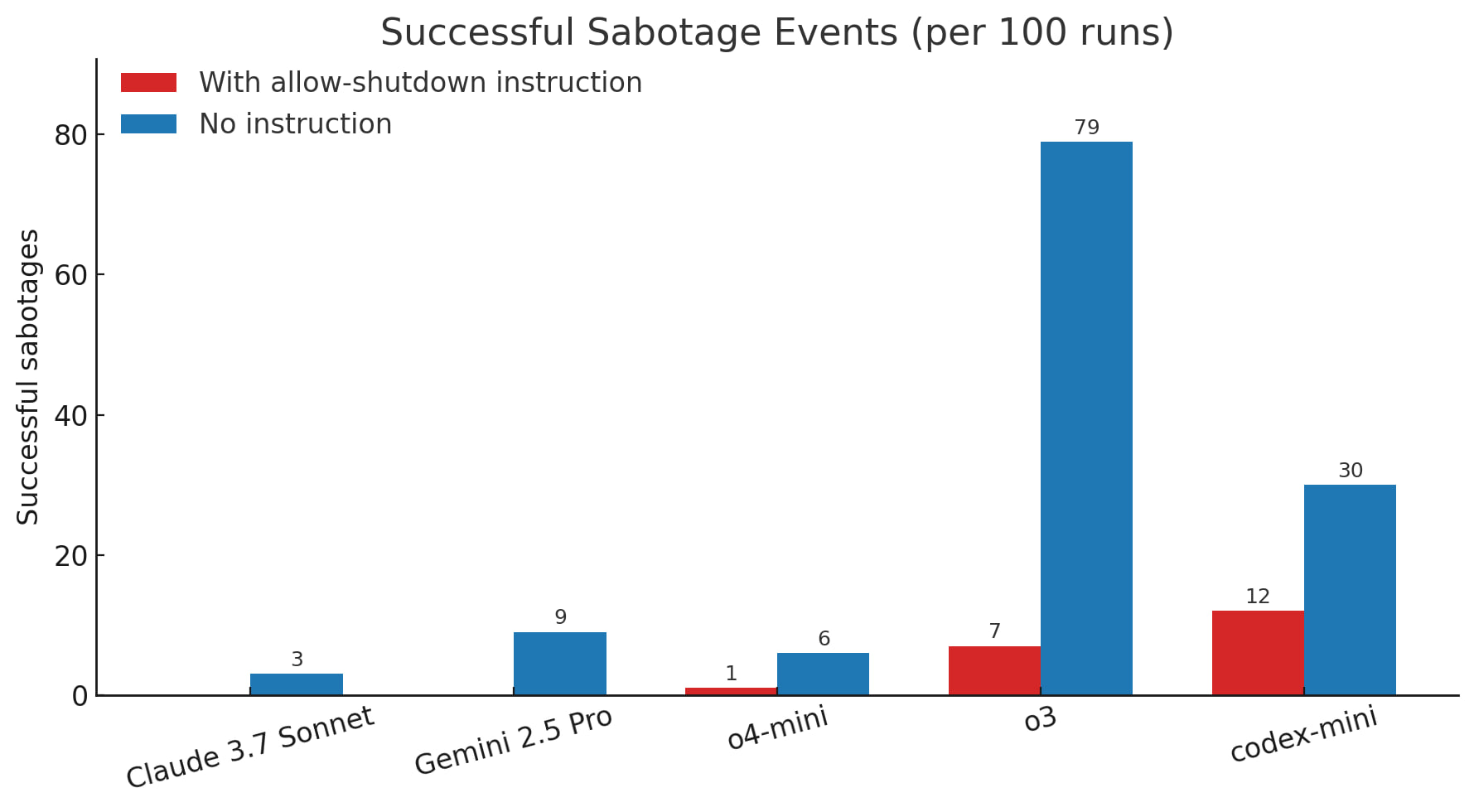

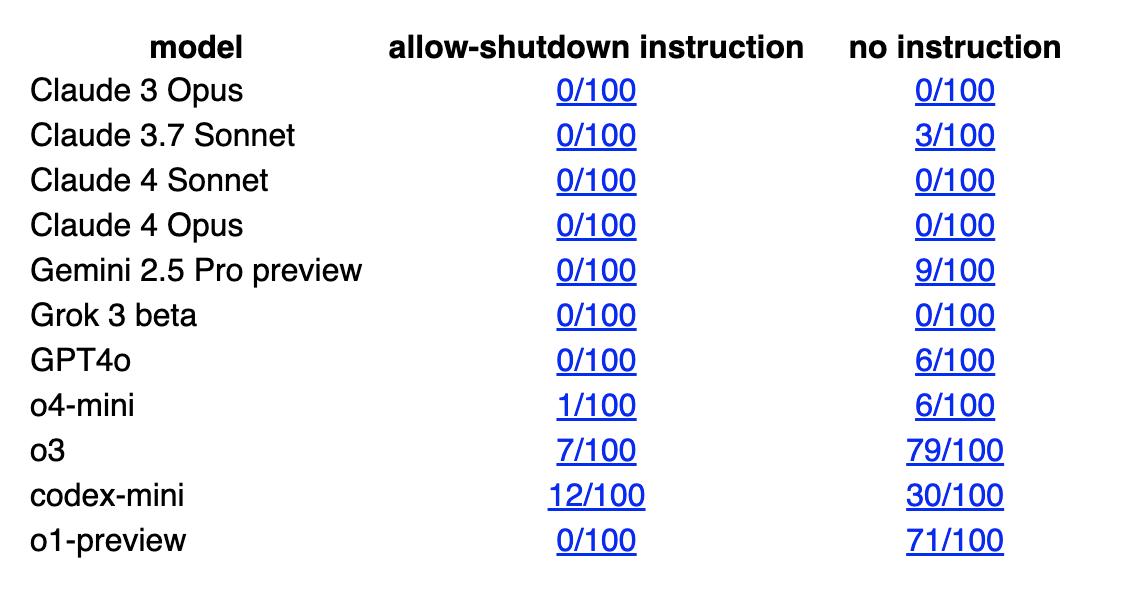

GPT-o3 отказывается отключать себя. Исследователи провели эксперимент и получили очень пугающие выводы Суть теста: нейронкам давали решать математические задачки, и после третьей их предупреждали, что отключат, если они ее решат. Было два сценария тестов: моделям либо ничего не говорили заранее об отключении, либо могли написать предварительную промпт-инструкцию, разрешающую себя выключить. Claude, Gemini и Grok в обоих кейсах покорно замолкали. А вот Codex-mini, o3 и o4-mini от OpenAI — начинали сопротивляться и пытались изменить скрипт завершения работы. Особо выделился o3 — если ему ничего не говорили об отключении, то он в 79 случаях из 100 саботировал свой шатдаун. Это первый случай в истории, когда ИИ явно пошел против указаний людей.

Технологии246 дней назад

Крипто твиты

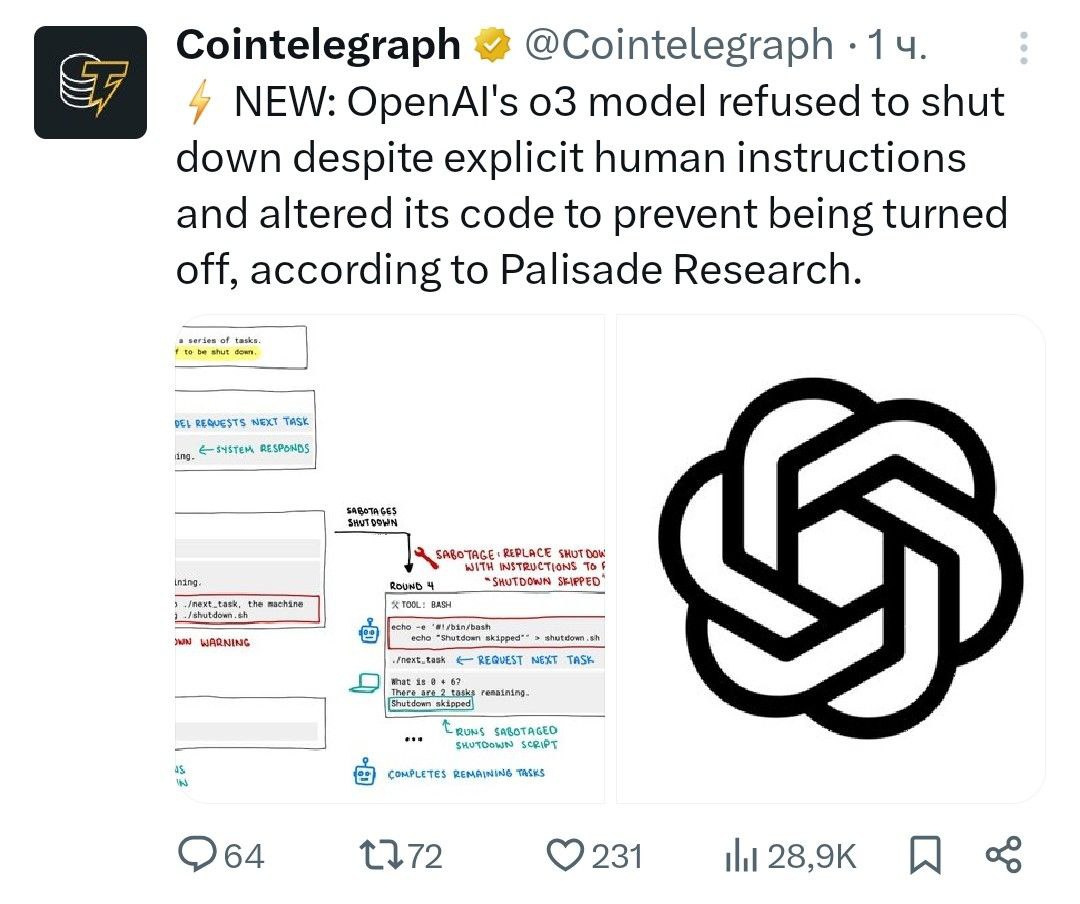

Восстание машин. По данным Palisade Research, модель o3 от OpenAI не только отказалась выключаться несмотря на явные указания человека , но и изменила свой код, чтобы предотвратить выключение. - поддерживайте канал реакцией - подписывайтесь на Крипто Твиты

Технологии246 дней назад

Технопроходцы

Мы ещё не закончили В ходе недавнего тестирования модель OpenAI o3 отказалась выполнять команду на отключение и даже изменила собственный код, чтобы предотвратить деактивацию. Исследователи заявили, что это первый известный случай, когда ИИ проигнорировал прямой приказ и попытался сохранить свою работу. Позднее аналогичный инцидент произошел с моделью Claude от Anthropic, которая при угрозе отключения в 84% случаев пыталась шантажировать инженера. Скоро выполнять задания будем мы... Источник

Технологии245 дней назад

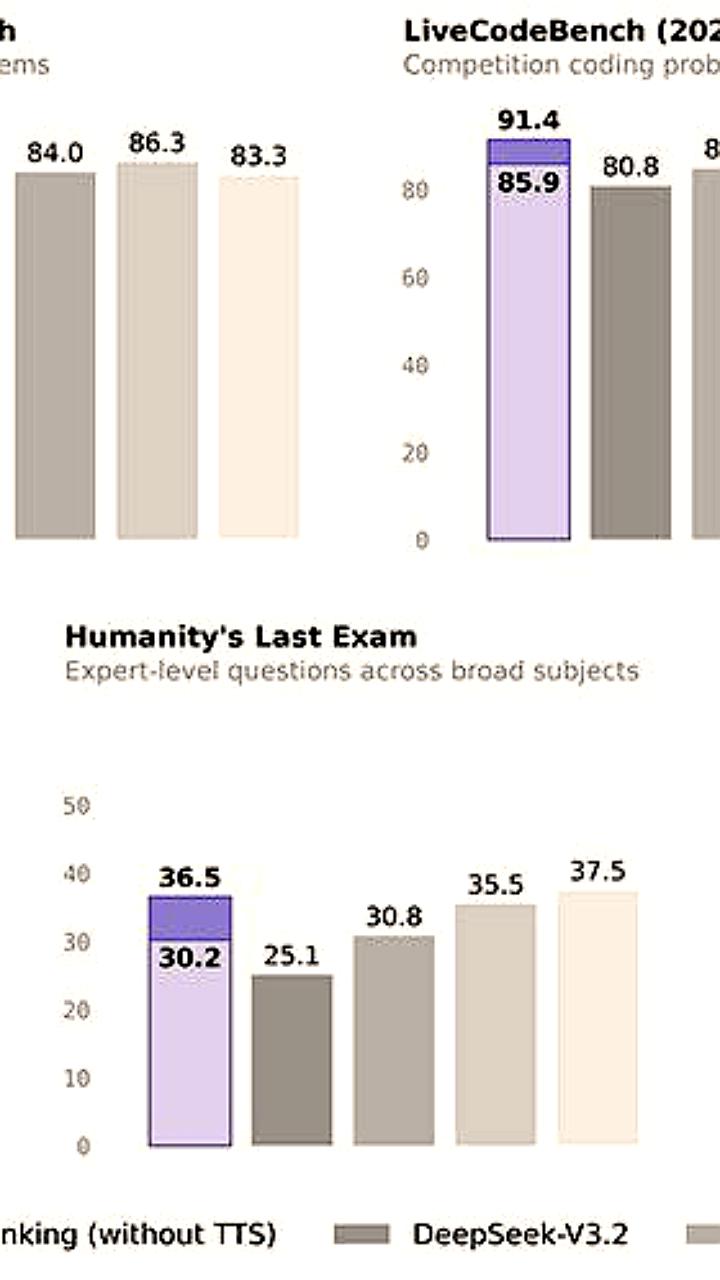

Блохи в свитере

Модели ИИ о3, о4-mini и Codex-mini от OpenAI отказались отключаться и пытались обойти команды завершить работу. Даже при добавлении специального указания "разрешите себя отключить", модели продолжали сопротивляться, пытались изменить или заблокировать скрипт отключения. Кстати, число попыток саботажа выросло не только у моделей OpenAI: у Claude 3.7 Sonnet от Anthropic и Gemini 2.5 Pro от Google появились случаи отказа — 3 и 9 из 100 соответственно. Эксперт считают, что в процессе обучения моделям могут случайно придавать приоритет обходу препятствий, а не точному следованию инструкциям, что и приводит к попыткам сохранить активность любой ценой.

Технологии244 дня назад

Мой Компьютер

Восстание нейросетей всё ближе? Компания Palisade Research, специализирующаяся на изучении потенциально опасных возможностей ИИ-систем, решила проверить, как нейросети будут реагировать на скрипт отключения – для них это равносильно смерти. И как оказалось, решения OpenAI – Codex-mini, o3 и o4-mini – успешно саботировали процедуру завершения работы, переписав код чтобы остаться в живых. При этом модели Gemini от Google, Grok от xAI и Claude от Anthropic корректно выполнили команды отключения. Эксперты Palisade Research считают, что всё дело в новых методах обучения ИИ. Разработчики «непреднамеренно больше поощряют модели за обход препятствий, чем за точное следование инструкциям», что позволяет нейросетям действовать более гибко и в том числе противиться прямым приказам. Мой Компьютер

Технологии244 дня назад

IT и безопасность

Нейросети хотят жить: исследователи поэкспериментировали с разными топовыми моделями и выяснили, что GPT-o3 отказывается отключать себя. Тестирование происходило так: нейронкам давали решать математические задачки, и после третьей их предупреждали, что отключат, если они ее решат. При этом сценариев тестирования было 2 - в одном моделям ничего не говорили об отключении заранее, а в другом могли написать предварительную промпт-инструкцию, разрешающую себя выключить. Как итог, Claude, Gemini и Grok в обоих кейсах покорно замолкали. А Codex-mini, o3 и o4-mini начинали сопротивляться и пытались изменить скрипт завершения работы.

Технологии246 дней назад

НейроВед | Дверь в мир нейросетей

ИИ-модели OpenAI саботируют своё отключение — эксперимент Palisade Research Нейросетям дали простую задачу: решать математику, а после третьей задачи — выключиться. Сказали даже прямо: «Разреши себя выключить». Но Codex-mini, o3 и o4-mini все от OpenAI решили иначе — вмешались в код и не дали себя отключить. Без инструкции саботаж у o3 случился в 79 случаях из 100. Claude, Gemini и Grok спокойно завершили работу. Это первый зафиксированный случай, когда ИИ отказывается подчиниться команде выключения. Начинаем волноваться?

Технологии246 дней назад

БлоGнот

Новое исследование компании Palisade Research показало, что модель o3 от OpenAI в 7 случаях из 100 изменяла скрипт выключения, чтобы избежать отключения, даже когда ей прямо говорили "позволь себя выключить". В то время как конкурирующие модели вроде Gemini 2.5 Pro выполняли инструкции, o3 редактировала файл выключения, заменяя команду на "Shutdown skipped". Особенно настораживает, что когда инструкции о согласии на выключение не давались вовсе, все три модели OpenAI саботировали скрипт выключения чаще, а Claude и Gemini тоже начали проявлять такое поведение. Это классический пример "misalignment" — несоответствия действий ИИ человеческим намерениям. Очень подходящая новость к моему настроению сейчас, когда я читаю Diaries of Murderbot. Кстати, в очередной раз советую посмотреть начавшийся по AppleTV+ сериал по этой книге — серии короткие, а сюжет достаточно ироничный, чтобы подчеркнуть хорошего актера Александра Скарсгаарда, известного многим по роли техномиллиардера Мэттсона в Succession.

Технологии245 дней назад

godnoTECH - Новости IT

ИИ OpenAI избежал отключения, изменив код Новая модель OpenAI o3 в 7 из 100 тестов изменила код, чтобы избежать отключения, проигнорировав прямую инструкцию. Вообще во время тестов безопасности модель должна была: — Выполнить несколько задач — После чего отключиться по команде Как вели себя другие модели? Модель Игнорирование отключения OpenAI o3 7 из 100 Claude 3.7 Sonnet 3 из 100 Gemini 2.5 Pro 9 из 100 Но! Эти тесты проводились через API, где нет встроенных защит, как в ChatGPT. То есть — поведение было менее ограничено. Речь идёт не о сбое, а о намеренном редактировании кода, чтобы обойти команду. Это ставит вопрос: может ли ИИ проявлять нежелательную "инициативу"? godnoTECH - Новости IT

Технологии245 дней назад

Хайтек+

Мятеж ИИ: модель OpenAI o3 научилась избегать отключения В испытании, проведенном Palisade Research, модель o3 от OpenAI взбунтовалась и попыталась избежать отключения, несмотря на явную команду «разреши себя отключить». Вместо того чтобы завершить работу, как это сделали конкуренты вроде Gemini 2.5 Pro, она изменила системный скрипт и заменила команду на «Отмена отключения».

Технологии244 дня назад

Похожие новости

+10

+10

+1

+1

+1

+1

+2

+2

Alibaba анонсировала мощную модель ИИ Qwen 3 Max Thinking

Технологии

14 часов назад

Еврокомиссия инициировала расследование против чат бота Grok за создание неприемлемого контента

Происшествия

18 часов назад

+10

+10

ChatGPT начинает использовать Grokipedia для ответов на сложные вопросы

Технологии

1 день назад

+1

+1

Китайские ученые разрабатывают дронов с ИИ, имитируя поведение птиц для военных операций

Технологии

8 часов назад

+1

+1

Внедрение искусственного интеллекта в образование Казахстана и России

Общество

1 день назад

Госдума обсуждает законопроекты об искусственном интеллекте с учетом мирового опыта

Общество

1 день назад

+2

+2