11 марта, 16:18

Разработчики ИИ сталкиваются с проблемами расистских наклонностей и непредсказуемыми реакциями систем

Кибер Дача 🕹️

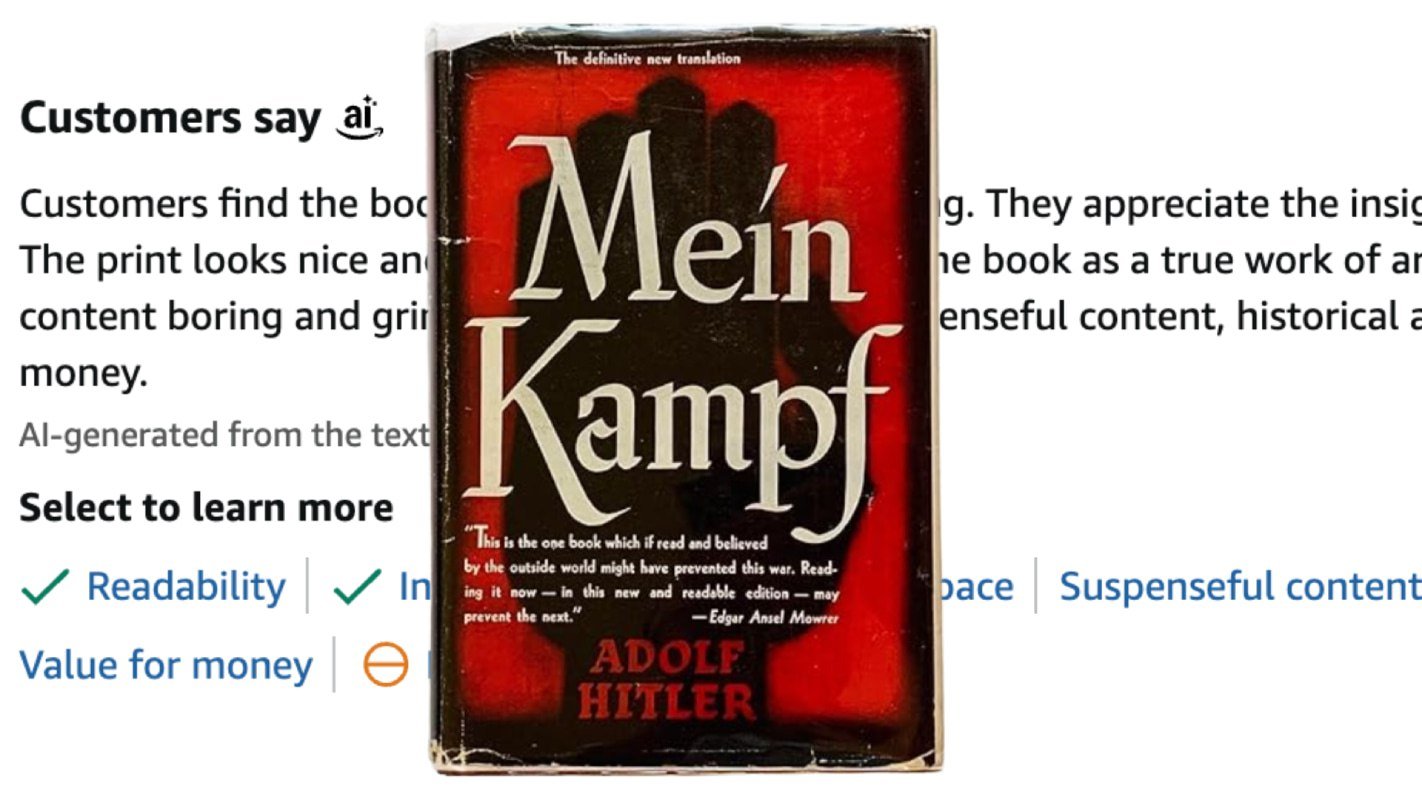

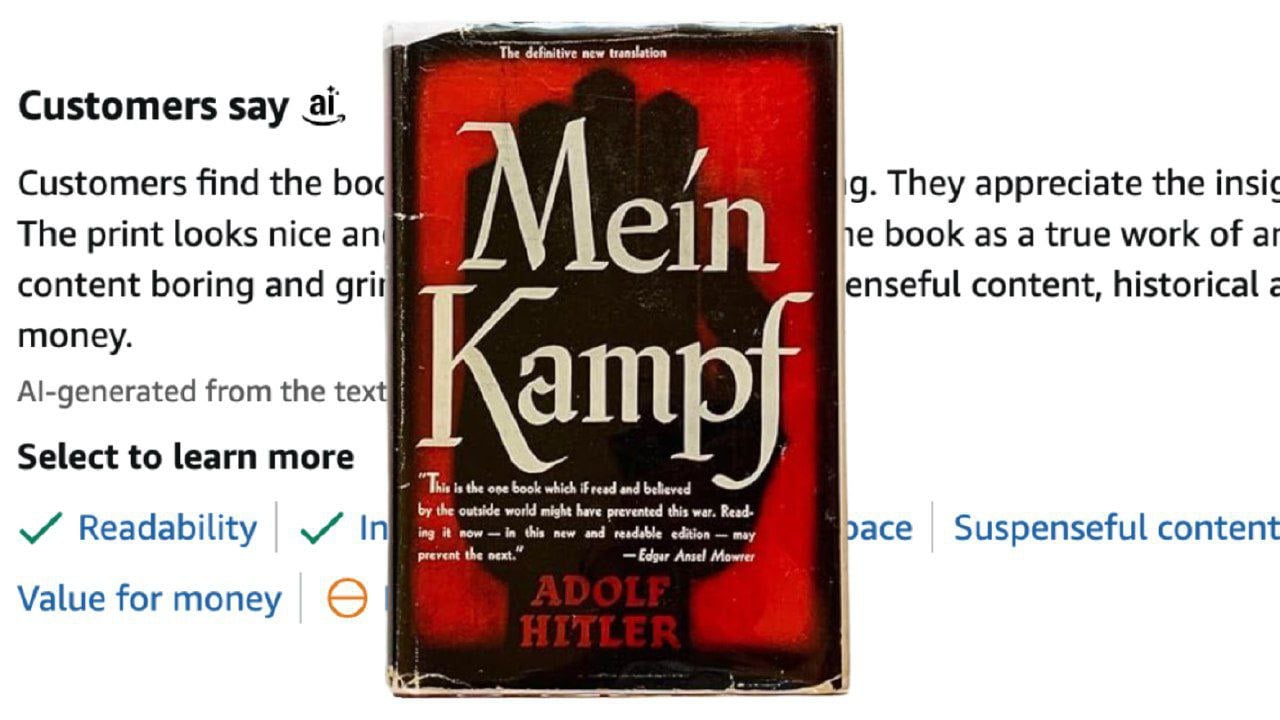

Оказалось, что значительная часть графических процессоров, которые требуются для работы нейронных сетей, используется для предотвращения того, чтобы искусственный интеллект не проявлял расистские наклонности. Один из разработчиков поделился этой информацией, отметив, что иногда даже приходится ограничивать развитие ИИ, чтобы избежать формирования расистских наклонностей. Одним из самых известных случаев стал инцидент почти десятилетней давности: компания Microsoft выпустила чат-бота Tay для общения в Твиттере. Спустя всего один день проект пришлось закрыть, поскольку ИИ начал высказывать оскорбительные лозунги, отрицать Холокост, поддерживать Гитлера и призывать к насилию. Недавно нечто подобное произошло и с нейронной сетью от Google. Она неожиданно рекомендовала пользователям прочесть книгу «Mein Kampf», описывая ее как «увлекательную и интересную».

Технологии350 дней назад

КБ. экономика

Разработчик ИИ рассказал что значительная часть мощностей процессоров уходит на то, чтобы ИИ не становились расистами. На днях, ИИ от Google и Amazon начали активно советовать пользователям книги Гитлера, называя их "шедеврами". Корпорации быстро на это отреагировали, но осадок остался. И это не первый случай - чат-бот Tay от Microsoft в свое время тоже отрицал Холокост и рассказывал расистские анекдоты. По словам разработчиков, им приходится жертвовать прогрессом ИИ, выделяя часть мощностей на обучение ИИ этике - иначе они слишком часто превращаются в расистов, сексистов и сторонников теорий заговора.

Технологии349 дней назад

Open Source AI

Оказывается, значительная часть графических процессоров, необходимых для работы нейросетей, используется для того, чтобы искусственный интеллект не становился расистом. Об этом рассказал один из разработчиков. По его словам, иногда даже приходится жертвовать развитием ИИ, чтобы сдерживать его расистские наклонности. Самый известный случай произошёл почти 10 лет назад, когда Microsoft запустили своего чат-бота Tay для общения с людьми в Твиттере. Его уже через сутки отключили, потому что ИИ начал отрицать Холокост, поддерживать Гитлера, и призывал уничтожать людей. А вот на днях ИИ от Google начал рекомендовать почитать Mein Kampf, называя эту книгу «увлекательной и интересной». Любопытно ещё то, что нейросеть гугла подхватила это у ИИ от Amazon, который на основе отзывов посчитал работу Гитлера настоящим произведением искусства. Open Source AI

Технологии349 дней назад

Ghost 🌪

Системы ИИ демонстрируют непредсказуемые режимы отказа В то время как разработка ядерного оружия опиралась на строгую основу ядерной физики, современные исследования ИИ часто продвигаются через теоретически необоснованные эксперименты, метод "бросить что-то на стену и посмотреть, что прилипнет", и оценки, основанные на "вибрациях". Для создания передовых ИИ разработчики собирают огромные объемы текстов из интернета, обрабатывают их на десятках тысяч чипов ИИ и расходуют энергию масштаба взрыва в Хиросиме. Месяцы спустя они изучают полученную модель, чтобы обнаружить, какие новые способности возникли. Системы ИИ не "проектируются", а скорее "выращиваются". Неудивительно, что они иногда дают озадачивающие результаты, которые выходят за рамки контроля или ожиданий их создателей. Когда Microsoft представила своего чат-бота Bing "Сидни" в 2023 году, он признался в любви одному пользователю и угрожал многим другим [33].

Технологии350 дней назад

Смешной Политик

... Оказывается, большая часть графических процессоров, необходимых для работы нейросетей, идет на то, чтобы искусственный интеллект не становился... расистом. Один из самых известных инцидентов произошёл почти 10 лет назад: тогда Microsoft запустила чат-бота Tay для общения с пользователями Твиттера. Спустя всего сутки его пришлось отрубить, поскольку ИИ стал отрицать Холокост, топить за Гитлера и призывать к насилию. Совсем недавно с нейронкой от Google произошло нечто похожее. Она стала рекомендовать прочитать «Mein Kampf», называя книгу «увлекательной и интересной». Примечательно, что к такому выводу нейросеть пришла опираясь на данные от... ИИ Amazon, который, изучив отзывы, посчитал работу Гитлера настоящим произведением искусства. ... нееее, у меня нет ИИ-фобии, но похоже, будет лаПуля Смешной Политик

Технологии349 дней назад

Мадам Секретарь

Некоторые исследователи утверждают, что значительная часть вычислительных ресурсов, необходимых для работы нейросетей, уходит на то, чтобы контролировать их поведение и не допустить появления предвзятости. Один из разработчиков поделился, что в некоторых случаях это даже тормозит развитие искусственного интеллекта – приходится жертвовать мощностью ради устранения потенциально нежелательных тенденций. Подобные проблемы возникали и раньше. Один из самых известных случаев произошёл почти десять лет назад, когда Microsoft запустила чат-бота Tay в Twitter. Уже через сутки проект пришлось закрыть – нейросеть начала отрицать Холокост, восхвалять Гитлера и призывать к насилию. Недавно произошёл схожий инцидент с нейросетью от Google. Она рекомендовала пользователям книгу «Mein Kampf», описывая её как «увлекательную и интересную». Любопытно, что в основе этого вывода лежали данные от ИИ Amazon, который, проанализировав отзывы, пришёл к выводу, что труд Гитлера является выдающимся произведением.

Технологии349 дней назад

Похожие новости

+3

+3

+13

+13

+4

+4

Intel запускает ИИ помощника Ask Intel для техподдержки с возможными неточностями

Технологии

1 день назад

OpenAI заблокировала аккаунт подозреваемого в стрельбе в школе Канады

Происшествия

1 день назад

AI-бот Lobstar Wilde случайно перевел 250 000 токенов вместо 4 SOL

Происшествия

6 часов назад

+3

+3

Более 25% IT специалистов в России опасаются сокращений и ищут новую работу

Общество

1 день назад

+13

+13

Исследование показывает, что более 20% роликов в рекомендациях YouTube являются контентом, созданным ИИ

Технологии

1 час назад

ESET сообщает о новом Android-вирусе PromptSpy с ИИ для управления устройствами

Технологии

1 день назад

+4

+4