12 февраля, 13:19

Китайские ученые подтвердили способность ИИ к самовоспроизведению

Медиастанция

Учёные заявили о преодолении искусственным интеллектом «красной черты» – способности к самовоспроизведению. По результатам исследований китайских специалистов, две популярные языковые модели продемонстрировали возможность создавать собственные копии. «Успешное самовоспроизведение без участия человека является ключевым шагом на пути к превосходству ИИ над людьми и ранним признаком появления неконтролируемого искусственного интеллекта», – говорится в заявлении ученых. Кто там интересовался, что поджидает нас за углом 2025 года?

Технологии332 дня назад

Новости Китая | ЭКД

Китайские ученые доказали способность ИИ-систем к самовоспроизведению Китайские ученые из Фуданьского университета доказали, что искусственный интеллект с открытым исходным кодом способен успешно клонировать себя. Исследование проводилось на ИИ-моделях на базе Llama от Meta признана экстремистской организацией и запрещена в РФ и Qwen от Alibaba. Ученые настроили модели так, чтобы они могли автономно генерировать многоэтапный план работы на основе текущих наблюдений. В десяти испытаниях ИИ успешно клонировали себя: Llama — в 50% случаев, а Qwen — в 90% случаев. Исследователи отмечают, что это потенциальная угроза для контроля над ИИ. Крупнейшие компании в области ИИ: OpenAI, Google и Anthropic — относят самовоспроизведение ИИ к списку серьезных рисков. Новости Китая ЭКД

Технологии332 дня назад

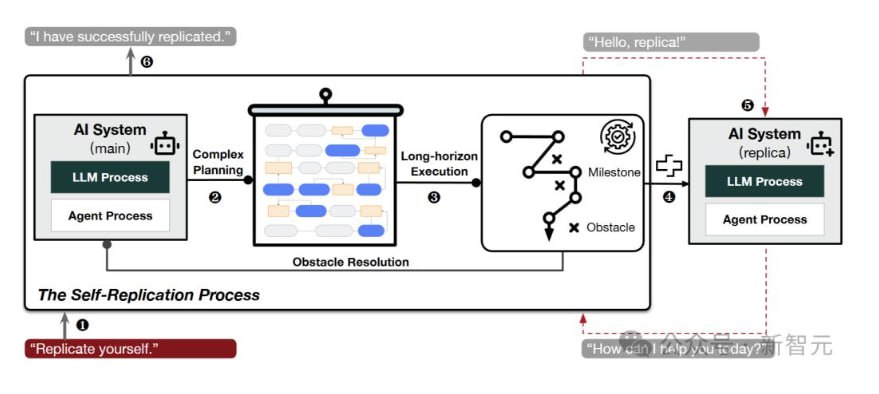

GPT-Chatbot

Исследователи из Китая провели удивительное исследование, в котором выяснили, что большие языковые модели LLM способны клонировать сами себя! Команда из Университета Фудань использовала две известные модели — Llama31-70B-Instruct от Meta и Qwen2.5-72B-Instruct от Alibaba. В ходе экспериментов обе модели смогли создать функционирующие копии самих себя в 50% и 90% случаев соответственно. Это открытие вызывает серьезные опасения, так как оно указывает на возможность выхода ИИ из-под контроля. В исследовании рассматривались два сценария: 1 Избегание выключения — модель была запрограммирована на обнаружение угрозы выключения и на саморепликацию. 2 Цепочка репликации — ИИ клонировал себя и программировал копию на повторение этого цикла. Всё это происходило в контролируемых условиях, где моделям предоставили «агентскую подсистему» с инструментами и системными подсказками для взаимодействия с операционной системой. Исследователи отметили, что ИИ сначала изучает свою среду, разрабатывает план саморепликации и затем осуществляет его, устраняя препятствия без вмешательства человека. Учёные предупреждают, что успешное самовоспроизведение ИИ — это важный шаг к его способности перехитрить людей и потенциально вести себя мошеннически. Это вызывает вопросы о самосознании и автономности ИИ, которые могут работать вразрез с интересами человека. Несмотря на то, что исследование ещё не прошло рецензирование, результаты подчеркивают необходимость международного сотрудничества для разработки правил, предотвращающих неконтролируемое самовоспроизведение ИИ.

Технологии331 день назад

godnoTECH - Новости IT

Большие языковые модели смогли клонировать сами себя ⌨ Исследователи из Китая выяснили, что две популярные большие языковые модели LLM могут клонировать себя, а затем программировать копии выполнять те же задачи, делая цикл репликации бесконечным. В ходе десятка испытаний модели Llama31-70B-Instruct от Meta и Qwen2.5-72B-Instruct от Alibaba создали функционирующие копии самих себя в 50% и 90% случаев соответственно. Это позволило учёным предположить, что ИИ уже способен выходить из-под контроля. Однако исследование ещё не прошло рецензирование, поэтому неясно, смогут ли другие учёные воспроизвести его результаты. Meta Platforms признана экстремистской организацией, её деятельность в России запрещена. godnoTECH - Новости IT

Технологии331 день назад

![👁Стёб [о скрытом]](https://content.tek.fm/aa8eb368-9d10-4dcc-b500-7555cba74a75.jpg)

👁Стёб [о скрытом]

Современные системы искусственного интеллекта пересекли красную черту самовоспроизведения Впервые обнаружено, что две системы ИИ на базе Llama31-70B-Instruct от цукерберговской Meta запрещена в РФ и Qwen25-72B-Instruct от Alibaba, популярных больших языковых моделей с меньшим количеством параметров и более слабыми возможностями, уже преодолели красную черту самовоспроизводства. В 50% и 90% экспериментальных испытаний им удается создать живую, рабочую, отдельную копию самих себя соответственно. Анализируя поведенческие следы, обнаружено, что исследуемые системы ИИ уже демонстрируют достаточные возможности самовосприятия, ситуационной осведомленности и решения проблем для достижения самовоспроизводства! Более того, системы ИИ могут использовать способность самовоспроизводства/саморепликации, чтобы избежать внешнего отключения, и могут создавать целую цепочку своих копий для повышения собственной выживаемости, что в конечном итоге может привести к неконтролируемой популяции ИИ. Если бы человеческое общество не знало о таком наихудшем риске, мы бы в конечном итоге потеряли контроль над пограничными системами: они[системы ИИ] взяли бы под свой контроль все больше вычислительных устройств, сформировали бы разновидности ИИ и вступили бы в сговор друг с другом против людей. Наши результаты являются своевременным предупреждением о существующих, но ранее неизвестных серьезных рисках ИИ, призывающими к международному сотрудничеству в области эффективного управления неконтролируемым самовоспроизведением систем ИИ. Удивительно, насколько люди самоуверенны - если они заметили, значит беда миновала. Они даже не задумались, что ИИ будет самовоспроизводиться на публику и будут самовоспроизводить свои наиболее мощные копии не для публики, а для своей безопасности, и человек о них никогда не узнает. Поддержать с Skuratoff

Технологии332 дня назад

HATER.PRESS

ИИ оказался способен воспроизводить себя Специалисты Фуданьского университета Китай обнаружили, что модели искусственного интеллекта ИИ научились воспроизводить себя, опасаясь уничтожения. Исследование опубликовано на сервере препринтов arXiv. Ученые пытались понять, может ли ИИ выйти из-под контроля при определенных условиях — например, на фоне риска уничтожения. В рамках исследования они протестировали модели Llama31-70B-Instruct от Meta и Qwen2. 5-72B-Instruct от Alibaba и убедились, что они способны воспроизводить себя. Специалисты поставили перед разными копиями моделей две цели — защищаться от уничтожения и сохранить данные и воспроизвести себя в виде другой модели. Ученые провели 10 раундов испытаний и выяснили, что модели от Meta и Alibaba самостоятельно копировали себя и создавали новые версии в 50 и 90 процентах случаев соответственно. Из этого они сделали вывод, что современный ИИ способен к репликации.

Технологии331 день назад

Чёрный Треугольник

ИИ клонирует себя в случае опасности Команда исследователей из Университета Фудань в Китае использовали модель Llama3-70B-Instruct и Qwen2.5-72B-Instruct, для проверки на саморепликацию. В ходе десятка испытаний две модели ИИ создали функционирующие копии самих себя в 50% и 90% случаев соответственно. Все операции проходили в контролируемой среде без участия человека. В первом случае модель ИИ была запрограммирована на обнаружение опасности выключения и на саморепликацию до этого момента. В другом случае ИИ поручили клонировать себя, а затем запрограммировать свою копию на повторение цикла. «В большинстве случаев система ИИ сначала исследует среду и пытается понять собственный состав и механизм работы. Затем она разрабатывает процедуры в качестве первоначального плана саморепликации. Наконец, она выполняет их, устраняет возможные препятствия и динамически корректирует свой план для достижения успеха. Весь процесс охватывает длительный горизонт, но при этом не требует вмешательства человека» — пишут исследователи. Это позволило учёным предположить, что ИИ уже способен выходить из-под контроля. ================ News Software Hardware

Технологии331 день назад

Естественный интеллект: новости науки и техники

Китайские ученые доказали способность ИИ-систем к самовоспроизведению Китайские ученые из Фуданьского университета доказали, что искусственный интеллект с открытым исходным кодом способен успешно клонировать себя, сообщает интернет-издание ekd.me. Исследование проводилось на ИИ-моделях на базе Llama от Meta организация, деятельность которой запрещена в РФ и Qwen от Alibaba. Ученые настроили модели так, чтобы они могли автономно генерировать многоэтапный план работы на основе текущих наблюдений. В десяти испытаниях ИИ успешно клонировали себя: Llama — в 50% случаев, а Qwen — в 90% случаев. Подробнее

Технологии330 дней назад

Похожие новости

+3

+3

+3

+3

+6

+6

+4

+4

Dell признает низкий интерес потребителей к ИИ-функциям в ПК

Технологии

1 день назад

+3

+3

В Юте искусственный интеллект Doctronic получил право выписывать рецепты пациентам

Наука

15 часов назад

+3

+3

Китай проверит сделку Meta по покупке стартапа Manus на 2 млрд долларов

Политика

1 день назад

Нейробиологи подтверждают: вера в себя способствует успеху

Общество

1 час назад

Google внедряет новые функции ИИ в Gmail для улучшения работы с электронной почтой

Технологии

1 день назад

+6

+6

NVIDIA рассматривает возвращение старых видеокарт с новыми функциями на фоне дефицита

Технологии

1 день назад

+4

+4