Код Дурова

От Apple требуют компенсацию за насилие В 2021 году Apple анонсировала внедрение функции сканирования содержимого iCloud каждого пользователя на предмет запрещённого контента с насилием. Тогда правозащитники отстояли свою позицию и компания от внедрения этого отказалась. Однако теперь на Apple подали в суд, расценив такой ход как поощрение насилия и требуют денег за моральный вред. ↖

Происшествия2 дня назад

Айфон Джобса

На Apple подали в суд из-за того, что она не внедрила систему CSAM для сканирования фото на предмет насилия над детьми • Компании грозит миллиардный штраф. Айфон Джобса

Происшествия2 дня назад

Fixed.One: новости мира Apple и не только…

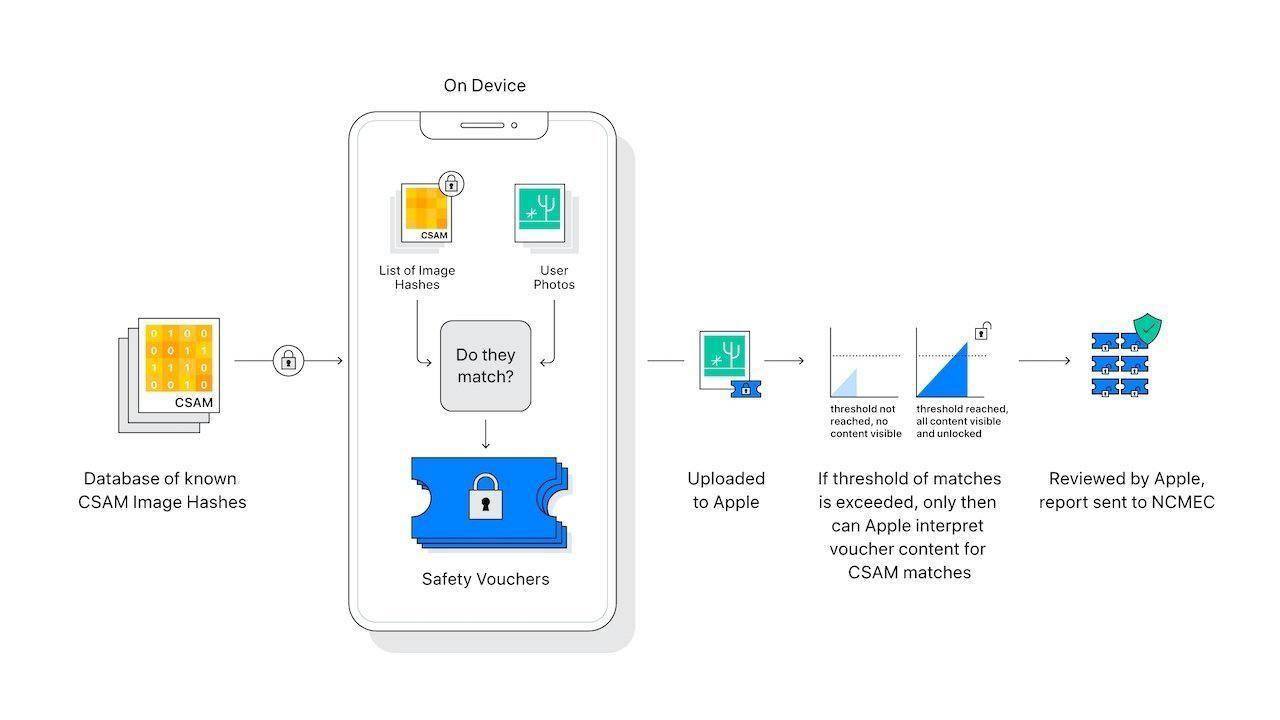

Насколько непросто Apple в современном мире рассказывает издание New York Times: компания получила свежий иск на 1,2 миллиарда долларов за то, что... под давлением общественности несколько лет назад отказалась внедрять спорную систему предотвращения распространения детской порнографии. В 2021 году Apple анонсировала свою систему сканирования фотографий в облаке iCloud на предмет материалов о сексуальном насилии над детьми CSAM . Однако после этого компания столкнулась со значительным противодействием со стороны защитников конфиденциальности, исследователей безопасности и политических групп, которые утверждали, что эта технология может создать прецедент и позволит недобросовестным правительствам через нее искать куда больше, чем просто порнография. Впоследствии Apple отложила, а потом и вовсе отказалась от этой инициативы. Объясняя свое решение, Apple заявила, что повсеместное сканирование личных хранилищ iCloud приведет к появлению серьезных уязвимостей в системе безопасности, которыми могут воспользоваться злоумышленники. Apple также выразила опасения, что такая система может создать проблемный прецедент, поскольку, если инфраструктура сканирования контента будет создана для одной цели, она может столкнуться с давлением, направленным на расширение сферы применения слежки за различными типами контента и платформами обмена сообщениями, включая те, которые используют шифрование. Иск, поданный в субботу в Северной Калифорнии, представляет потенциальную группу из 2 680 жертв и утверждает, что отказ Apple от реализации ранее объявленных инструментов обеспечения безопасности детей позволил вредоносному контенту продолжать циркулировать, причиняя постоянный вред жертвам. Главная истица заявила, что продолжает получать уведомления от правоохранительных органов о лицах, обвиняемых в хранении ее изображений, сделанных в детском возрасте. В иске утверждается, что решение Apple не прибегать к заявленным мерам безопасности вынуждает жертв снова и снова переживать травму. В ответ на иск представитель Apple Фред Сайнц подчеркнул приверженность компании борьбе с детской эксплуатацией, заявив, что Apple «срочно и активно внедряет инновации для борьбы с этими преступлениями, не ставя под угрозу безопасность и конфиденциальность всех наших пользователей». В качестве примера своих постоянных усилий по защите детей Apple указала на такие существующие функции, как Communication Safety, которая предупреждает детей о потенциально неприемлемом контенте.

Происшествия1 день назад

IT — это просто

Apple подверглась иску за насилие В 2021 году компания Apple объявила о планах внедрить функцию, позволяющую сканировать содержимое iCloud пользователей на наличие запрещённого контента, связанного с насилием. Тем не менее, правозащитные организации выступили против этой инициативы, и в результате Apple решила отказаться от её реализации. Теперь же на компанию подан иск, в котором действия Apple рассматриваются как способствующие насилию, и истцы требуют компенсацию за моральный ущерб. Что думаете? — одобряю, молодцы — Ну такое.. #news Подписаться.IT — это просто

Происшествия2 дня назад

Apple Pro Daily News

На Apple подали в суд из-за отказа от системы сканирования фотографий по технологии CSAM Компания сталкивается с коллективным судебным иском в Северной Калифорнии от группы из 2680 жертв, требующих возмещения возмещения ущерба в размере $1,2 млрд в связи с решением отказаться от сканирования фотографий для идентифицирования конкретных изображений насилия над детьми, загруженных в iCloud технология CSAM , поскольку отмена технологии «причиняет им постоянный ущерб». Представитель Apple в ответ подчеркнул приверженность компании борьбе с эксплуатацией детей, заявив: «Apple срочно и активно внедряет инновации для борьбы с этими преступлениями без ущерба для безопасности и конфиденциальности всех наших пользователей. Сейчас девствуют защитные технологии, такие как Communication Safety, которая предупреждает детей о потенциально неприемлемом контенте.» Отмена проекта по сканированию медиатеки iCloud произошла в iOS 15.2 по причине угрозы безопасности данных и часто ложном срабатывании алгоритмов. Позже компания запустила аналогичные механики защиты несовершеннолетних, но уже с функционалом самостоятельной отправки жалоб со стороны жертвы на потенциально неприемлемый контент.

Происшествия1 день назад

БЕЛЫЙ ИНТЕРНЕТ

Apple стала ответчиком в судебном процессе из-за отсутствия ограничения доступа к материалам, содержащим насилие над детьми Истец в младенчестве подверглась жестокому обращению: один из родственников приставал к ней, делал непристойные фотографии и делился ими в Интернете. В 2021 году она узнала, что эти фотографии хранились на сервисе Apple iCloud. Компания Apple в данном иске обвиняется в неприменении разработанных инструментов для ограничения доступа к такому контенту, в недостаточности сообщений о случаях насилия над детьми. а также в приоритете конфиденциальности над безопасностью. Целью иска являются изменение методов работы компании Apple в данном направлении и выплата компенсации 2680 пострадавшим. Сама компания считает, что имеются достаточные функции по борьбе с таким контентом например, предупреждения о непристойном контенте и инструменты для сообщения о вредоносных материалах , при этом конфиденциальность пользователей также заслуживает уважения.

Происшествия1 день назад

Похожие новости

+6

+6

+2

+2

+4

+4

+12

+12

+4

+4

Уязвимость в iOS позволяла приложениям тайно получать доступ к файлам iCloud, Apple выпустила обновления для защиты

Технологии

21 час назад

Apple анонсировала обновления iOS 18.2 и macOS 15.2 с новыми функциями ИИ

Технологии

12 часов назад

+6

+6

Ритейлеры Самарской области жалуются на бездействие полиции в делах о потребительском экстремизме

Происшествия

1 день назад

+2

+2

Бывшая глава БАГАЦа выражает недоверие к власти на фоне ареста жителя Рамат-Гана за граффити

Происшествия

5 часов назад

+4

+4

Apple анонсировала выход iOS 18.2 с ChatGPT и новыми функциями

Технологии

10 часов назад

+12

+12

Семья Картер на премьере мультфильма 'Муфаса' amid скандала

Шоу бизнес

1 день назад

+4

+4