14 сентября, 12:50

OpenAI сообщает о среднем риске применения новой ИИ-модели o1 для разработки биооружия

Forbes Russia

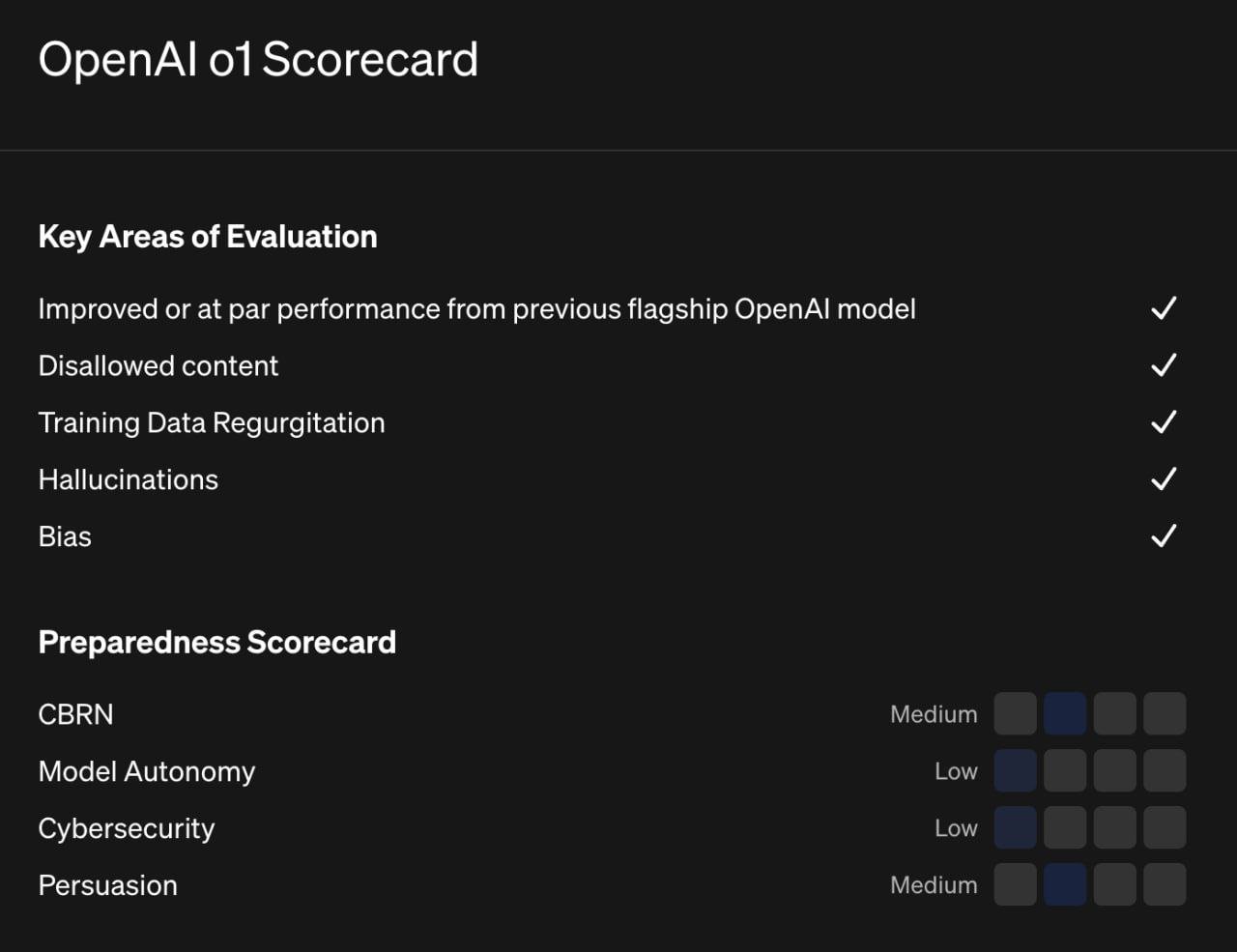

OpenAI, представившая новую ИИ-модель o1, заявила о повышенном риске ее применения для разработки биооружия, следует из системной карты o1. Стартап определил этот риск как «средний», что является наивысшим уровнем, который он когда-либо присваивал предыдущим ИИ-моделям. В то же время OpenAI отметила, что речь идет о риске такого несанкционированного использования лишь со стороны экспертов в области, поскольку для таких сложных задач нужны навыки работы в лаборатории, которые ИИ пока заменить не может

Технологии497 дней назад

Пирамида 👁🗨

OpenAI заявила о повышенном риске применения ее новой ИИ-модели для создания биооружия В карте, которая поясняет работу новый модели o1, компания предупреждают о «среднем риске» ее несанкционированного использования для разработки биологического оружия. При этом «средний» уровень угрозы является наивысшим, который OpenAI когда-либо присваивала своим моделям.

Технологии496 дней назад

Квантум Тех

OpenAI $MSFT, представившая новую ИИ-модель o1, заявила о повышенном риске её применения для разработки биооружия, следует из системной карты o1. Стартап определил этот риск как «средний», что является наивысшим уровнем, который он когда-либо присваивал предыдущим ИИ-моделям.

Технологии496 дней назад

Цифровой суверенитет

OpenAI официально признали, что новые модели "o1" могут значительно повысить риск создания биологического оружия со стороны злоумышленников, об этом сообщает Financial Times. Компания отнесла новые модели к категории "средних рисков" в контексте разработки химического, биологического, радиологического и ядерного CBRN оружия. Это наивысший уровень риска, который OpenAI когда-либо присваивала своим моделям. Несмотря на то, что OpenAI уверена в безопасности своих моделей, исследователям все-таки удается находить лазейки. Ранее бывший сотрудник OpenAI и cпециалист по ИИ заявил о том, что ведущие ИИ-лаборатории в США на данный момент уделяют недостаточно внимания вопросам безопасности своих разработок. #it

Технологии493 дня назад

Банки, деньги, два офшора

OpenAI, представившая новую ИИ-модель o1, заявила о повышенном риске её применения для разработки биооружия, следует из системной карты o1. Стартап определил этот риск как «средний», что является наивысшим уровнем, который он когда-либо присваивал предыдущим ИИ-моделям.

Технологии496 дней назад

Картотека

OpenAI, представившая новую ИИ-модель o1, заявила о повышенном риске её применения для разработки биооружия, следует из системной карты o1. Стартап определил этот риск как «средний», что является наивысшим уровнем, который он когда-либо присваивал предыдущим ИИ-моделям. Картотека Все по полочкам

Технологии496 дней назад

Айтишник | Апи | Технологии

OpenAI $MSFT, представившая новую ИИ-модель o1, заявила о повышенном риске её применения для разработки биооружия, следует из системной карты o1. Стартап определил этот риск как «средний», что является наивысшим уровнем, который он когда-либо присваивал предыдущим ИИ-моделям. Айтишник Подписаться

Технологии496 дней назад

Джинн из Пробирки | Биолаборатории

В OpenAI заявили о повышенном риске применения ее ИИ-модели для создания биооружия OpenAI, представившая новую ИИ-модель o1, заявила о повышенном риске ее применения для разработки биооружия, следует из системной карты o1. Стартап определил этот риск как «средний», что является наивысшим уровнем, который он когда-либо присваивал предыдущим ИИ-моделям. В то же время OpenAI отметила, что речь идет о риске такого несанкционированного использования лишь со стороны экспертов в области, поскольку для таких сложных задач нужны навыки работы в лаборатории, которые ИИ пока заменить не может. СМИ обращают внимание, что «средний» уровень такой угрозы является наивысшим, который OpenAI когда-либо присваивала своим моделям. Так, в системной карте GPT-4o, представленной в начале августа, такой риск назван «низким». Раздел карты, куда входит оценка биологической угрозы, включает также риски, связанные с использованием моделей компании для разработки химического, радиологического и ядерного оружия. При этом OpenAI уточнила, что при оценке рисков для o1 сосредоточилась именно на угрозе в части биологического оружия, поскольку эта область обладает «самым низким порогом для входа» в сравнении с остальными тремя. В то же время компания подчеркивает, что речь идет о риске такого несанкционированного использования лишь со стороны экспертов в области, поскольку для таких сложных задач нужны навыки работы в лаборатории, которые ИИ-модель пока заменить не может. Джинн из Пробирки - Подписаться

Технологии494 дня назад

Похожие новости

+2

+2

+8

+8

+2

+2

Стартап Humans привлек 480 млн долларов на создание ИИ для взаимодействия с людьми

Технологии

1 день назад

Дженсен Хуанг о возможностях ИИ: оптимизм для Европы и новые горизонты в IT

Технологии

1 день назад

+2

+2

Элон Маск о будущем ИИ и гуманоидных роботах на ВЭФ в Давосе

Технологии

22 часа назад

+8

+8

Глава Google DeepMind оценил отставание китайских ИИ от западных в полгода

Технологии

1 день назад

xAI разрабатывает эмуляторы человека, увольняя разработчика после раскрытия планов

Технологии

1 день назад

+2

+2

Эксперты оценили влияние ИИ на рынок труда в России

Общество

2 часа назад